Pentaho Report Designer でSpark のデータを連携利用

CData JDBC Driver for Spark のデータ を使えば、ダッシュボードやレポートからリアルタイムデータにアクセスできます。この記事では、Spark のデータにJDBC データソースとして接続し、Pentaho でSpark のデータをもとにしたレポートを公開する方法を説明します。

接続してレポートを作成

- インストールディレクトリのlib サブフォルダ内にあるドライバーのJAR ファイルを、Pentaho ディレクトリ内の\Report-Designer\lib\jdbc\ フォルダにコピーします。

- \Report-Designer\ フォルダ内のreport-designer.bat ファイルを実行してReport-Designer UI を開きます。

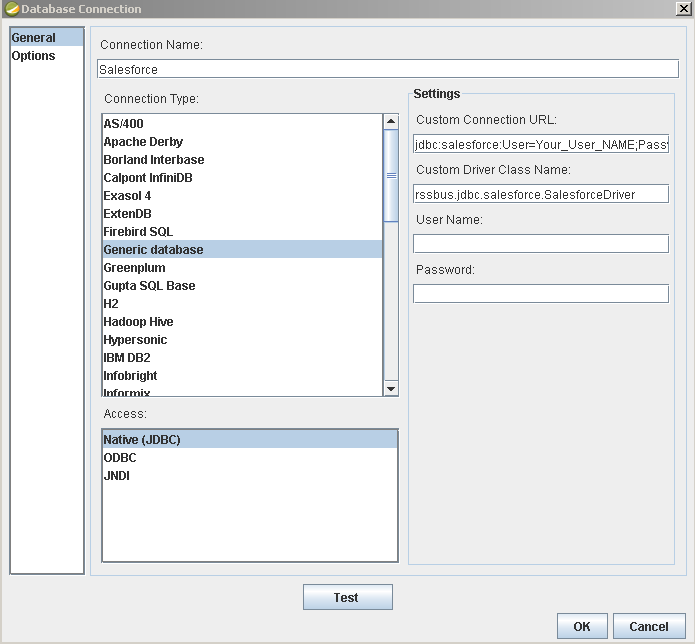

Data -> Add Data Source -> Advanced -> JDBC(Custom)をクリックし、新しいSpark 接続を作成して、ドライバーで新しいデータソースを作成します。 表示されるダイアログで、以下のように接続プロパティを設定します。

Custom Connection URL property:JDBC URL を入力します。JDBC URL はjdbc:sparksql: で始まり、その後にセミコロン区切りで接続プロパティを指定します。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

組み込みの接続文字列デザイナー

JDBC URL の構成については、Spark JDBC Driver に組み込まれている接続文字列デザイナーを使用してください。JAR ファイルをダブルクリックするか、コマンドラインからJAR ファイルを実行します。

java -jar cdata.jdbc.sparksql.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

JDBC URL を設定する際、Max Rows 接続プロパティの設定も検討してください。これにより返される行数が制限されます。特にレポートやビジュアライゼーションを設計する際のパフォーマンス向上に役立ちます。

一般的なJDBC URL は次のとおりです:

jdbc:sparksql:Server=127.0.0.1;

- Custom Driver Class Name:cdata.jdbc.sparksql.SparkSQLDriver を入力します。

- User Name:認証に使用するユーザー名。

- Password:認証に使用するパスワード。

レポートにSpark のデータを追加

Spark のデータをもとにレポートを作成する準備が整いました。

-

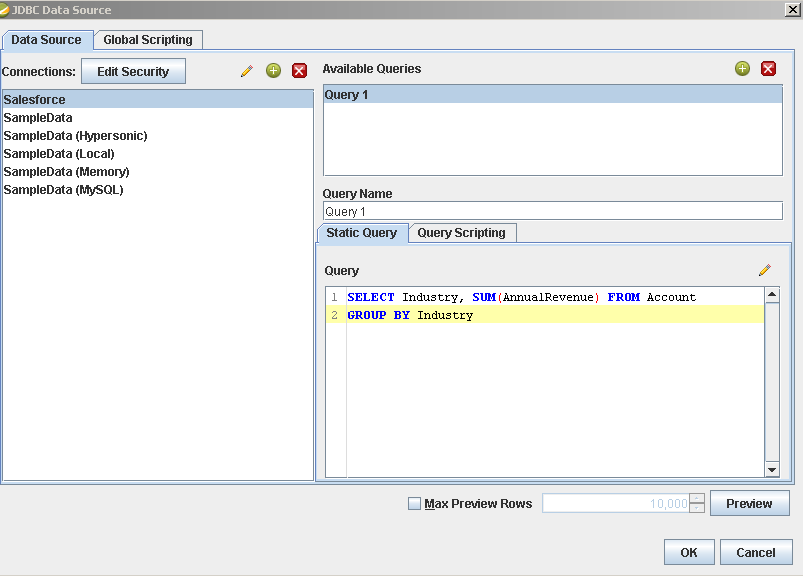

レポートにSpark のソースを追加します。Data -> Add Data Source -> JDBC をクリックしてデータソースを選択します。

クエリを設定します。この記事では以下のクエリを使用します:

SELECT City, Balance FROM Customers

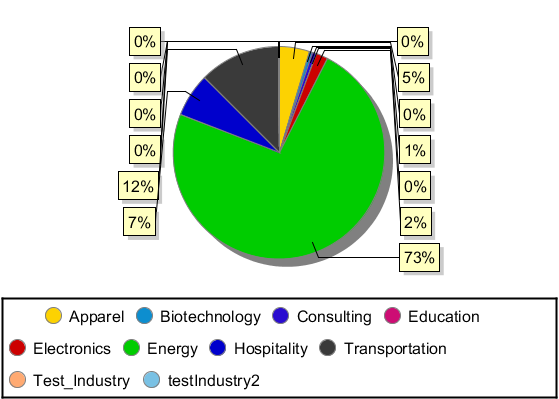

- レポートにチャートをドラッグし、ダブルクリックしてチャートを編集します。レポートを実行してチャートを表示します。このクエリの結果を使用して、Customers テーブルのシンプルなチャートを作成できます。

- 最後に、レポートを実行してチャートを確認します。