JDBC で Spark データソースから Informatica マッピングを作成

Informatica は、データの転送と変換を行う強力でエレガントな手段を提供します。CData JDBC Driver for Spark を使用することで、業界で実績のある標準に基づいたドライバーにアクセスでき、Informatica の強力なデータ転送および操作機能とシームレスに統合できます。このチュートリアルでは、Informatica PowerCenter で Spark のデータ を転送および参照する方法を説明します。

ドライバーのデプロイ

ドライバーを Informatica PowerCenter サーバーにデプロイするには、インストールディレクトリの lib サブフォルダにある CData JAR ファイルと .lic ファイルを、次のフォルダにコピーします:Informatica インストールディレクトリ\services\shared\jars\thirdparty。

Developer ツールで Spark のデータ を使用するには、インストールディレクトリの lib サブフォルダにある CData JAR ファイルと .lic ファイルを、次のフォルダにコピーする必要があります:

- Informatica インストールディレクトリ\client\externaljdbcjars

- Informatica インストールディレクトリ\externaljdbcjars

JDBC 接続の作成

Informatica Developer から接続するには、次の手順に従います:

- Connection Explorer ペインで、ドメインを右クリックし、Create a Connection をクリックします。

- 表示される New Database Connection ウィザードで、接続の名前と ID を入力し、Type メニューで JDBC を選択します。

- JDBC Driver Class Name プロパティに、次のように入力します:

cdata.jdbc.sparksql.SparkSQLDriver

- Connection String プロパティに、Spark の接続プロパティを使用して JDBC URL を入力します。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

組み込みの接続文字列デザイナー

JDBC URL の構築には、Spark JDBC Driver に組み込まれている接続文字列デザイナーを使用できます。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行します。

java -jar cdata.jdbc.sparksql.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

一般的な接続文字列は次のとおりです:

jdbc:sparksql:Server=127.0.0.1;

Spark テーブルの参照

ドライバー JAR をクラスパスに追加し、JDBC 接続を作成したら、Informatica で Spark エンティティにアクセスできます。Spark に接続してテーブルを参照するには、次の手順に従います:

- リポジトリに接続します。

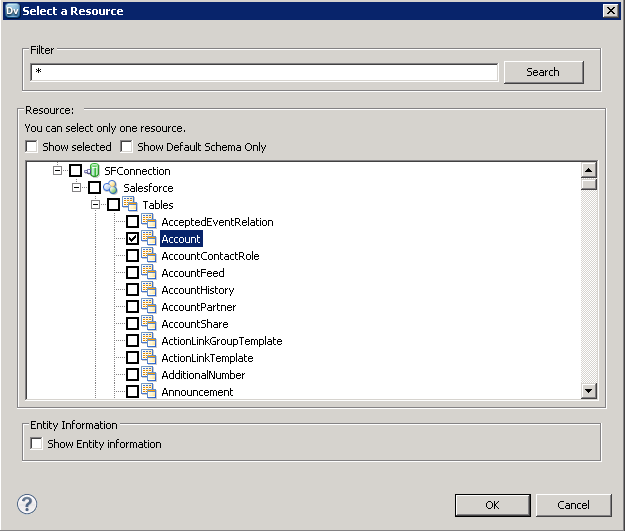

- Connection Explorer で、接続を右クリックし、Connect をクリックします。

- Show Default Schema Only オプションのチェックを外します。

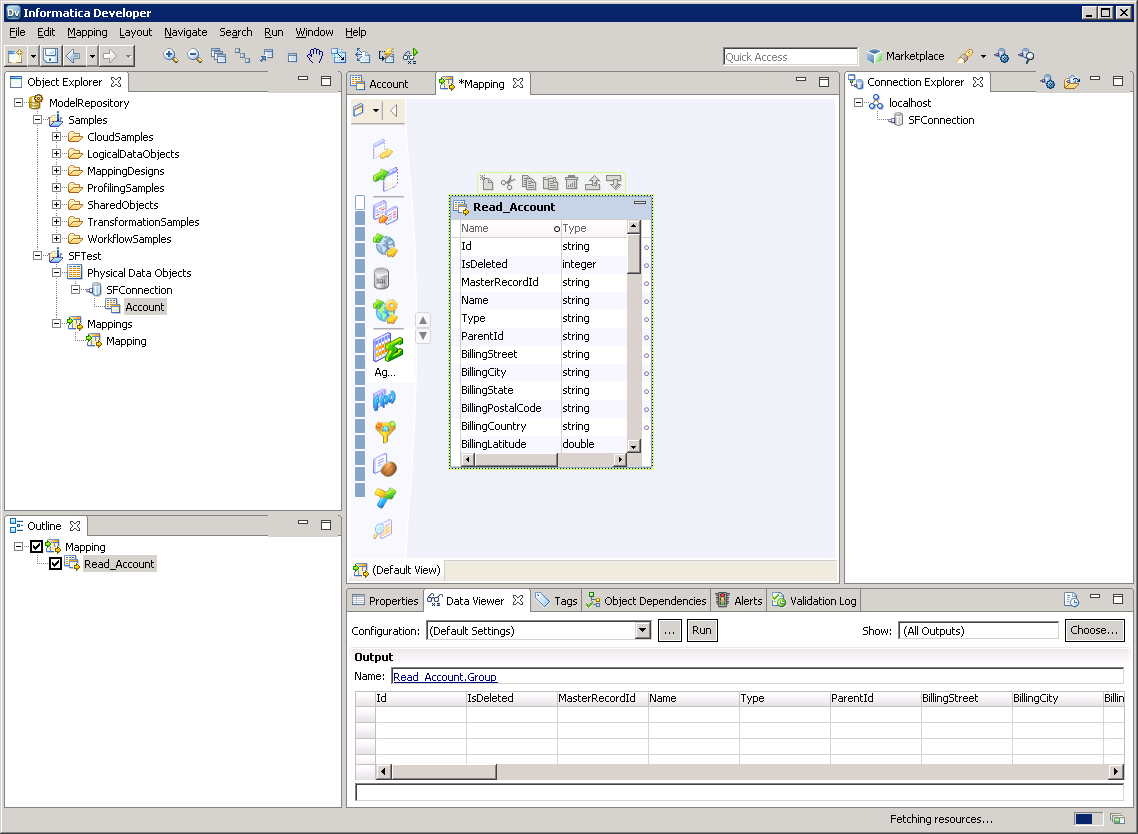

これで、Data Viewer で Spark テーブルを参照できます。テーブルのノードを右クリックし、Open をクリックします。Data Viewer ビューで、Run をクリックします。

Spark データオブジェクトの作成

プロジェクトに Spark テーブルを追加するには、次の手順に従います:

- Spark でテーブルを選択し、テーブルを右クリックして Add to Project をクリックします。

- 表示されるダイアログで、各リソースに対してデータオブジェクトを作成するオプションを選択します。

- Select Location ダイアログで、プロジェクトを選択します。

マッピングの作成

マッピングに Spark ソースを追加するには、次の手順に従います:

- Object Explorer で、プロジェクトを右クリックし、New -> Mapping をクリックします。

- Spark 接続のノードを展開し、テーブルのデータオブジェクトをエディターにドラッグします。

- 表示されるダイアログで、Read オプションを選択します。

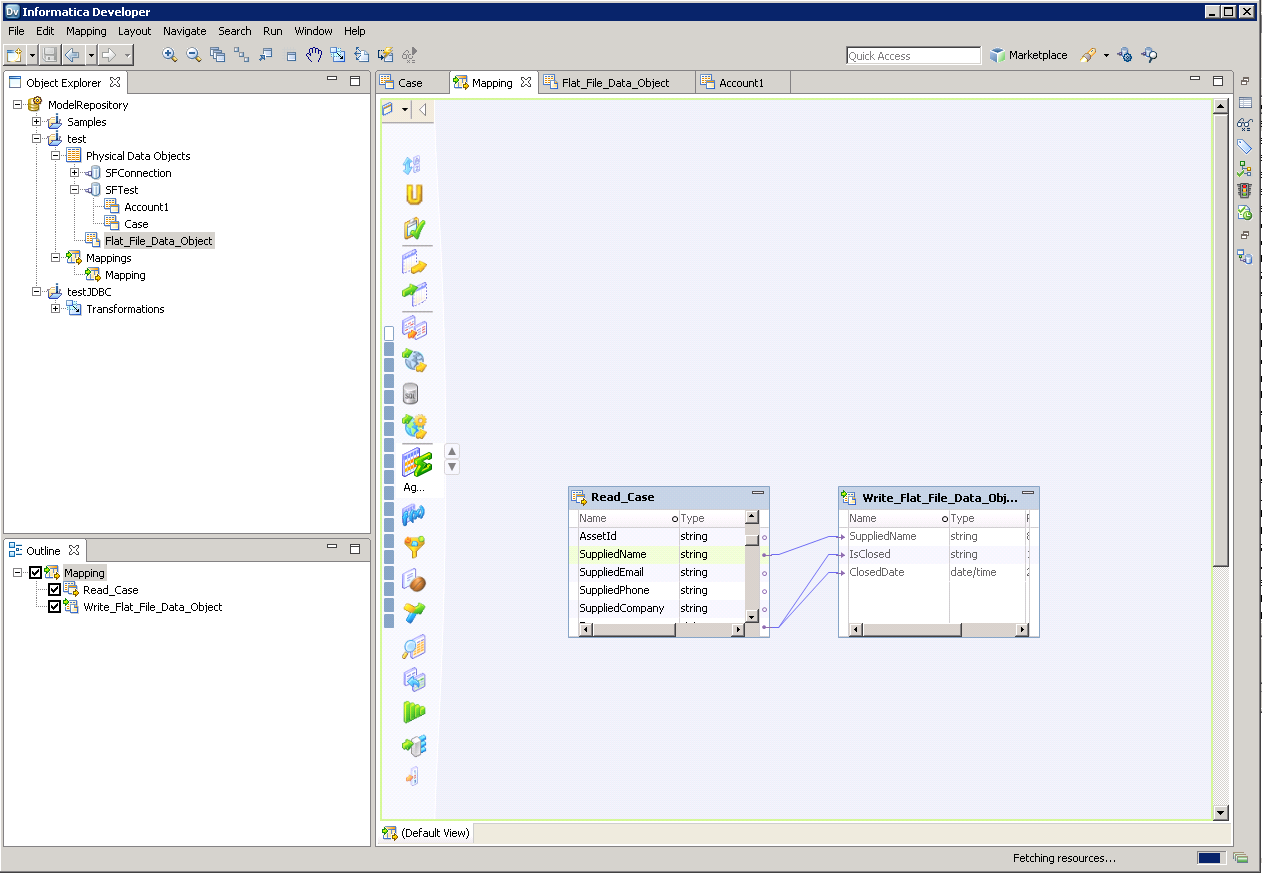

Spark カラムをフラットファイルにマッピングするには、次の手順に従います:

- Object Explorer で、プロジェクトを右クリックし、New -> Data Object をクリックします。

- Flat File Data Object -> Create as Empty -> Fixed Width を選択します。

- Spark オブジェクトのプロパティで、必要な行を選択し、右クリックして copy をクリックします。フラットファイルのプロパティに行を貼り付けます。

- フラットファイルデータオブジェクトをマッピングにドラッグします。表示されるダイアログで、Write オプションを選択します。

- クリック&ドラッグでカラムを接続します。

Spark のデータ を転送するには、ワークスペース内で右クリックし、Run Mapping をクリックします。