FineReport で Spark のデータ を利用する

CData JDBC Driver for Spark は、JDBC 標準を完全に実装しており、さまざまなBI、レポート、ETL ツール、カスタムアプリケーションに Spark のデータ への接続を提供します。この記事では、FineReport で Spark のデータ をJDBC データソースとして設定し、レポートデザイナーで Spark のデータ をテーブルとして表示する方法を説明します。

Spark のデータ のJDBC データソースをセットアップする

以下の手順に従って、FineReport のデータベース接続として Spark のデータ を設定します。

- CData JDBC Driver for Spark のインストールディレクトリにあるlib フォルダから、cdata.jdbc.sparksql.jar ファイルをFineReport のインストールディレクトリにあるlib フォルダにコピーします。cdata.jdbc.sparksql.lic ファイルも同様にコピーしてください。

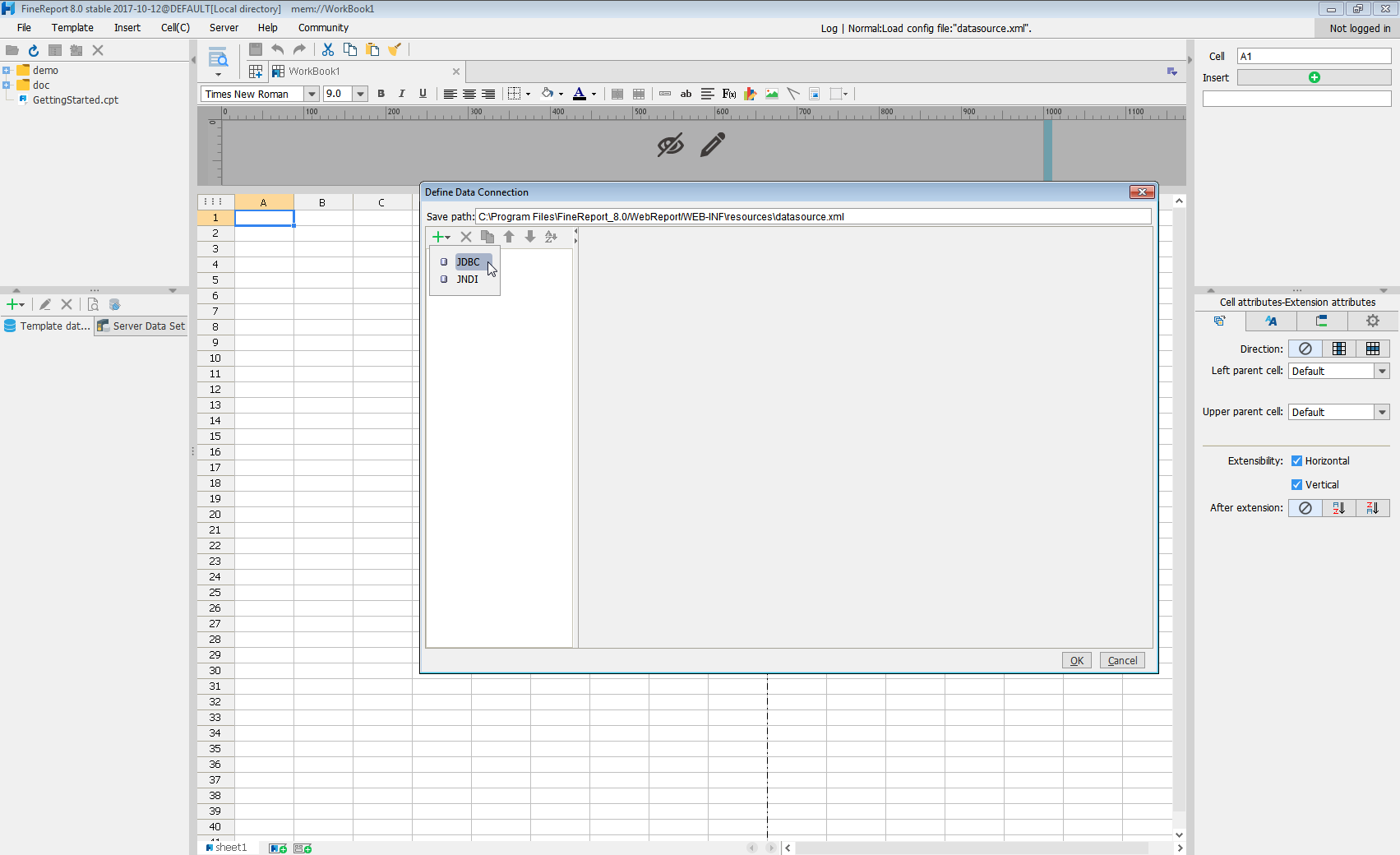

- ServerタブからDefine Data Connectionを選択し、クリックして新しい接続を追加してJDBCをクリックします。

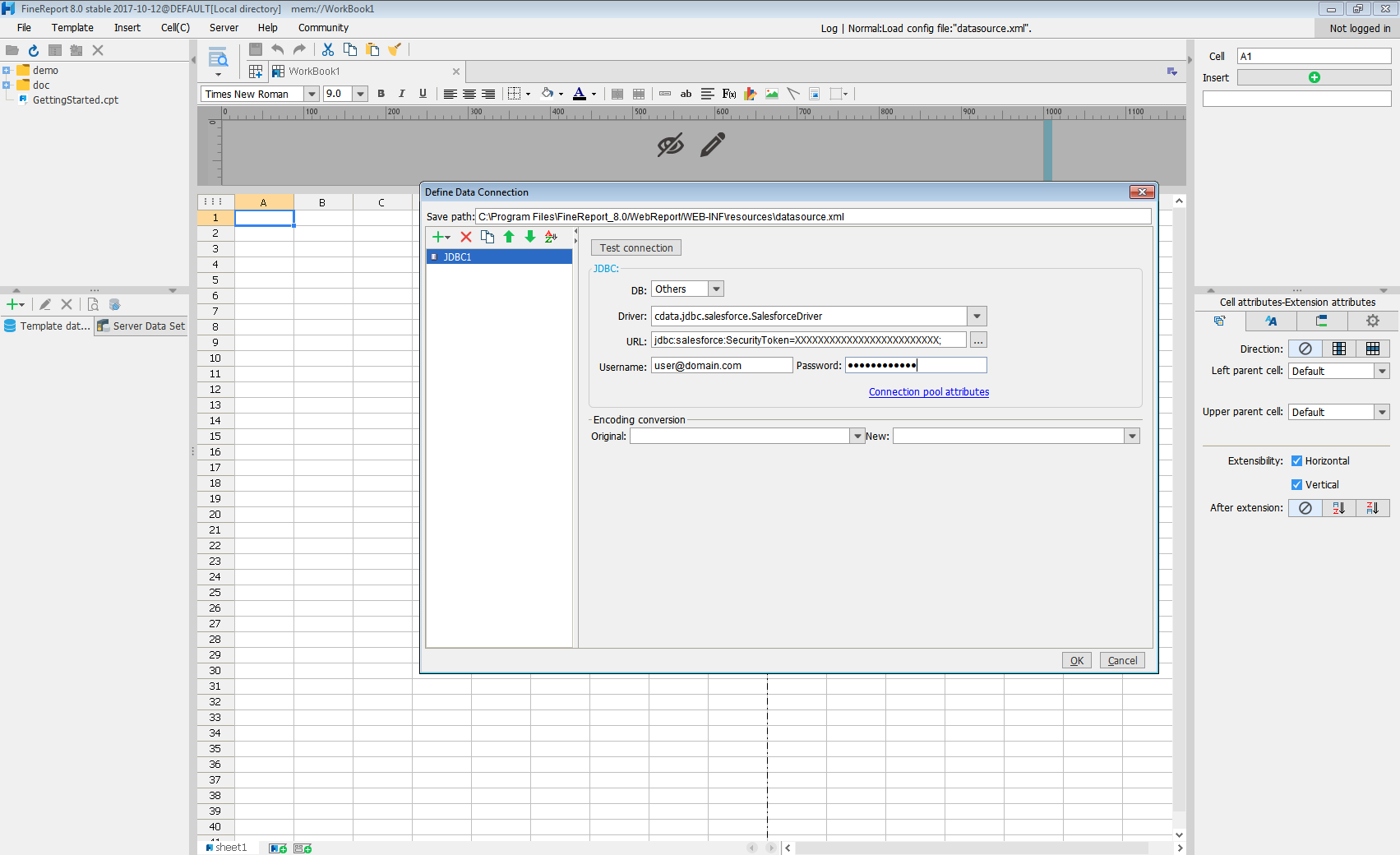

続いて、ウィンドウでデータ接続の定義を設定します。

- Database: Others

- JDBC Driver: cdata.jdbc.sparksql.SparkSQLDriver

-

URL: セミコロン区切りの接続プロパティを使用した標準のJDBC 接続文字列を入力します。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

組み込みの接続文字列デザイナー

JDBC URL の作成には、Spark JDBC Driver に組み込まれている接続文字列デザイナーを使用してください。JAR ファイルをダブルクリックするか、コマンドラインからjar ファイルを実行します。

java -jar cdata.jdbc.sparksql.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

JDBC URL を設定する際に、Max Rows 接続プロパティも設定しておくことをお勧めします。これにより、返される行数が制限されるため、レポートやビジュアライゼーションを設計する際のパフォーマンス向上に役立ちます。

JDBC URL の例を以下に示します。

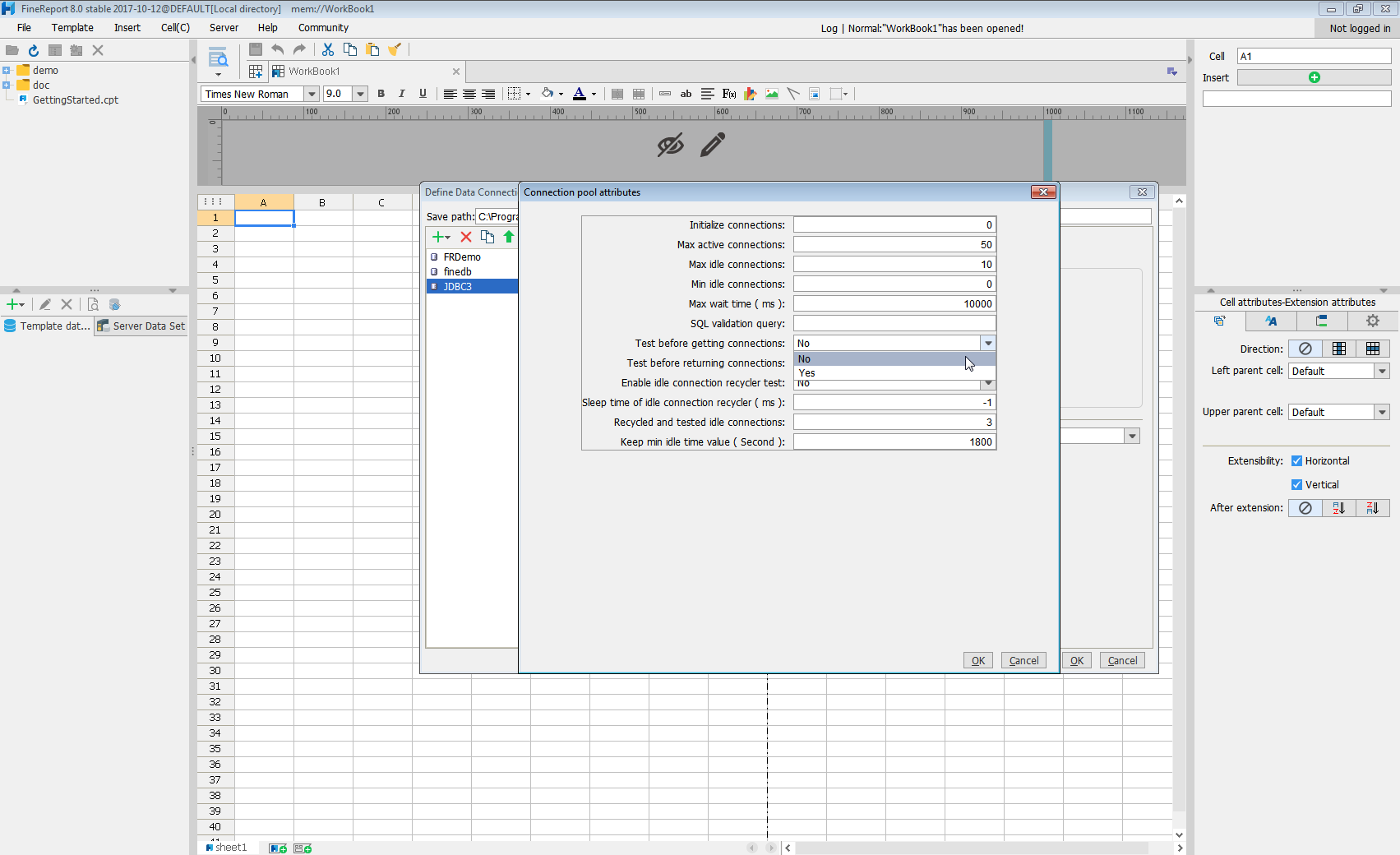

jdbc:sparksql:Server=127.0.0.1; - Connection pool attributesをクリックし、Test before getting connectionsをNoに設定します。

Test connectionをクリックして、接続が正しく設定されていることを確認します。これで、Spark への接続を設定し、FineReport のデータソースとして使用できるようになります。

レポートデザイナーで Spark のデータ を選択する

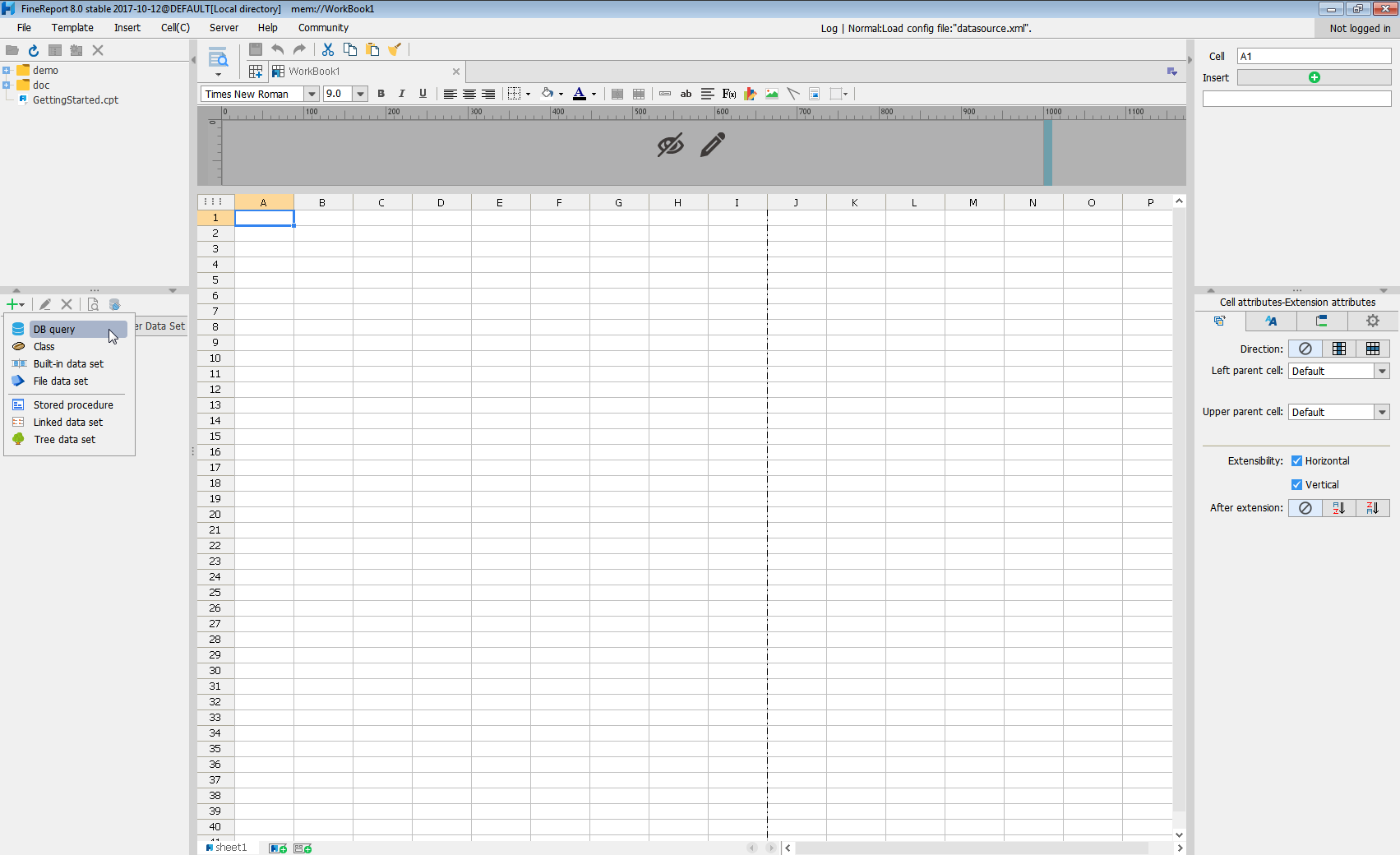

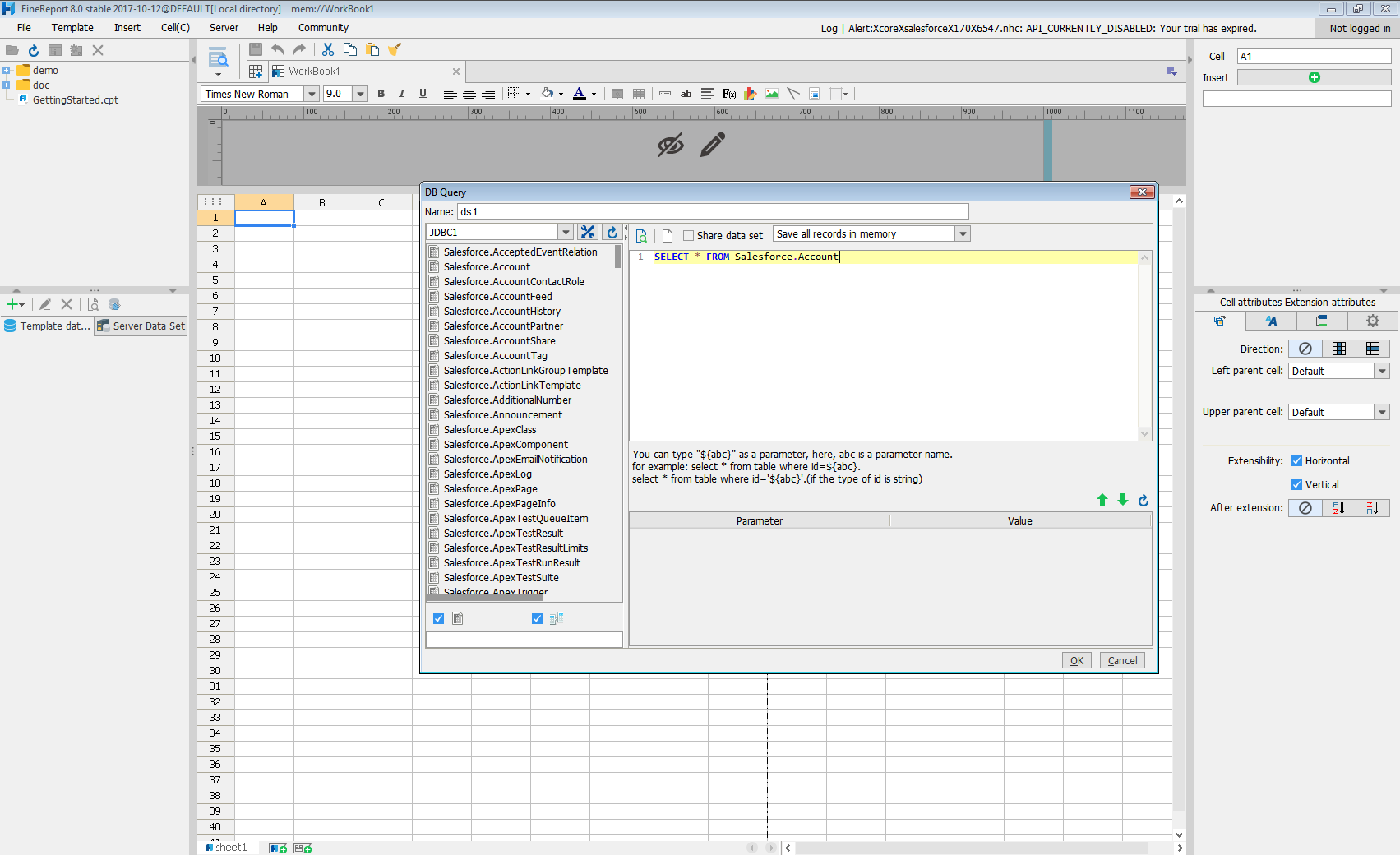

- クリックして新しいテンプレートデータセットを追加し、DB queryを選択してデータベースクエリウィンドウを開きます。

- ドロップダウンリストから、作成したJDBC 接続を選択します。

- 左ペインにSpark のエンティティがテーブルとして表示されます。

- ロードするSpark のデータ のテーブルとカラムに対してSELECT 文を記述します。

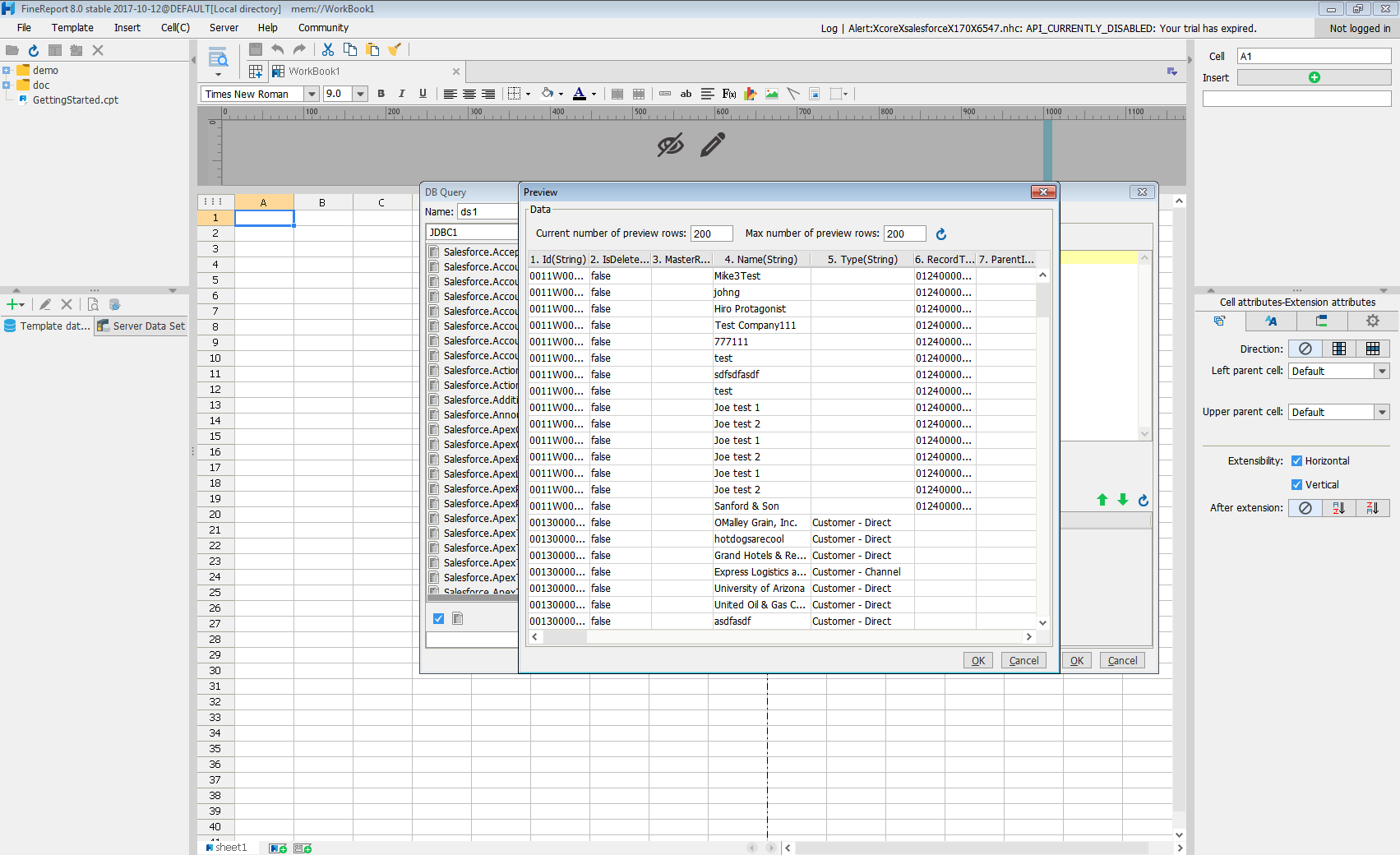

- プレビューをクリックすると、データがテーブルとして表示されます。

このように簡単な手順で、FineReport で Spark をJDBC データソースとして利用できるようになります。