Apache Solr にSnowflake のデータをインポートする方法

Apache Solr は、Apache Lucene 上に構築された人気のある高速なオープンソースのエンタープライズサーチソリューションです。

Apache Solr には、データベースやXML、CSV、JSON ファイルからデータをインポートできるData Import Handler(DIH)が搭載されています。CData JDBC Driver for Snowflake と組み合わせることで、Snowflake のデータを簡単にApache Solr にインポートできます。この記事では、CData JDBC Driver をApache Solr のData Import Handler で使用し、エンタープライズサーチ用にSnowflake のデータをインポートする方法をステップバイステップで解説します。

Snowflake データ連携について

CData は、Snowflake のライブデータへのアクセスと統合を簡素化します。お客様は CData の接続機能を以下の目的で活用しています:

- Snowflake データを迅速かつ効率的に読み書きできます。

- 指定された Warehouse、Database、Schema のメタデータを動的に取得できます。

- OAuth、OKTA、Azure AD、Azure マネージド サービス ID、PingFederate、秘密鍵など、さまざまな方法で認証できます。

多くの CData ユーザーは、CData ソリューションを使用して、お気に入りのツールやアプリケーションから Snowflake にアクセスし、さまざまなシステムからデータを Snowflake にレプリケートして、包括的なウェアハウジングと分析を行っています。

CData ソリューションとの Snowflake 統合についての詳細は、ブログをご覧ください:https://jp.cdata.com/blog/snowflake-integrations

はじめに

Snowflake インポート用のApache Solr コアとスキーマを作成する

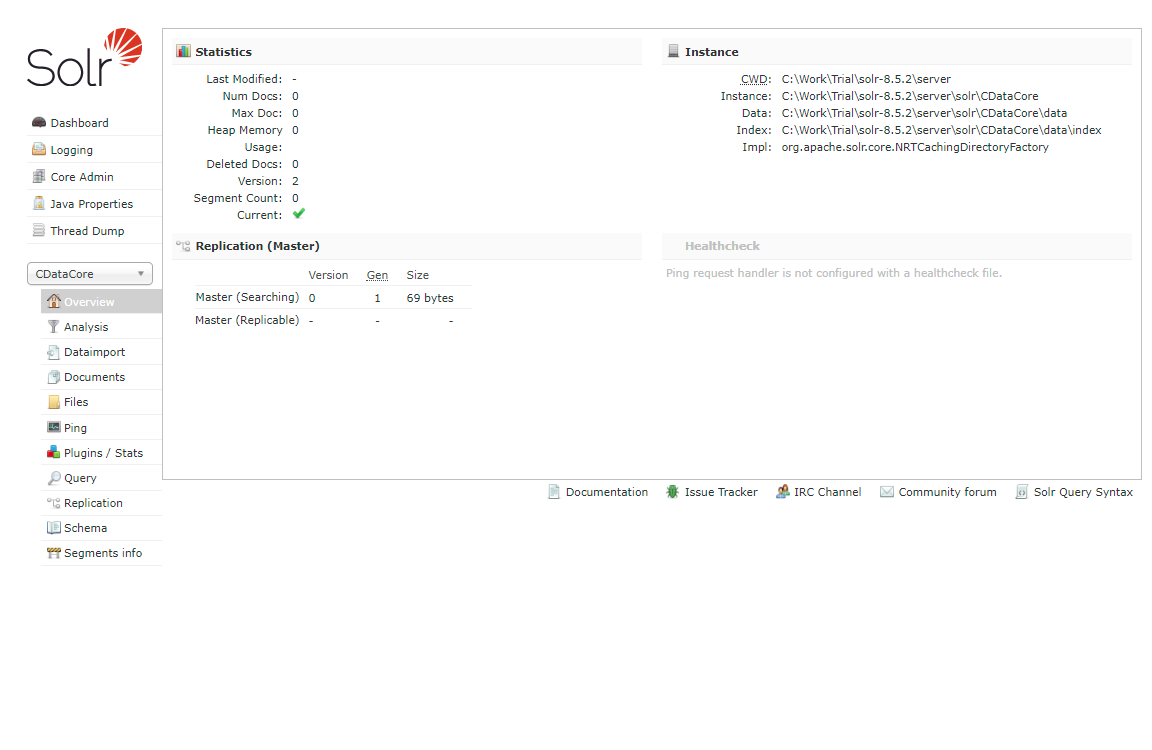

- Apache Solr を起動し、コアを作成します。

> solr create -c CDataCore

この記事では、Solr はローカル環境でスタンドアロンインスタンスとして実行されており、次のURL でコアにアクセスできます:http://localhost:8983/solr/#/CDataCore/core-overview - インポートするSnowflake のデータのカラムを表す「field」オブジェクトと、エンティティの一意キーで構成されるスキーマを作成します。Snowflake にLastModifiedDate が存在する場合は、増分更新に使用されます。存在しない場合は、後述のdeltaquery を実行できません。スキーマはApache Solr が作成したmanaged-schema ファイルに保存します。

- CData Snowflake JDBC Driver をインストールします。JAR ファイルとライセンスファイル(cdata.snowflake.jar とcdata.jdbc.snowflake.lic)をSolr ディレクトリにコピーします。

- CData JDBC JAR ファイル:C:\Program Files\CData\CData JDBC Driver for Snowflake ####\lib

- Apache Solr:solr-8.5.2\server\lib

SnowflakeUniqueKey

これで、Solr でSnowflake のデータを使用する準備が整いました。

Snowflake からApache Solr へのインポートを定義する

このセクションでは、Data Import Handler の設定手順を説明します。

- 作成したコアのConfig ファイルを編集します。JAR ファイルの参照を追加し、DIH RequestHandler の定義を追加します。

<lib dir="${solr.install.dir:../../../..}/dist/" regex="solr-dataimporthandler-.*\.jar" /> <requestHandler name="/dataimport" class="org.apache.solr.handler.dataimport.DataImportHandler"> <lst name="defaults"> <str name="config">solr-data-config.xml</str> </lst> </requestHandler> - 次に、同じ階層にsolr-data-config.xml を作成します。この記事ではSnowflake からテーブルを取得しますが、カスタムSQL クエリを使用してデータをリクエストすることもできます。Driver クラスとサンプルJDBC 接続文字列は以下のサンプルコードにあります。

<dataConfig> <dataSource driver="cdata.jdbc.snowflake.SnowflakeDriver" url="jdbc:snowflake:User=Admin;Password=test123;Server=localhost;Database=Northwind;Warehouse=TestWarehouse;Account=Tester1;"> </dataSource> <document> <entity name="Products" query="SELECT Id,SnowflakeColumn1,SnowflakeColumn2,SnowflakeColumn3,SnowflakeColumn4,SnowflakeColumn5,SnowflakeColumn6,SnowflakeColumn7,LastModifiedDate FROM Products" deltaQuery="SELECT Id FROM Products where LastModifiedDate >= '${dataimporter.last_index_time}'" deltaImportQuery="SELECT Id,SnowflakeColumn1,SnowflakeColumn2,SnowflakeColumn3,SnowflakeColumn4,SnowflakeColumn5,SnowflakeColumn6,SnowflakeColumn7,LastModifiedDate FROM Products where Id=${dataimporter.delta.Id}"> <field column="Id" name="Id" ></field> <field column="SnowflakeColumn1" name="SnowflakeColumn1" ></field> <field column="SnowflakeColumn2" name="SnowflakeColumn2" ></field> <field column="SnowflakeColumn3" name="SnowflakeColumn3" ></field> <field column="SnowflakeColumn4" name="SnowflakeColumn4" ></field> <field column="SnowflakeColumn5" name="SnowflakeColumn5" ></field> <field column="SnowflakeColumn6" name="SnowflakeColumn6" ></field> <field column="SnowflakeColumn7" name="SnowflakeColumn7" ></field> <field column="LastModifiedDate" name="LastModifiedDate" ></field> </entity> </document> </dataConfig> - query セクションで、Snowflake からデータを選択するSQL クエリを設定します。deltaQuery とdeltaImportquery は、同じエンティティの2回目以降のインポートで増分更新を使用する際のID と条件を定義します。

- すべての設定が完了したら、Solr を再起動します。

> solr stop -all > solr start

Snowflake のデータのDataImport を実行する

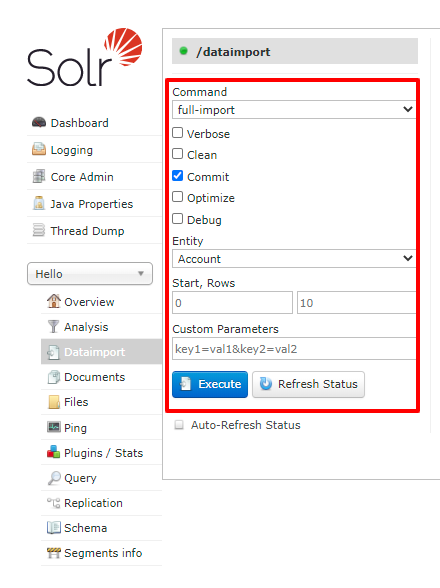

- 以下のURL からDataImport を実行します:

http://localhost:8983/solr/#/CDataCore/dataimport//dataimport

- 「full-import」コマンドを選択し、Entity からテーブルを選択して、「Execute」をクリックします。

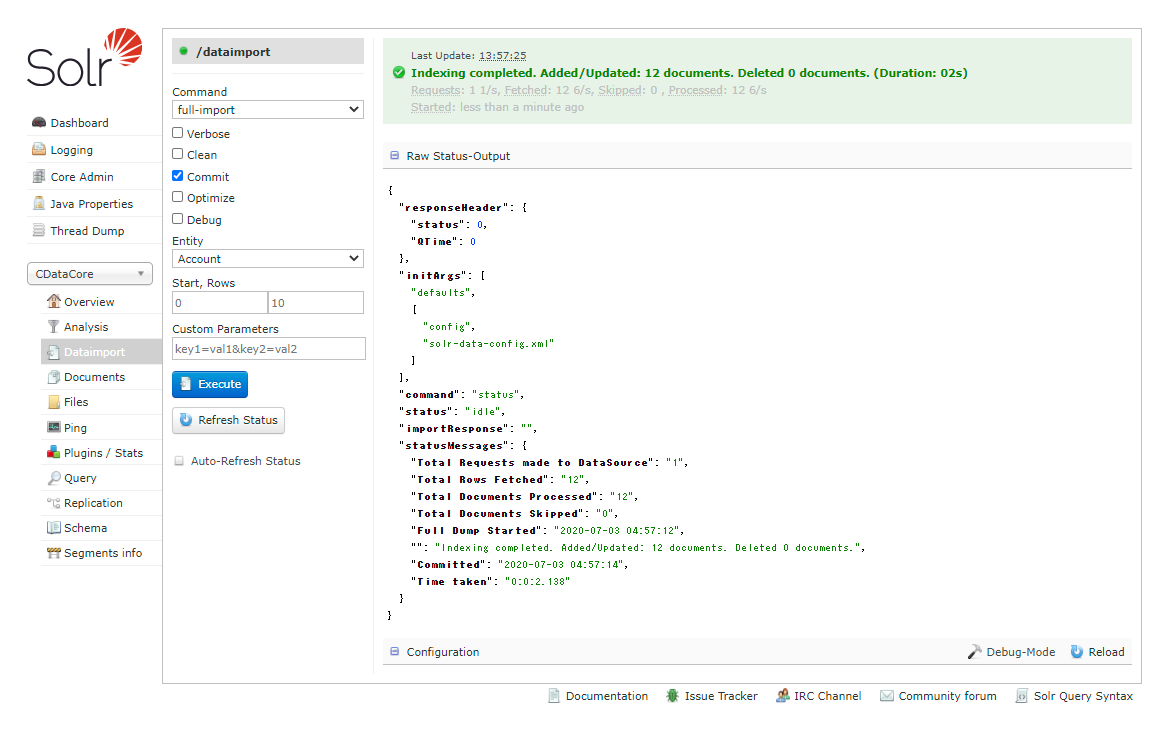

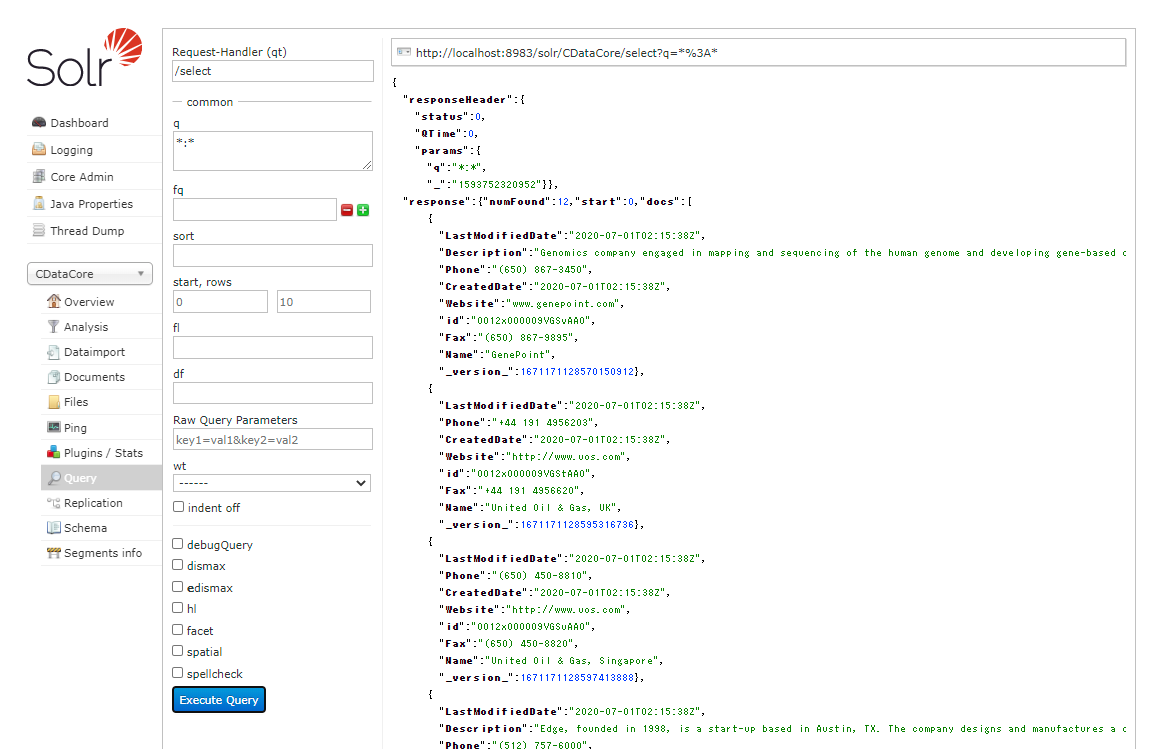

- Query からインポート結果を確認します。

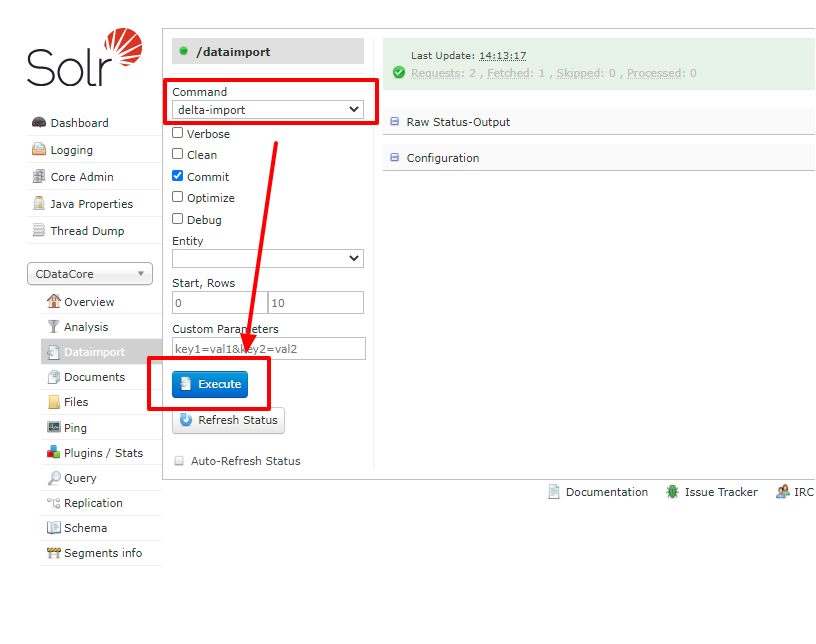

- deltaQuery を使用した増分更新を試してみましょう。元のSnowflake データセットのデータを変更します。DataImport ウィンドウから今度は「delta-import」コマンドを選択し、「Execute」をクリックします。

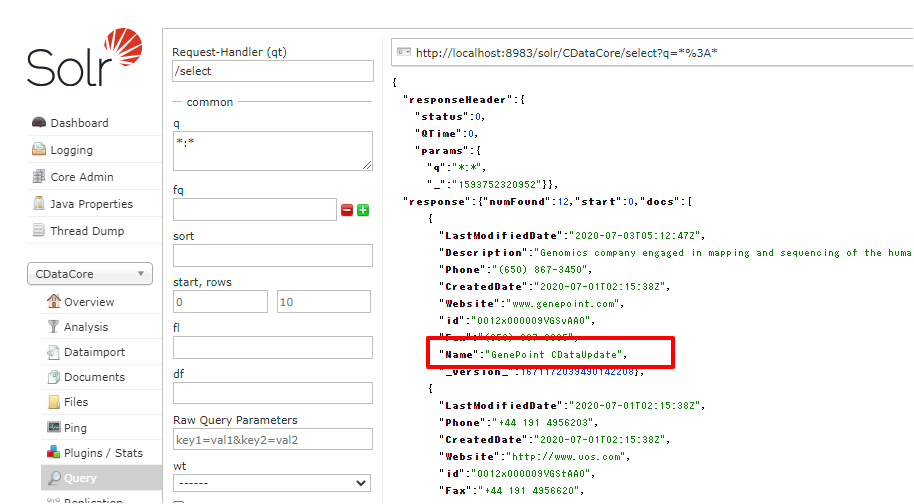

- 増分更新の結果を確認します。

CData JDBC Driver for Snowflake を使用することで、Snowflake のデータのApache Solr への自動インポートを作成できます。250+ のCData JDBC Driver の無料30日間トライアルをダウンロードして、今すぐ始めましょう。