Google Data Fusion で SAS xpt に連携した ETL プロセスを作成

Google Data Fusion を使用すると、セルフサービス型のデータ連携を行い、異なるデータソースを統合できます。CData JDBC Driver for SASxpt をアップロードすることで、Google Data Fusion のパイプライン内から SAS xpt のデータ にリアルタイムでアクセスできるようになります。CData JDBC Driver を使用すると、SAS xpt のデータ を Google Data Fusion でネイティブにサポートされている任意のデータソースにパイプできますが、この記事では、SAS xpt から Google BigQuery へデータをパイプする方法を説明します。

CData JDBC Driver for SASxpt を Google Data Fusion にアップロード

CData JDBC Driver for SASxpt を Google Data Fusion インスタンスにアップロードして、SAS xpt のデータ にリアルタイムでアクセスしましょう。Google Data Fusion では JDBC ドライバーの命名規則に制限があるため、JAR ファイルを driver-version.jar という形式に合わせてコピーまたはリネームしてください。例:cdatasasxpt-2020.jar

- Google Data Fusion インスタンスを開きます

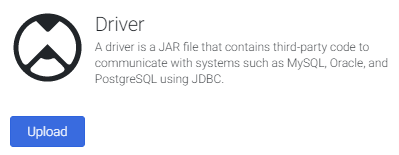

- をクリックしてエンティティを追加し、ドライバーをアップロードします

- "Upload driver" タブで、リネームした JAR ファイルをドラッグまたは参照します。

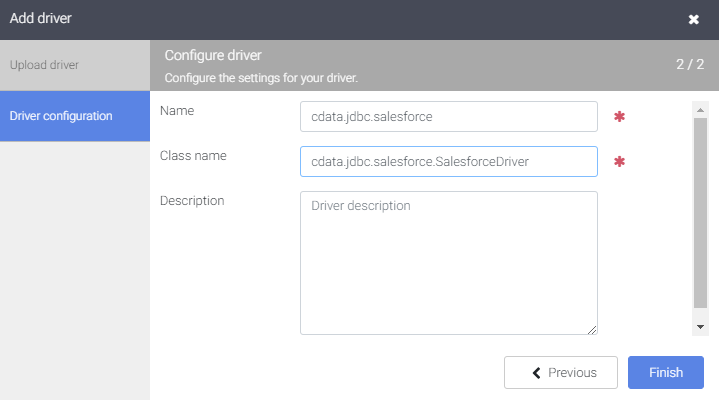

- "Driver configuration" タブで以下を設定します:

- Name: ドライバーの名前(cdata.jdbc.sasxpt)を作成し、メモしておきます

- Class name: JDBC クラス名を設定します:(cdata.jdbc.sasxpt.SASXptDriver)

- "Finish" をクリックします

Google Data Fusion で SAS xpt のデータ に接続

JDBC Driver をアップロードしたら、Google Data Fusion のパイプラインで SAS xpt のデータ にリアルタイムでアクセスできます。

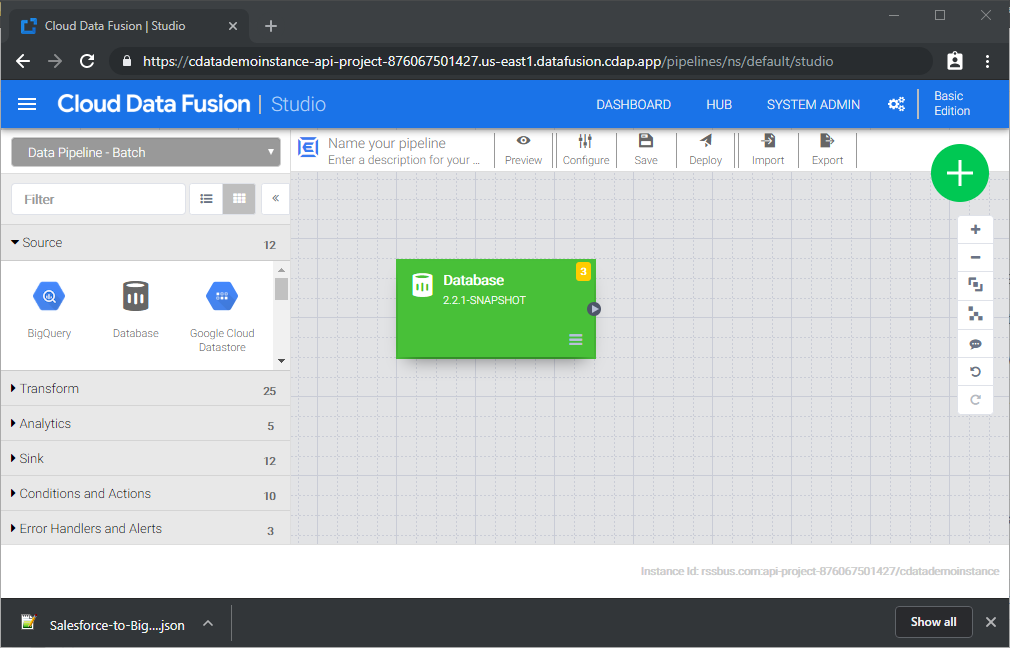

- Pipeline Studio に移動して、新しいパイプラインを作成します

- "Source" オプションから "Database" をクリックして、JDBC Driver 用のソースを追加します

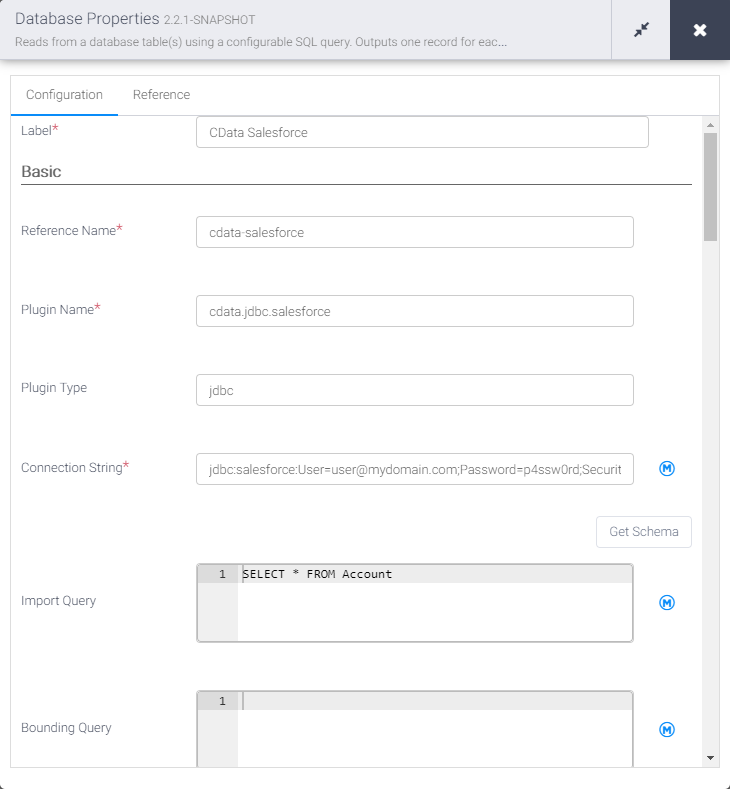

- Database ソースの "Properties" をクリックしてプロパティを編集します

NOTE:Google Data Fusion で JDBC Driver を使用するには、ライセンス(製品版またはトライアル)とランタイムキー(RTK)が必要です。ライセンス(またはトライアル)の取得については、CData までお問い合わせください。

- Label を設定します

- Reference Name を将来の参照用の値に設定します(例:cdata-sasxpt)

- Plugin Type を "jdbc" に設定します

- Connection String を SAS xpt の JDBC URL に設定します。例:

jdbc:sasxpt:RTK=5246...;URI=C:/folder;ローカルSASXpt ファイルへの接続

URI をSASXpt ファイルを格納しているフォルダに設定すると、ローカルのSASXpt ファイルに接続できます。

S3 データソースへの接続

Amazon S3 ソースに接続してSASXpt ファイルを読み込むことができます。以下のプロパティを設定して接続します:

- URI:接続するバケット内のフォルダに設定。

- AWSAccessKey:AWS アカウントのアクセスキーに設定。

- AWSSecretKey:AWS アカウントのシークレットキーに設定。

- TemporaryLocalFolder:SASXptファイルを一時的にダウンロードするために使用するフォルダへのパス、またはURI に設定。

Azure Data Lake Storage Gen2 への接続

ADLS Gen2 に接続してSASXpt ファイルを読み込むことができます。以下のプロパティを設定して接続します:

- URI:ファイルシステムの名前およびSASXpt ファイルにコンタクトするフォルダの名前に設定。

- AzureAccount:Azure Data Lake storage アカウントの名前に設定。

- AzureAccessKey:Azure Data Lake storage Gen 2 ストレージアカウントのアクセスキーに設定。

- TemporaryLocalFolder:SASXptファイルを一時的にダウンロードするために使用するフォルダへのパス、またはURI に設定。

ビルトイン接続文字列デザイナー

JDBC URL の作成には、SAS xpt JDBC Driver に組み込まれている接続文字列デザイナーを使用できます。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行してください。

java -jar cdata.jdbc.sasxpt.jar接続プロパティを入力し、接続文字列をクリップボードにコピーします。

- Import Query を SAS xpt から取得したいデータを抽出する SQL クエリに設定します。例:

SELECT * FROM SampleTable_1

- "Sink" タブから、同期先シンクを追加します(この例では Google BigQuery を使用します)

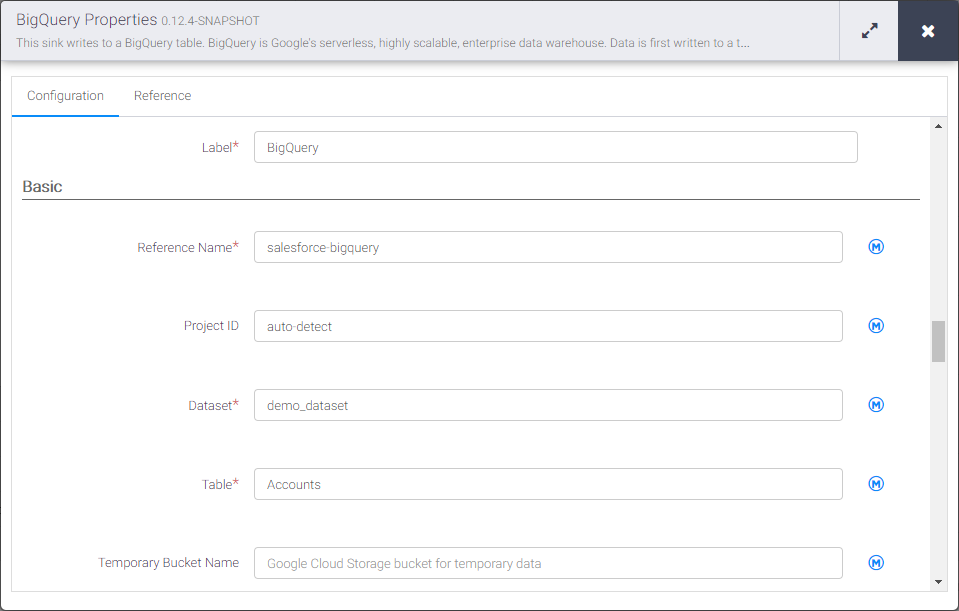

- BigQuery シンクの "Properties" をクリックしてプロパティを編集します

- Label を設定します

- Reference Name を sasxpt-bigquery のような値に設定します

- Project ID を特定の Google BigQuery プロジェクト ID に設定します(またはデフォルトの "auto-detect" のままにします)

- Dataset を特定の Google BigQuery データセットに設定します

- Table を SAS xpt のデータ を挿入するテーブル名に設定します

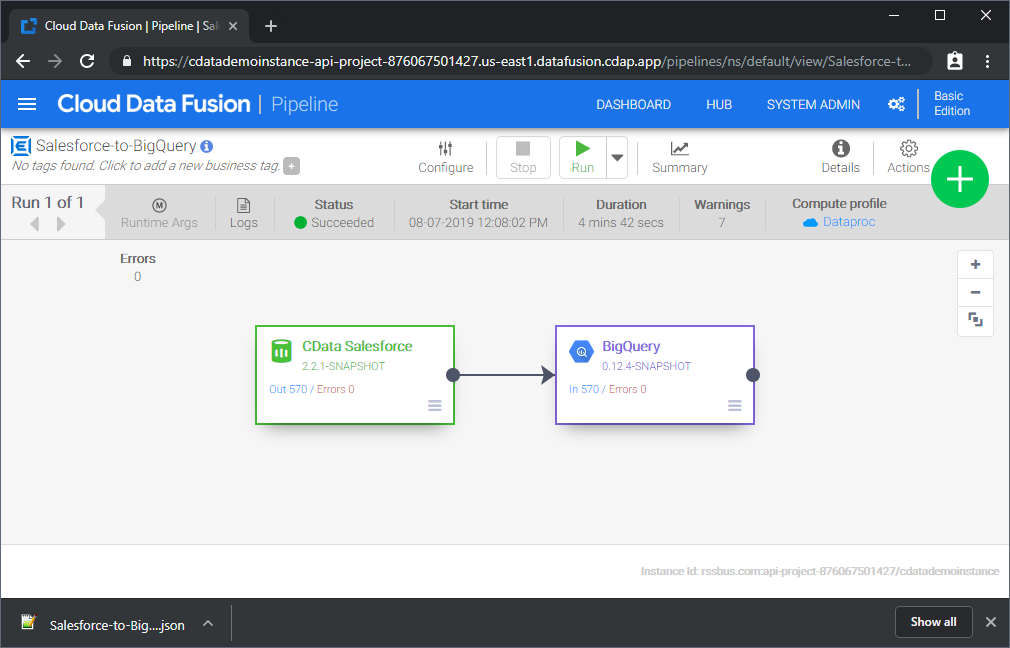

Source と Sink を設定すると、SAS xpt のデータ を Google BigQuery にパイプする準備が整います。パイプラインを保存してデプロイしてください。パイプラインを実行すると、Google Data Fusion が SAS xpt からリアルタイムデータをリクエストし、Google BigQuery にインポートします。

これはシンプルなパイプラインの例ですが、変換、分析、条件などを使用してより複雑な SAS xpt パイプラインを作成できます。CData JDBC Driver for SASxpt の 30日間の無償トライアルをダウンロードして、今すぐ Google Data Fusion で SAS xpt のデータ をリアルタイムで活用しましょう。