HULFT Integrate で Kafka のデータ に接続

HULFT Integrate は、ドラッグ&ドロップのユーザーインターフェースでコーポレーションフロー、データ変換、処理を簡単に作成できる最新のデータ連携プラットフォームです。CData JDBC Driver for Apache Kafka と組み合わせることで、HULFT Integrate からリアルタイムの Kafka のデータ を扱うことができます。この記事では、Kafka への接続方法と、データを CSV ファイルに出力する手順をご紹介します。

CData JDBC ドライバーは、最適化されたデータ処理機能を備えており、リアルタイムの Kafka のデータ との連携において比類のないパフォーマンスを発揮します。Kafka に対して複雑な SQL クエリを発行すると、ドライバーはフィルタや集計などのサポートされている SQL 操作を直接 Kafka にプッシュし、サポートされていない操作(主に SQL 関数や JOIN 操作)は内蔵の SQL エンジンでクライアント側で処理します。また、動的なメタデータクエリ機能により、ネイティブなデータ型を使用して Kafka のデータ を操作・分析できます。

Kafka へのアクセスを有効化

HULFT Integrate プロジェクトから Kafka のデータ へのアクセスを有効にするには、以下の手順で設定します:

- CData JDBC Driver の JAR ファイル(およびライセンスファイルがある場合はそれも)、cdata.jdbc.apachekafka.jar(および cdata.jdbc.apachekafka.lic)を、Integrate Server の jdbc_adapter サブフォルダにコピーします

- HULFT Integrate Server を再起動し、HULFT Integrate Studio を起動します

Kafka のデータ にアクセスするプロジェクトの作成

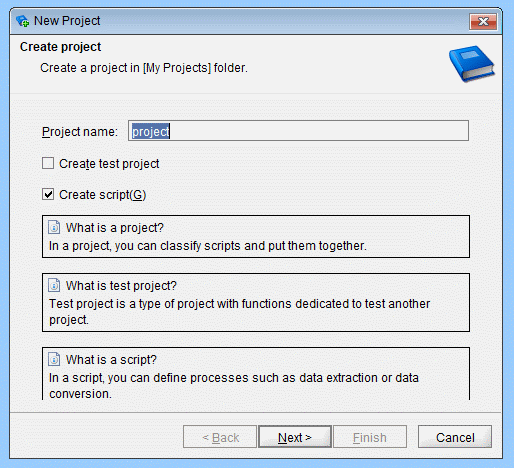

JAR ファイルをコピーしたら、Kafka のデータ にアクセスするプロジェクトを作成できます。まず、Integrate Studio を開いて新しいプロジェクトを作成しましょう。

- プロジェクト名を入力します

- 「スクリプトを作成」チェックボックスがオンになっていることを確認します

- 「次へ」をクリックします

- スクリプト名を入力します(例:ApacheKafkatoCSV)

プロジェクトを作成したら、Kafka のデータ を CSV ファイルにコピーするためのコンポーネントをスクリプトに追加します。

Execute Select SQL コンポーネントの設定

ツールパレット(Database -> JDBC)から「Execute Select SQL」コンポーネントをスクリプトワークスペースにドラッグします。

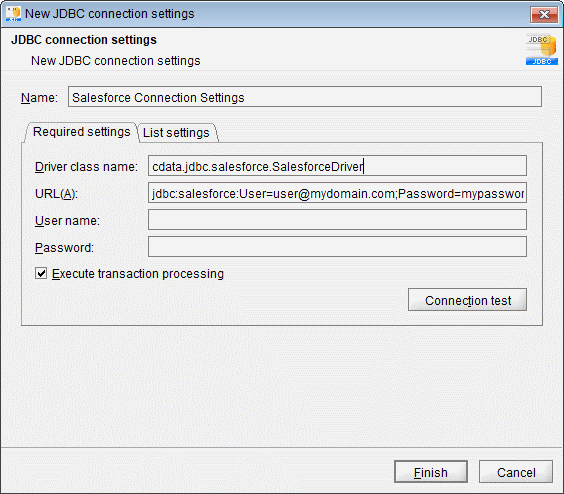

- 「必須設定」タブの接続先で、「追加」をクリックして Kafka 用の新しい接続を作成します。以下のプロパティを設定します:

- 名前:Kafka Connection Settings

- ドライバークラス名:cdata.jdbc.apachekafka.ApacheKafkaDriver

- URL:jdbc:apachekafka:User=admin;Password=pass;BootStrapServers=https://localhost:9091;Topic=MyTopic;

組み込みの接続文字列デザイナー

JDBC URL の構築には、Kafka JDBC Driver に組み込まれている接続文字列デザイナーをご利用ください。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行します。

java -jar cdata.jdbc.apachekafka.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

Apache Kafka 接続プロパティの取得・設定方法

それでは、Apache Kafka に接続していきましょう。.NET ベースのエディションは、Confluent.Kafka およびlibrdkafka ライブラリに依存して機能します。 これらのアセンブリはインストーラーにバンドルされており、CData 製品と一緒に自動的にインストールされます。 別のインストール方法をご利用の場合は、NuGet から依存関係のあるConfluent.Kafka 2.6.0をインストールしてください。

Apache Kafka サーバーのアドレスを指定するには、BootstrapServers パラメータを使用します。

デフォルトでは、CData 製品はデータソースとPLAINTEXT で通信しており、これはすべてのデータが暗号化なしで送信されることを意味します。 通信を暗号化したい場合は、以下の設定を行ってください:

- UseSSL をtrue に設定し、CData 製品がSSL 暗号化を使用するように構成します

- SSLServerCert およびSSLServerCertType を設定して、サーバー証明書をロードします

Apache Kafka への認証

続いて、認証方法を設定しましょう。Apache Kafka データソースでは、以下の認証方法をサポートしています:

- Anonymous

- Plain

- SCRAM ログインモジュール

- SSL クライアント証明書

- Kerberos

Anonymous 認証

Apache Kafka の特定のオンプレミスデプロイメントでは、認証接続プロパティを設定することなくApache Kafka に接続できます。 このような接続はanonymous(匿名)と呼ばれます。

匿名認証を行うには、以下のプロパティを設定してください。

- AuthScheme:None

その他の認証方法については、ヘルプドキュメントをご確認ください。

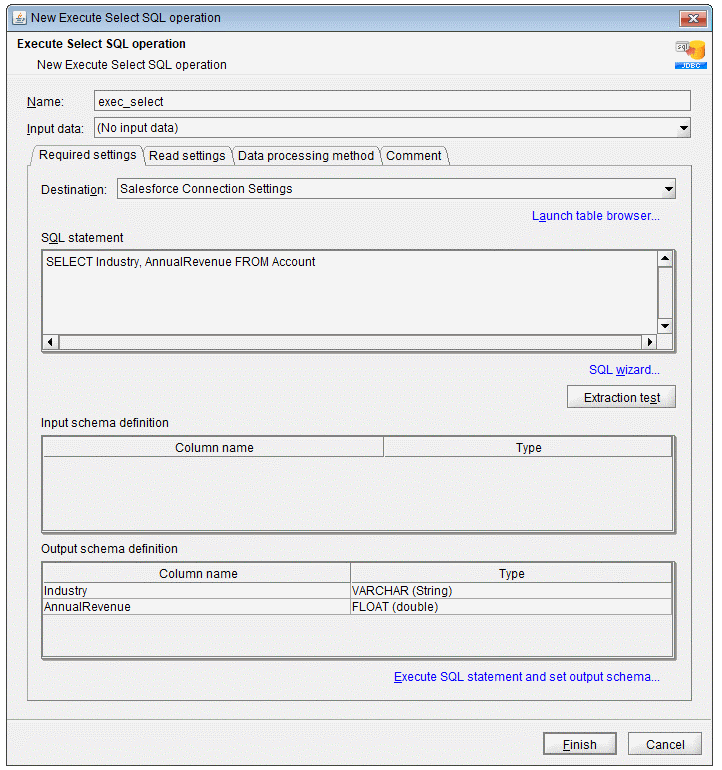

- SQL ステートメントを記述します。例:

SELECT Id, Column1 FROM SampleTable_1

- 「抽出テスト」をクリックして、接続とクエリが正しく設定されていることを確認します

- 「SQL を実行して出力スキーマを設定」をクリックします

- 「完了」をクリックします

Write CSV File コンポーネントの設定

ツールパレット(File -> CSV)から「Write CSV File」コンポーネントをワークスペースにドラッグします。

- クエリ結果を書き込むファイルを設定します(例:SampleTable_1.csv)

- 「入力データ」を「Select SQL」コンポーネントに設定します

- SQL クエリで選択した各フィールドのカラムを追加します

- 「書き込み設定」タブで、「最初の行にカラム名を挿入する」チェックボックスをオンにします

- 「完了」をクリックします

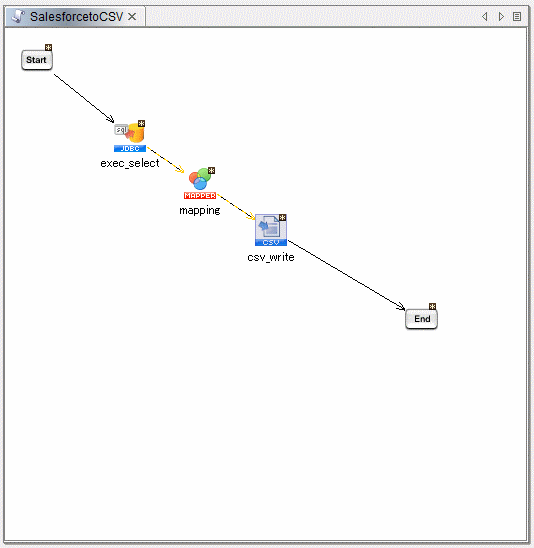

Kafka フィールドを CSV カラムにマッピング

「Select」コンポーネントの各カラムを、「CSV」コンポーネントの対応するカラムにマッピングします。

スクリプトの完成

「Start」コンポーネントを「Select」コンポーネントに、「CSV」コンポーネントを「End」コンポーネントにドラッグして接続します。スクリプトをビルドして実行すると、Kafka のデータ が CSV ファイルに出力されます。

CData JDBC Driver for Apache Kafkaの30日間の無償トライアルをダウンロードして、HULFT Integrate でリアルタイムの Kafka のデータ を活用してみてください。ご不明な点があれば、サポートチームまでお気軽にお問い合わせください。