ETL Validator JDBC でKafka のデータを扱う方法

ETL Validator は、組織全体のデータプラットフォームを統合するためのデータ移動と変換機能を提供します。 CData JDBC ドライバーは ETL Validator とシームレスに統合され、ネイティブの接続機能を拡張してKafka のデータを含めることができます。

このチュートリアルでは、シンプルな ETL Validator データフローを構築し、Kafka のデータを抽出して、サンプルのデータストレージソリューションである SQL Server にロードする手順を説明します。

CData 経由で新しい ETL Validator データソースを追加

CData は、CData JDBC ドライバー経由で接続するデータソースを追加できるようにすることで、ETL Validator のデータ接続機能を拡張します。Kafka のデータへの接続は、以下の手順で CData の接続スイートを通じて ETL Validator で新しいデータソースを作成するだけです。

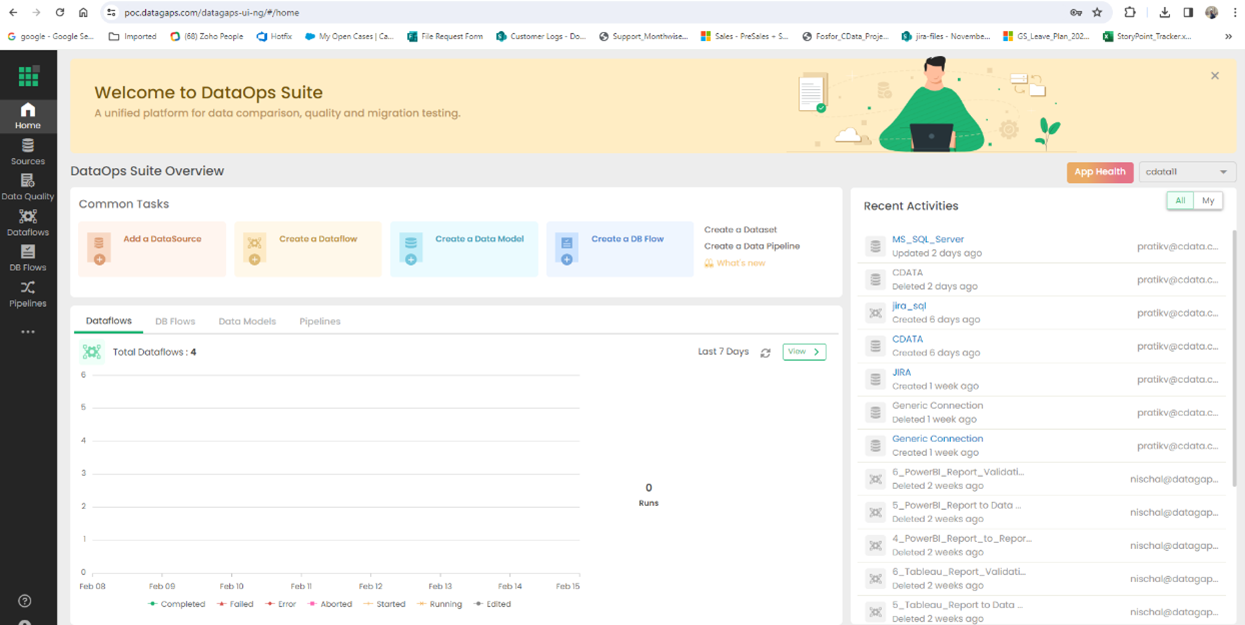

ETL Validator にログイン

まず、ETL Validator にログインしてアプリケーションダッシュボードを表示します。

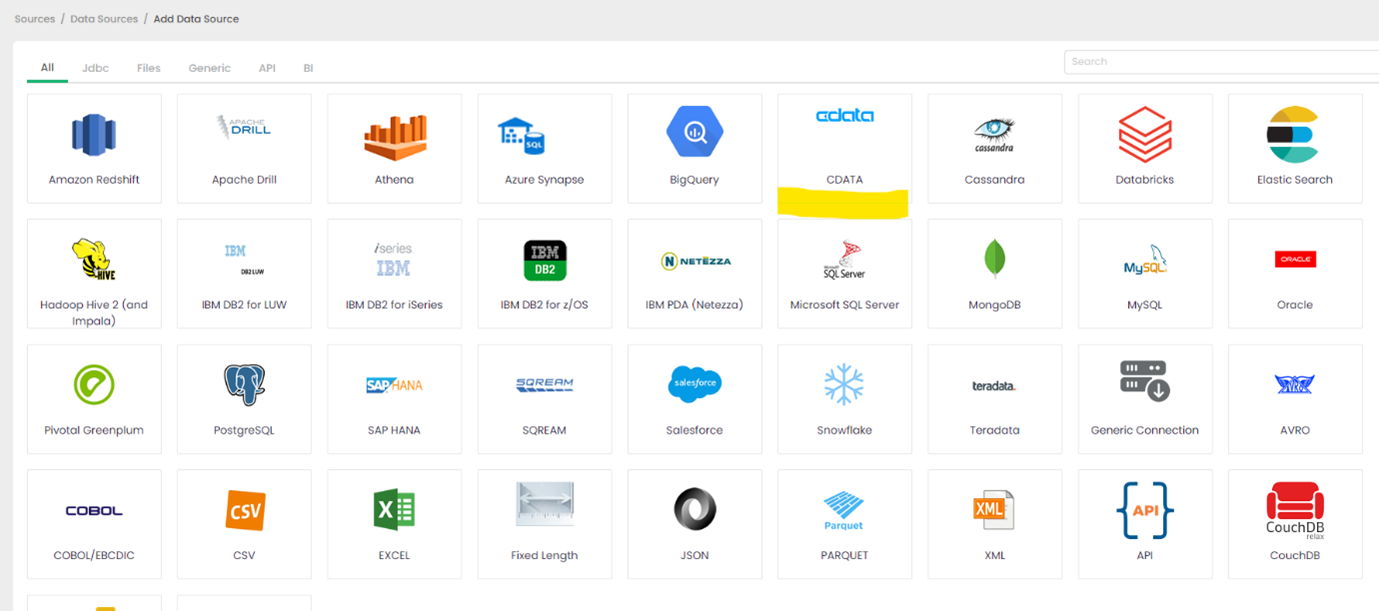

データソースの追加をクリック

CData は ETL Validator 内のデータソースオプションを拡張します。

CData をクリック

CData の接続機能は ETL Validator のデータソースオプションに組み込まれています。

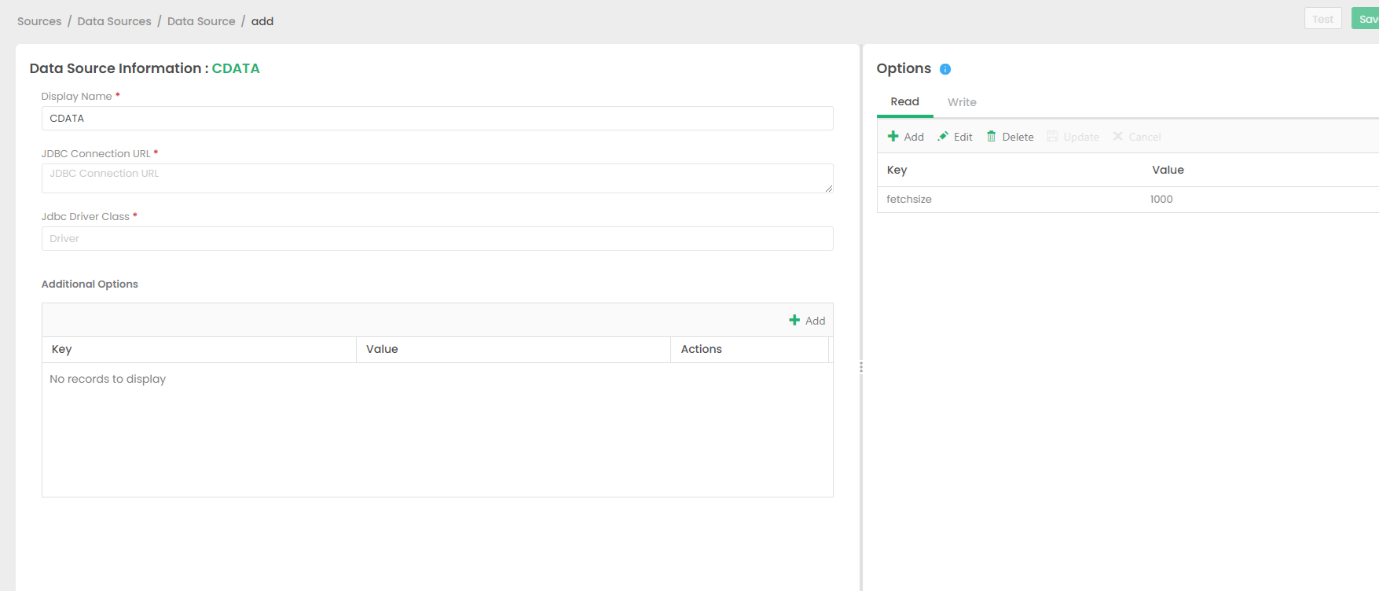

CData Driver の接続文字列を設定

ETL Validator で Kafka への接続を確立するには、JDBC 接続文字列が必要です。

Apache Kafka 接続プロパティの取得・設定方法

それでは、Apache Kafka に接続していきましょう。.NET ベースのエディションは、Confluent.Kafka およびlibrdkafka ライブラリに依存して機能します。 これらのアセンブリはインストーラーにバンドルされており、CData 製品と一緒に自動的にインストールされます。 別のインストール方法をご利用の場合は、NuGet から依存関係のあるConfluent.Kafka 2.6.0をインストールしてください。

Apache Kafka サーバーのアドレスを指定するには、BootstrapServers パラメータを使用します。

デフォルトでは、CData 製品はデータソースとPLAINTEXT で通信しており、これはすべてのデータが暗号化なしで送信されることを意味します。 通信を暗号化したい場合は、以下の設定を行ってください:

- UseSSL をtrue に設定し、CData 製品がSSL 暗号化を使用するように構成します

- SSLServerCert およびSSLServerCertType を設定して、サーバー証明書をロードします

Apache Kafka への認証

続いて、認証方法を設定しましょう。Apache Kafka データソースでは、以下の認証方法をサポートしています:

- Anonymous

- Plain

- SCRAM ログインモジュール

- SSL クライアント証明書

- Kerberos

Anonymous 認証

Apache Kafka の特定のオンプレミスデプロイメントでは、認証接続プロパティを設定することなくApache Kafka に接続できます。 このような接続はanonymous(匿名)と呼ばれます。

匿名認証を行うには、以下のプロパティを設定してください。

- AuthScheme:None

その他の認証方法については、ヘルプドキュメントをご確認ください。

ビルトイン接続文字列デザイナー

JDBC URL の構成については、Kafka JDBC Driver に組み込まれている接続文字列デザイナーを使用してください。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行します。

java -jar cdata.jdbc.apachekafka.jar

一般的な接続文字列は以下のようになります。

jdbc:apachekafka:User=admin;Password=pass;BootStrapServers=https://localhost:9091;Topic=MyTopic;

ドライバーのライセンス

JDBC ドライバーが適切にライセンスされていることを確認するには、ライセンスファイルを適切な場所にコピーします。

Kafka 用の JDBC Driver と lic ファイルを「C:\Program Files\CData[product_name]\lib」から 「C:\Datagaps\ETLValidator\Server\apache-tomcat\bin」にコピーします。

cdata.jdbc.apachekafka.jar

cdata.jdbc.apachekafka.lic

注意:.lic ファイルを jar と一緒にコピーしない場合、有効なライセンスがインストールされていないことを示すライセンスエラーが表示されます。これは評価版と正式版の両方に当てはまります。

接続を保存

CData JDBC ドライバークラスのロードで問題が発生した場合は、DataGap のチームにお問い合わせください。関連するドライバーの jar ファイルをロードする方法について案内を受けることができます。

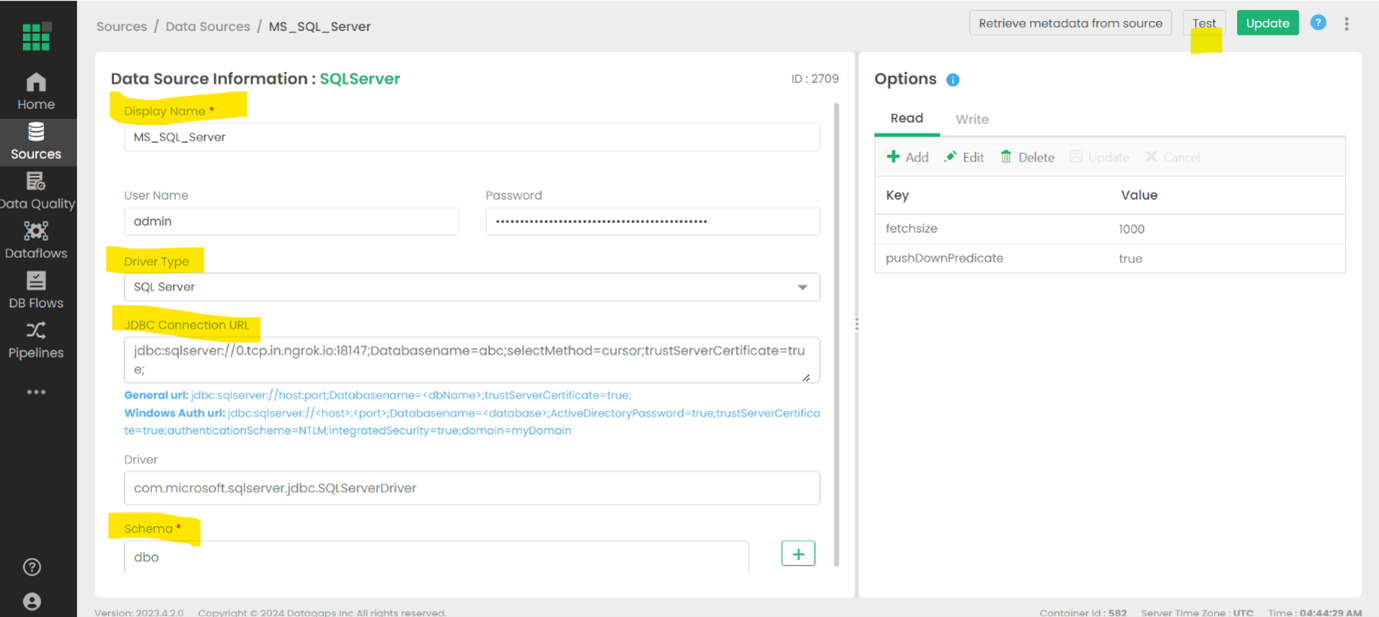

SQL Server をターゲットとして追加

この例では Kafka のデータの保存先として SQL Server を使用しますが、任意の保存先を代わりに使用できます。

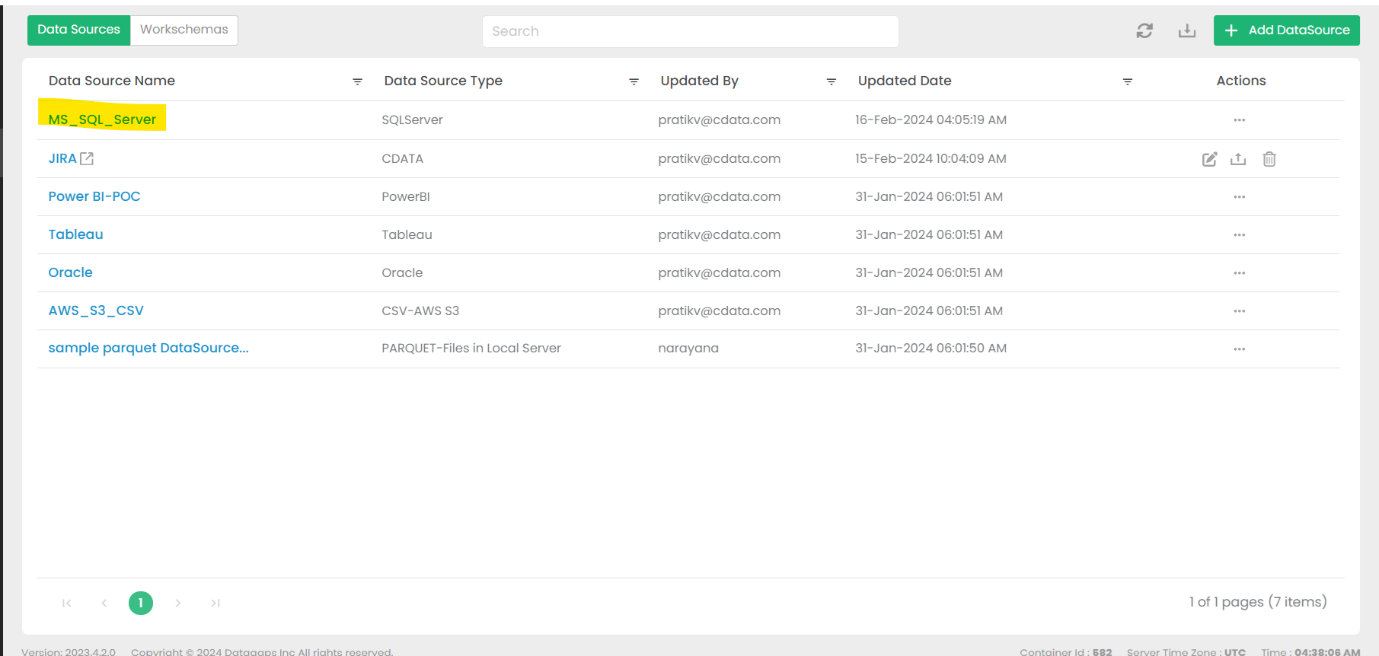

DataSources に移動し、MS_SQL_SERVER を選択

このオプションがデフォルトです。

必要な接続の詳細を入力し、接続をテスト

詳細は特定のターゲットによって異なりますが、URL、認証情報などが含まれる場合があります。

ETL Validator でデータフローを作成

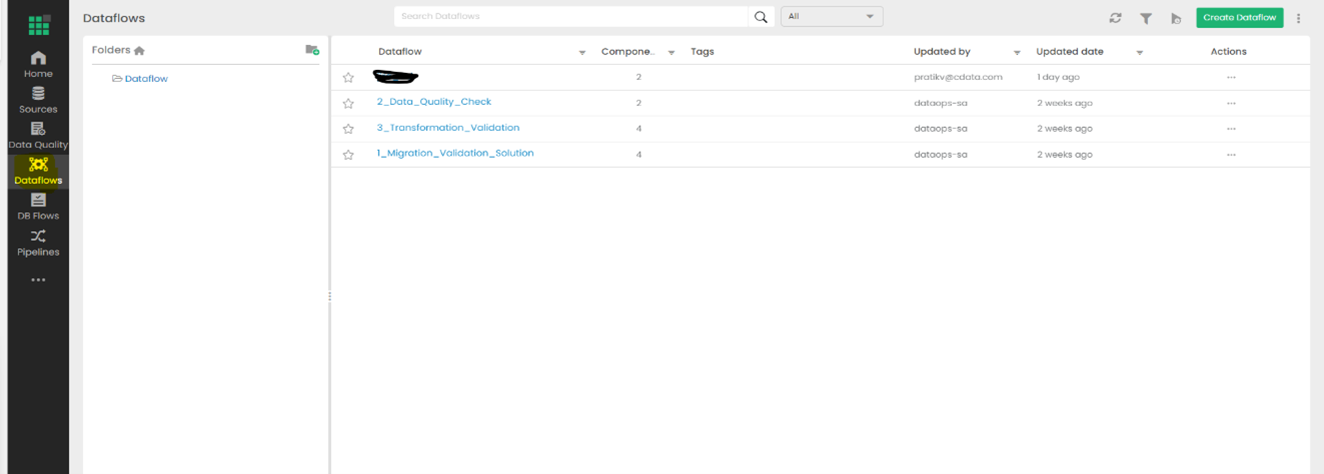

Dataflows タブを開く

設定済みのデータフローがこのウィンドウに表示されます。

Create Dataflow を選択

新しいデータフローに名前を付けて保存します。

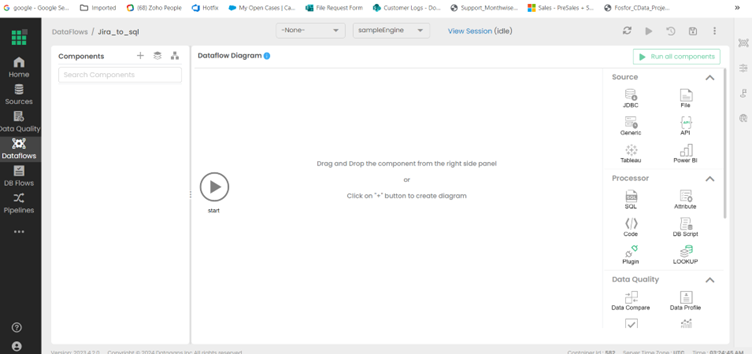

データフローを開いてデータフロー図を表示

データ移動の詳細はこのパネルで設定します。

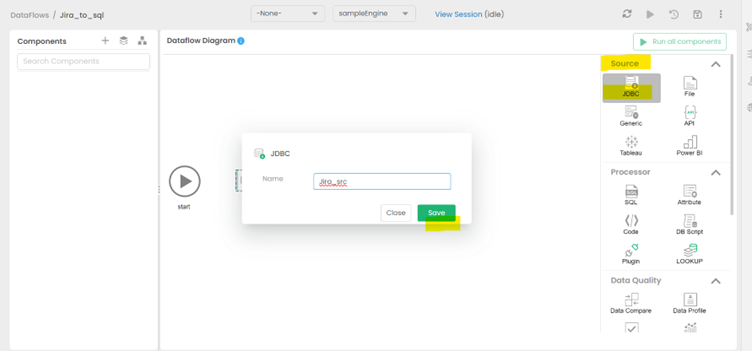

右側から JDBC をソースとしてドラッグ&ドロップ

新しいソースに適切な名前を付けて保存します。

新しいソースの Query セクションを入力

Kafka のデータからどのデータを取得するかを反映するテーブルを Schema オプションから選択します。

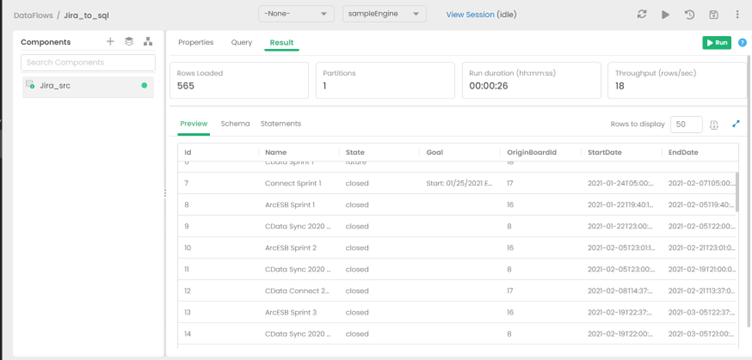

クエリの予想結果を確認

設定したクエリの予想される結果が Result タブに表示されます。

データフローに保存先を追加

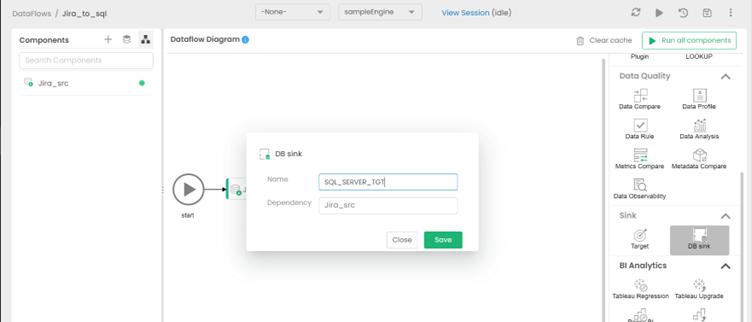

「Switch to Diagram」を選択し、右側(Sink オプションの下)から DB Sink をターゲットとしてドラッグ&ドロップします。シンクに適切な名前を付けて保存します。

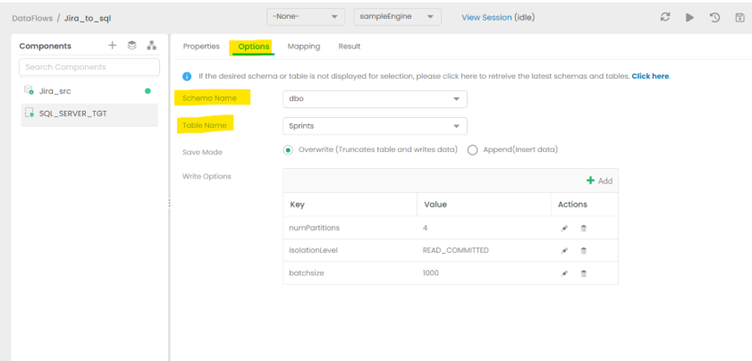

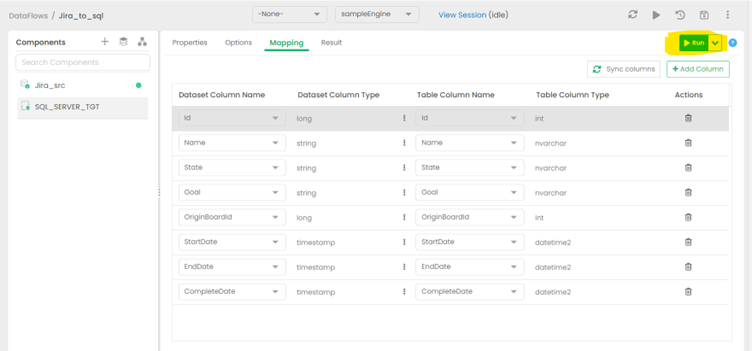

保存先の適切なスキーマを設定

ソーステーブルの構造に一致するスキーマとテーブルを選択します。この例では、ターゲット側のテーブルがソースに一致するように作成されているため、データがシームレスに流れます。より高度なスキーマ変換操作については、この記事の範囲外です。

RUN オプションをクリックしてレプリケーションを開始

ジョブの実行には時間がかかります。

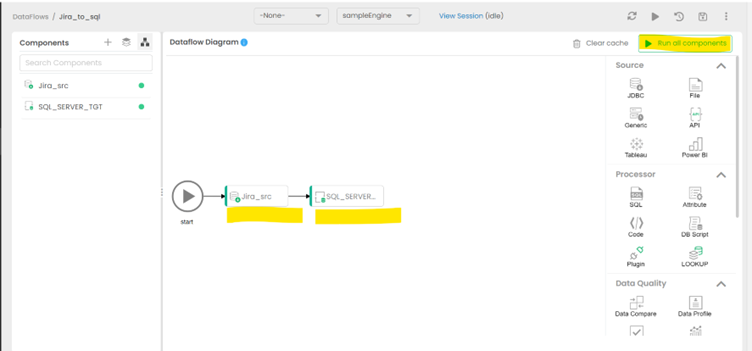

完成したデータフローを確認

図に戻り、Kafka のデータから SQL Server への完成したデータレプリケーションジョブを確認します。

今すぐ始めましょう

CData JDBC Driver for Kafka の30日間無償トライアルをダウンロードして、 ETL Validator で Kafka 連携アプリケーションの構築を始めましょう。ご不明な点がございましたら、 サポートチームまでお問い合わせください。