SnapLogic を使用して Databricks を外部サービスと連携

SnapLogic は、ノーコードでデータ連携フローを作成できる iPaaS(Integration Platform as a Service)です。CData JDBC Driver と組み合わせることで、Databricks を含む250を超える SaaS、ビッグデータ、NoSQL ソースのリアルタイムデータに SnapLogic ワークフローからアクセスできます。

CData JDBC Driver は、最適化されたデータ処理機能を内蔵しており、リアルタイム Databricks のデータ とのやり取りにおいて比類ないパフォーマンスを発揮します。外部ツールから複雑な SQL クエリが発行されると、ドライバーはフィルタや集計などのサポートされている SQL 操作を Databricks に直接プッシュし、サポートされていない操作(多くの場合、SQL 関数や JOIN 操作)は内蔵の SQL エンジンを使用してクライアント側で処理します。動的なメタデータクエリ機能により、ネイティブデータ型を使用して Databricks のデータ を操作できます。

Databricks データ連携について

CData を使用すれば、Databricks のライブデータへのアクセスと統合がこれまでになく簡単になります。お客様は CData の接続機能を以下の目的で利用しています:

- Runtime バージョン 9.1 - 13.X から Pro および Classic Databricks SQL バージョンまで、すべてのバージョンの Databricks にアクセスできます。

- あらゆるホスティングソリューションとの互換性により、お好みの環境で Databricks を使用し続けることができます。

- パーソナルアクセストークン、Azure サービスプリンシパル、Azure AD など、さまざまな方法で安全に認証できます。

- Databricks ファイルシステム、Azure Blob ストレージ、AWS S3 ストレージを使用して Databricks にデータをアップロードできます。

多くのお客様が、さまざまなシステムから Databricks データレイクハウスにデータを移行するために CData のソリューションを使用していますが、ライブ接続ソリューションを使用して、データベースと Databricks 間の接続をフェデレートしているお客様も多数います。これらのお客様は、SQL Server リンクサーバーまたは Polybase を使用して、既存の RDBMS 内から Databricks へのライブアクセスを実現しています。

一般的な Databricks のユースケースと CData のソリューションがデータの問題解決にどのように役立つかについては、ブログをご覧ください:What is Databricks Used For? 6 Use Cases

はじめに

SnapLogic から Databricks に接続

SnapLogic から Databricks のデータ に接続するには、CData Databricks JDBC Driver をダウンロードしてインストールします。インストールウィザードに従って進めてください。インストールが完了すると、JAR ファイルはインストールディレクトリ(デフォルトでは C:/Program Files/CData/CData JDBC Driver for Databricks/lib)に配置されます。

Databricks JDBC Driver のアップロード

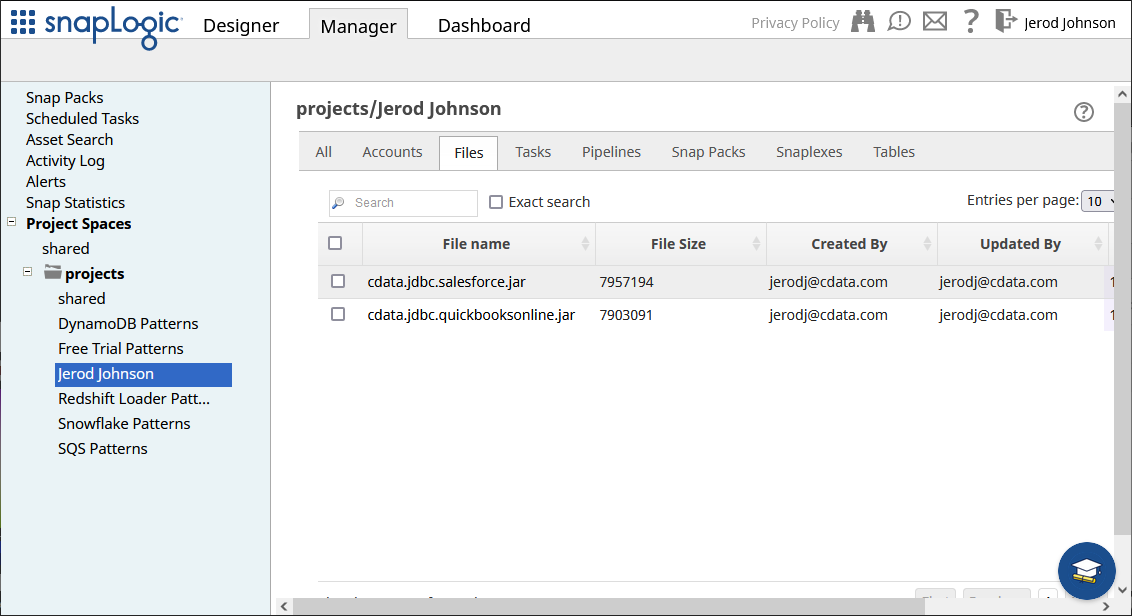

インストール後、Manager タブから SnapLogic 内の場所(例:projects/Jerod Johnson)に JDBC JAR ファイルをアップロードします。

接続の設定

JDBC Driver をアップロードしたら、Databricks への接続を作成します。

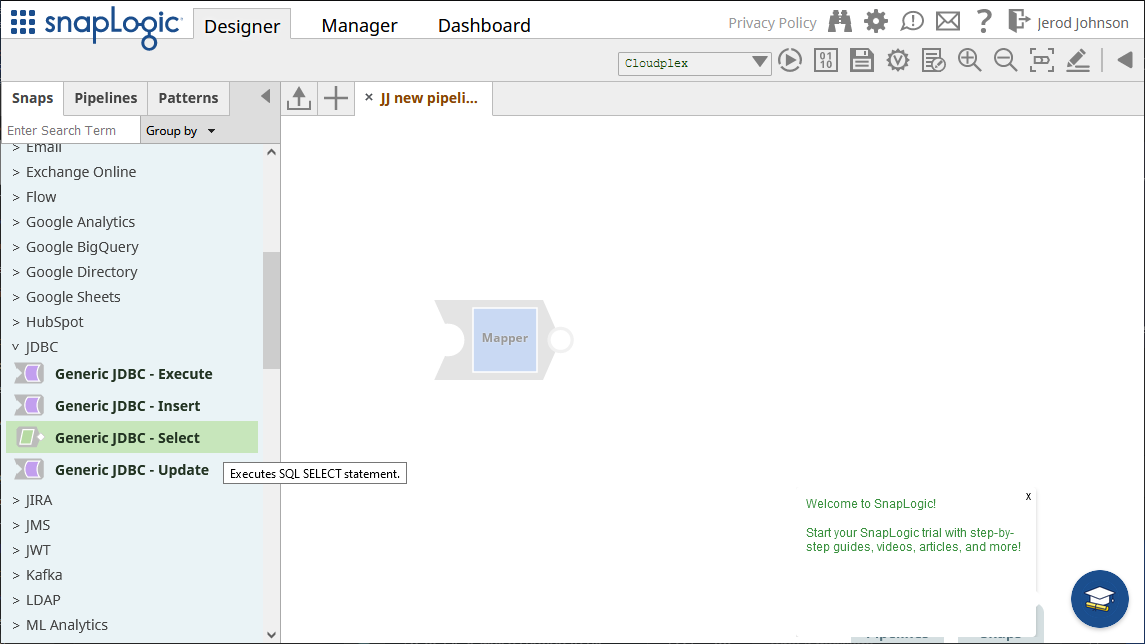

- Designer タブに移動します

- Snaps から「JDBC」を展開し、「Generic JDBC - Select」snap をデザイナーにドラッグします

- Add Account をクリック(または既存のアカウントを選択)し、「Continue」をクリックします

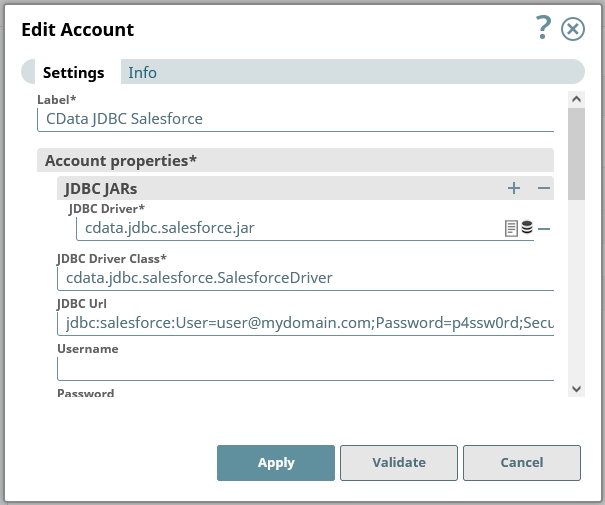

- 次のフォームで、JDBC 接続プロパティを設定します:

- JDBC JARs に、先ほどアップロードした JAR ファイルを追加します

- JDBC Driver Class を cdata.jdbc.databricks.DatabricksDriver に設定します

JDBC URL を Databricks JDBC Driver の JDBC 接続文字列に設定します。例:

jdbc:databricks:Server=127.0.0.1;HTTPPath=MyHTTPPath;User=MyUser;Token=MyToken;RTK=XXXXXX;

注意:RTK はトライアルキーまたは製品キーです。詳細についてはサポートチームまでお問い合わせください。

組み込みの接続文字列デザイナー

JDBC URL の構築には、Databricks JDBC Driver に組み込まれている接続文字列デザイナーを使用できます。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行してください。

java -jar cdata.jdbc.databricks.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

Databricks 接続プロパティの取得・設定方法

Databricks クラスターに接続するには、以下のプロパティを設定します。

- Database:Databricks データベース名。

- Server:Databricks クラスターのサーバーのホスト名。

- HTTPPath:Databricks クラスターのHTTP パス。

- Token:個人用アクセストークン。この値は、Databricks インスタンスのユーザー設定ページに移動してアクセストークンタブを選択することで取得できます。

Databricks への認証

CData は、次の認証スキームをサポートしています。

- 個人用アクセストークン

- Microsoft Entra ID(Azure AD)

- Azure サービスプリンシパル

- OAuthU2M

- OAuthM2M

個人用アクセストークン

認証するには、次を設定します。

- AuthScheme:PersonalAccessToken。

- Token:Databricks サーバーへの接続に使用するトークン。Databricks インスタンスのユーザー設定ページに移動してアクセストークンタブを選択することで取得できます。

その他の認証方法については、ヘルプドキュメント の「はじめに」セクションを参照してください。

- 接続プロパティを入力したら、「Validate」をクリックし、「Apply」をクリックします

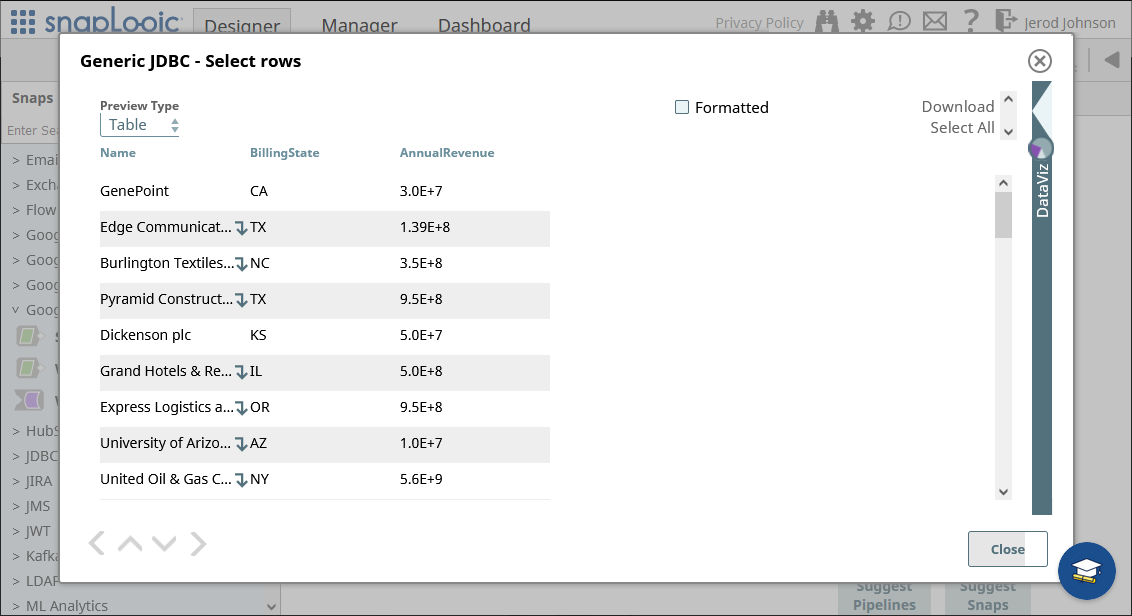

Databricks のデータ の読み取り

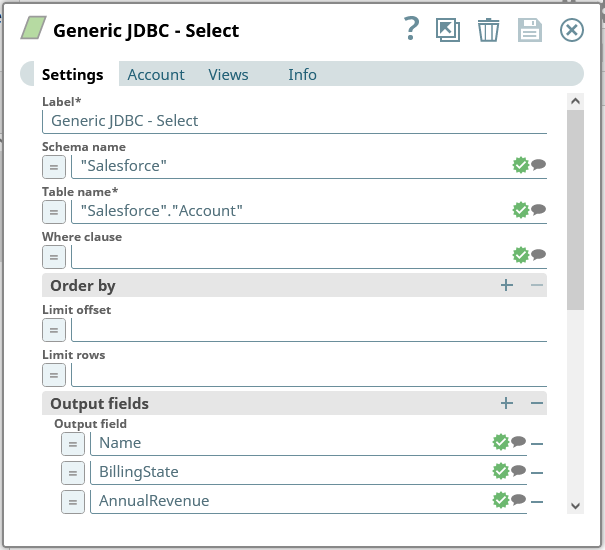

接続の検証と適用後に開くフォームで、クエリを設定します。

- Schema name を「Databricks」に設定します

- Table name を Databricks のテーブルに設定します。スキーマ名を使用して、例:「Databricks」.「Customers」(ドロップダウンで利用可能なテーブルの一覧を確認できます)

- テーブルから使用する各項目の Output fields を追加します

Generic JDBC - Select snap を保存します。

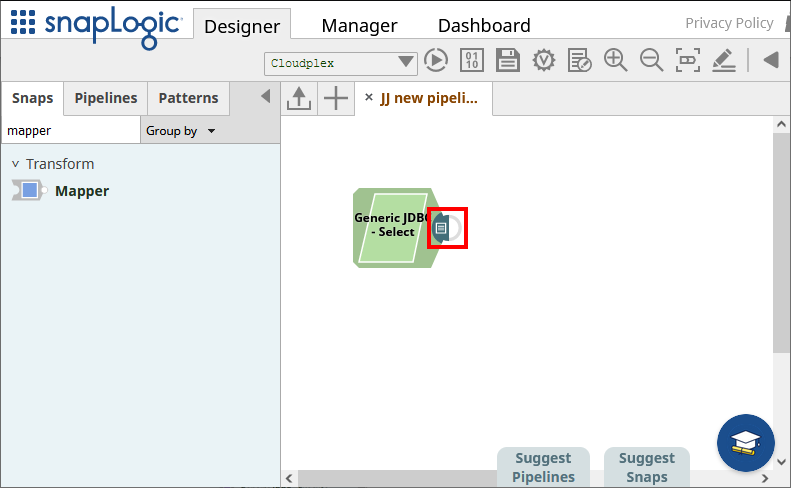

接続とクエリを設定したら、snap の末尾をクリックしてデータをプレビューします(下図でハイライト表示)。

結果が期待通りであることを確認したら、追加の snap を使用して Databricks のデータ を別のエンドポイントに送信できます。

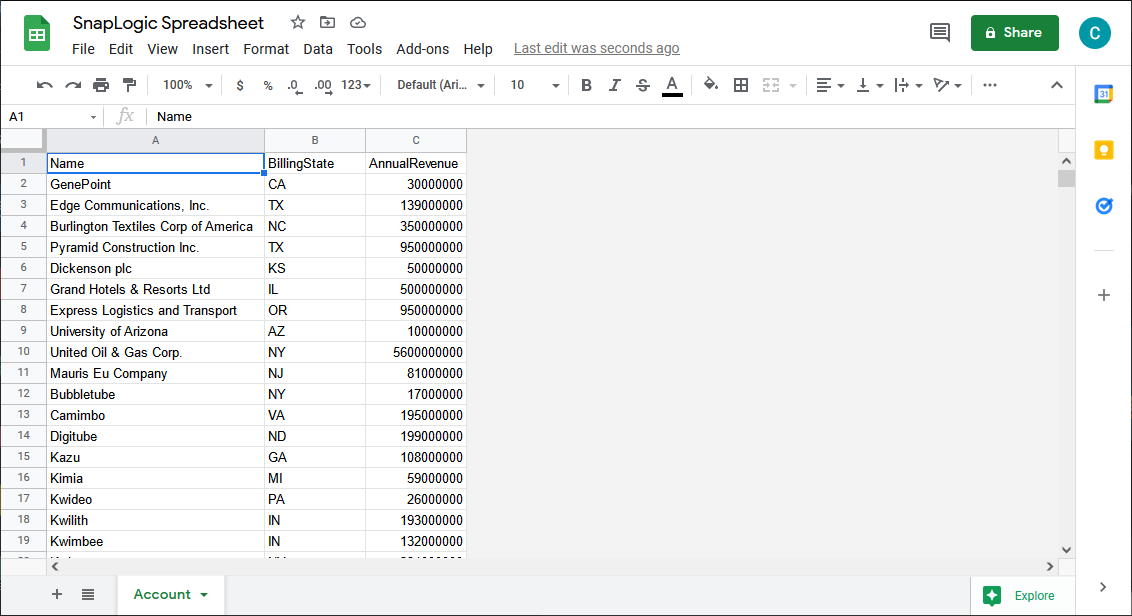

Databricks のデータ を外部サービスにパイプ

この記事では、データを Google スプレッドシートに読み込みます。サポートされている任意の snap を使用するか、別の CData JDBC Driver と Generic JDBC snap を使用して、外部サービスにデータを移動できます。

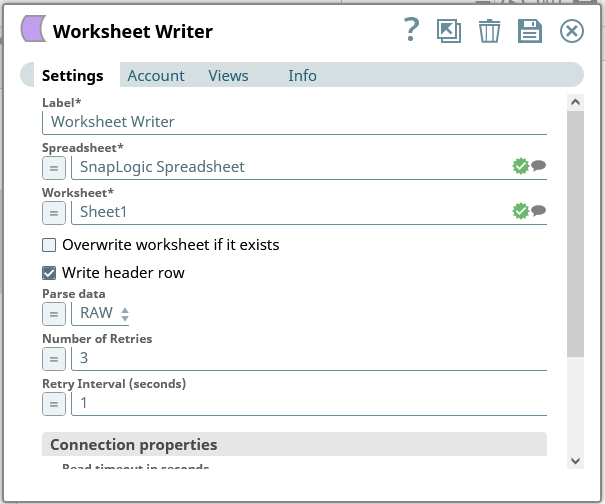

- 「Worksheet Writer」snap を「Generic JDBC - Select」snap の末尾にドロップします。

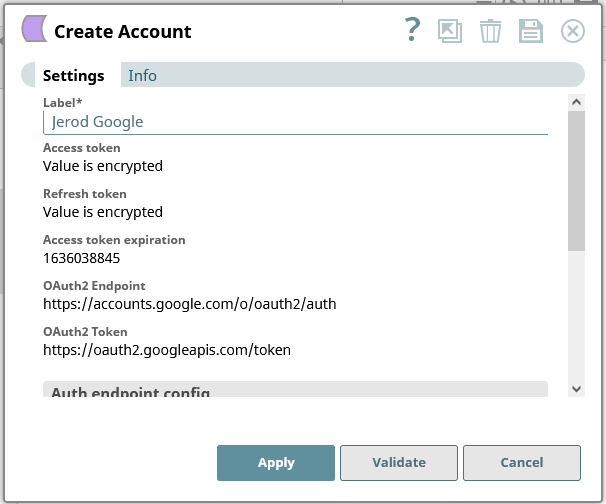

- Google Sheets に接続するためのアカウントを追加します

- Worksheet Writer snap を設定して、Databricks のデータ を Google スプレッドシートに書き込みます

これで、完全に設定されたパイプラインを実行して、Databricks からデータを抽出し、Google スプレッドシートにプッシュできます。

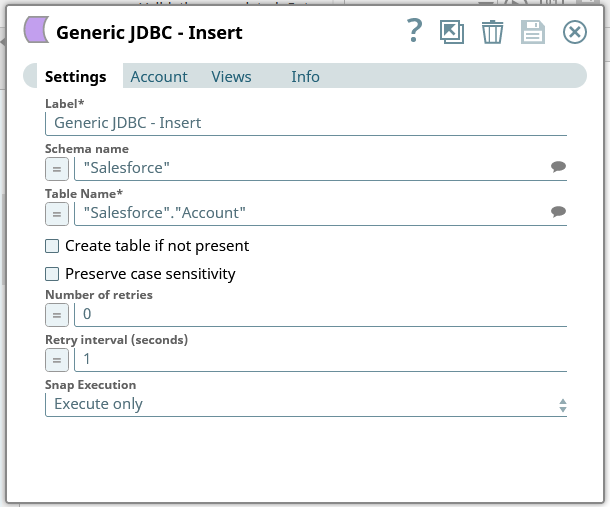

外部データを Databricks にパイプ

上記の通り、SnapLogic で Databricks 用の JDBC Driver を使用して Databricks にデータを書き込むこともできます。まず、Generic JDBC - Insert または Generic JDBC - Update snap をダッシュボードに追加します。

- 既存の「Account」(接続)を選択するか、新しいものを作成します

- クエリを設定します:

- Schema name を「Databricks」に設定します

- Table name を Databricks のテーブルに設定します。スキーマ名を使用して、例:「Databricks」.「Customers」(ドロップダウンで利用可能なテーブルの一覧を確認できます)

- Generic JDBC - Insert/Update snap を保存します

これで、Databricks にデータを書き込み、新しいレコードを挿入したり既存のレコードを更新したりする snap が設定されました。

詳細情報と無料トライアル

CData JDBC Driver for Databricks を使用することで、SnapLogic で Databricks のデータ を外部サービスと連携するパイプラインを作成できます。Databricks への接続の詳細については、CData JDBC Driver for Databricks ページをご覧ください。CData JDBC Driver for Databricks の30日間無料トライアルをダウンロードして、今すぐお試しください。