SSIS で SQL Server から Spark へのデータフローを構築

SQL Server データベースは、エンタープライズレコードの保存に広く使用されています。このデータを他の場所に移動する必要がある場合がよくあります。CData SSIS Task for Spark を使用すると、Spark のデータを簡単に転送できます。この記事では、SQL Server から Spark にデータをエクスポートする方法を説明します。

ソースとデスティネーションコンポーネントの追加

まず、新しい ADO.NET Source コントロールと新しい Spark Destination コントロールを Data Flow Task に追加します。

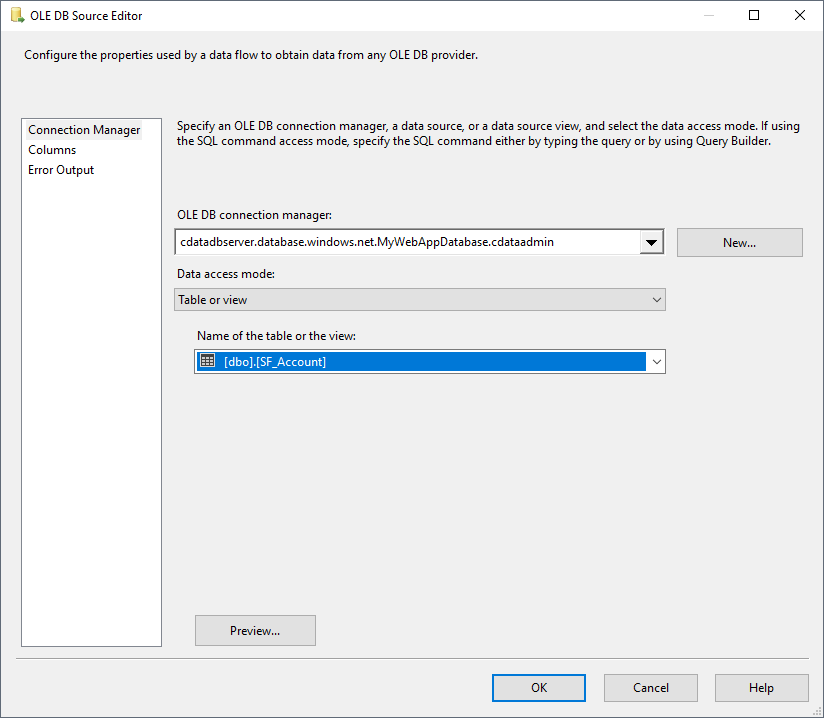

ADO.NET ソースの設定

以下の手順に従って、SQL Server インスタンスへの接続に必要なプロパティを指定します。

- ADO.NET Source を開き、新しい接続を追加します。ここでサーバーとデータベースの情報を入力します。

- Data access mode メニューで「Table or view」を選択し、Spark にエクスポートするテーブルまたはビューを選択します。

- ADO NET Source ウィザードを閉じ、デスティネーションコンポーネントに接続します。

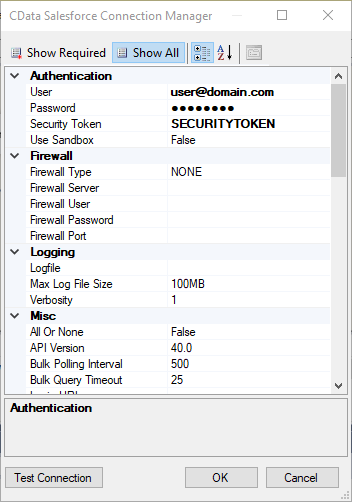

Spark 用の新しい Connection Manager を作成

以下の手順に従って、Connection Manager で必要な接続プロパティを設定します。

- 新しい Connection Manager を作成します:Connection Manager ウィンドウで右クリックし、New Connection をクリックします。Add SSIS Connection Manager ダイアログが表示されます。

- メニューから CData SparkSQL Connection Manager を選択します。

-

接続プロパティを設定します。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

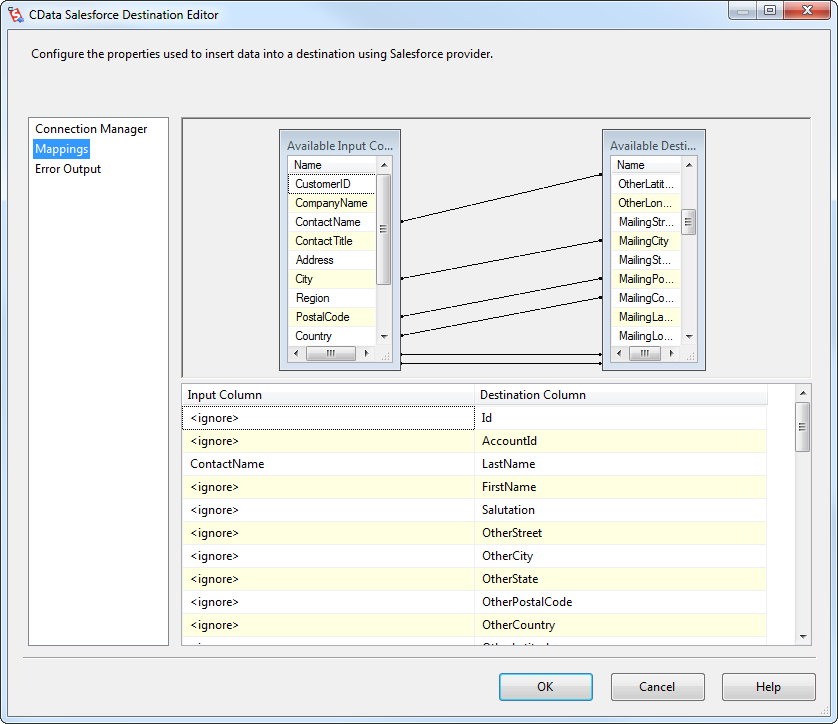

Spark デスティネーションの設定

デスティネーションコンポーネントの Connection Manager で、SQL Server ソーステーブルから Spark デスティネーションテーブルへのマッピングと、Spark のデータに対して実行するアクションを定義します。この記事では、Customers エンティティを Spark に挿入します。

- Spark Destination をダブルクリックして、デスティネーションコンポーネントエディタを開きます。

- Connection Managers タブで、先ほど作成した Connection Manager を選択します。

-

Use a Table メニューで Customers を選択します。

Action メニューで Insert を選択します。

-

Column Mappings タブで、入力カラムからデスティネーションカラムへのマッピングを設定します。

プロジェクトの実行

これでプロジェクトを実行できます。 SSIS Task の実行が完了すると、SQL テーブルのデータが選択したテーブルにエクスポートされます。