CData SSIS Components を使用して Spark のデータを Databricks にマイグレーション

Databricks は、大量のデータを簡単に処理、分析、可視化できる統合データ分析プラットフォームです。データエンジニアリング、データサイエンス、機械学習の機能を単一のプラットフォームに統合し、チームがコラボレーションしてデータからインサイトを得ることを容易にします。

CData SSIS Components は、SQL Server Integration Services を拡張し、さまざまなソースやデスティネーションからデータを簡単にインポート・エクスポートできるようにします。

この記事では、Databricks へのエクスポート時のデータ型マッピングの考慮事項を確認し、CData SSIS Components for Spark と Databricks を使用してSpark のデータを Databricks にマイグレーションする方法を説明します。

データ型マッピング

| Databricks スキーマ | CData スキーマ |

|---|---|

|

int, integer, int32 |

int |

|

smallint, short, int16 |

smallint |

|

double, float, real |

float |

|

date |

date |

|

datetime, timestamp |

datetime |

|

time, timespan |

time |

|

string, varchar |

長さ > 4000 の場合:nvarchar(max)、それ以外:nvarchar(length) |

|

long, int64, bigint |

bigint |

|

boolean, bool |

tinyint |

|

decimal, numeric |

decimal |

|

uuid |

nvarchar(length) |

|

binary, varbinary, longvarbinary |

binary(1000) または SQL Server 2000 以降は varbinary(max) |

特別な考慮事項

- String/VARCHAR: Databricks の String カラムは、カラムの長さによって異なるデータ型にマッピングされます。カラムの長さが 4000 を超える場合、カラムは nvarchar(max) にマッピングされます。それ以外の場合は、nvarchar(length) にマッピングされます。

- DECIMAL: Databricks は最大 38 桁の精度の DECIMAL 型をサポートしていますが、それを超えるソースカラムはロードエラーを引き起こす可能性があります。

前提条件

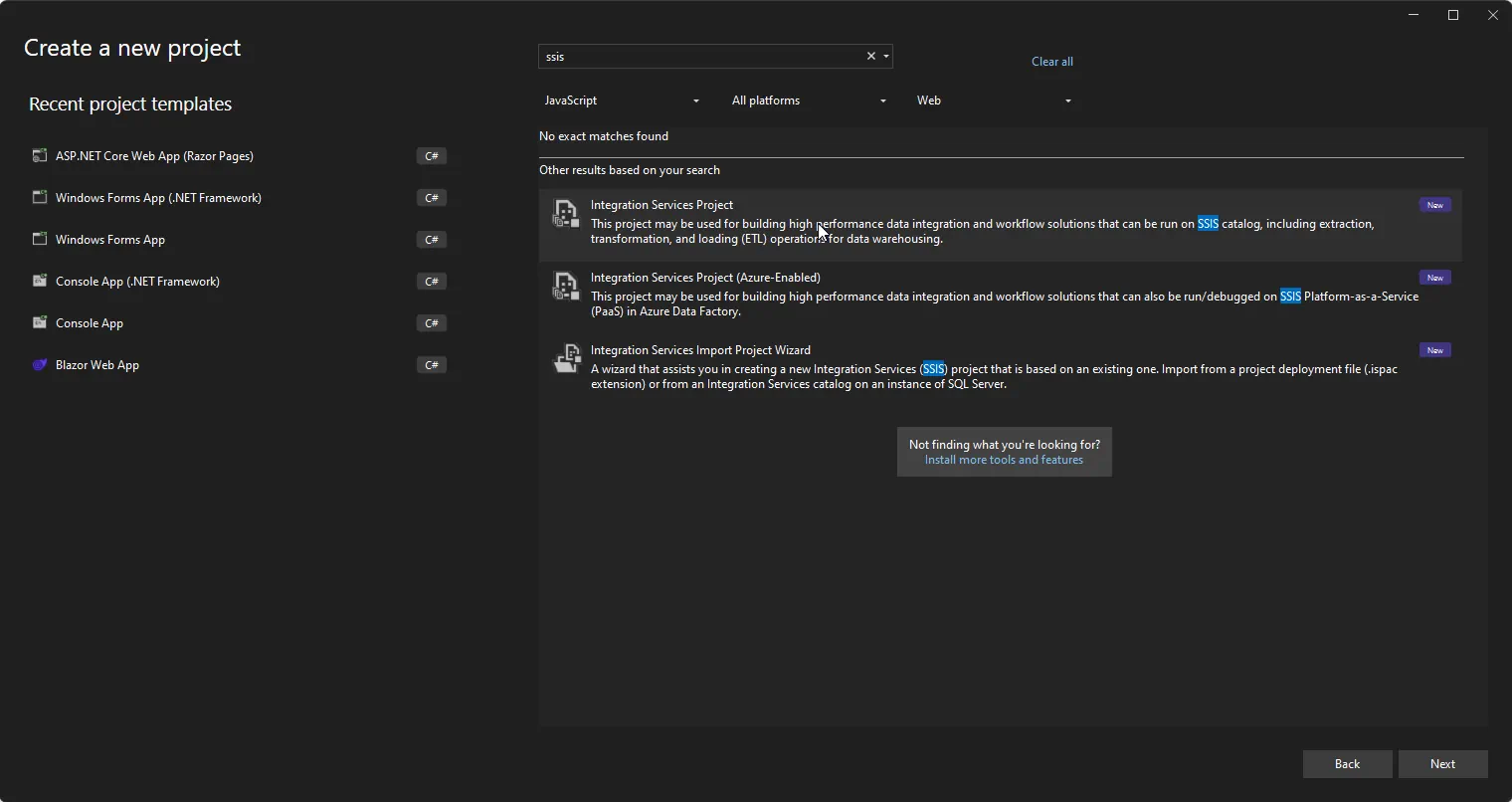

- Visual Studio 2022

- Visual Studio 2022 用 SQL Server Integration Services Projects 拡張機能

- CData SSIS Components for Databricks

- CData SSIS Components for Spark

プロジェクトの作成とコンポーネントの追加

-

Visual Studio を開き、新しい Integration Services プロジェクトを作成します。

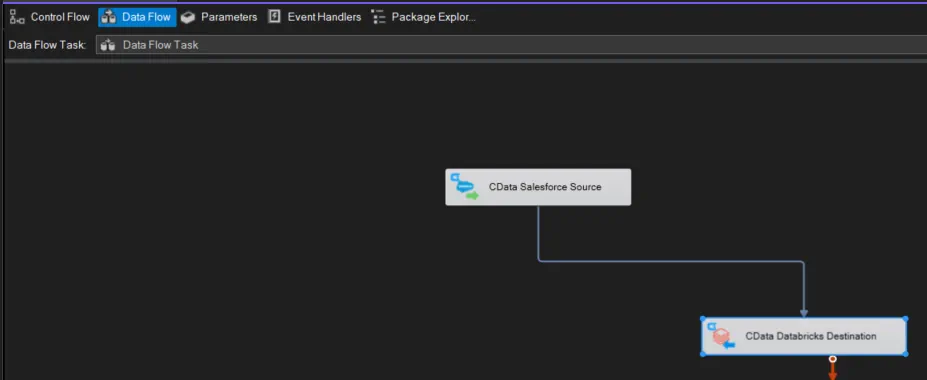

- Control Flow 画面に新しい Data Flow Task を追加し、Data Flow Task を開きます。

-

Data Flow Task に CData Spark Source コントロールと CData Databricks Destination コントロールを追加します。

Spark ソースの設定

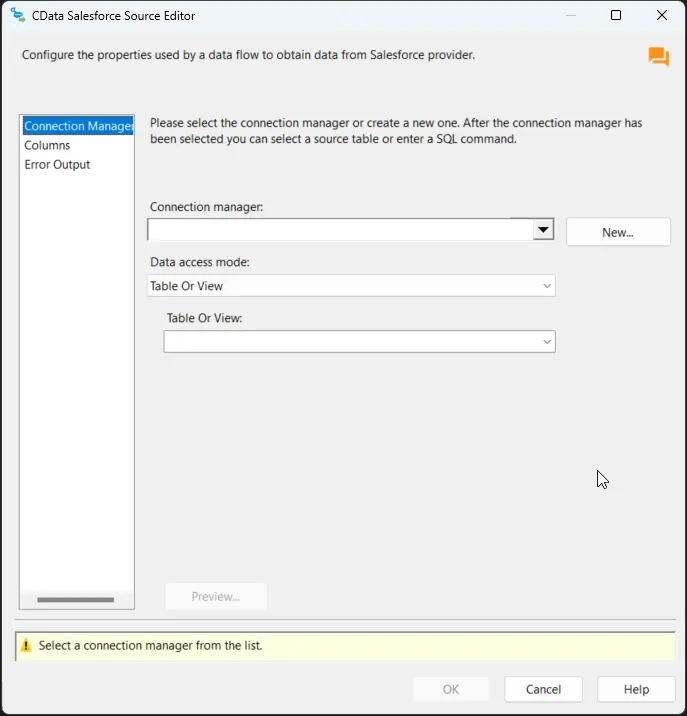

以下の手順に従って、Spark への接続に必要なプロパティを指定します。

-

CData Spark Source をダブルクリックしてソースコンポーネントエディタを開き、新しい接続を追加します。

-

CData Spark Connection Manager で接続プロパティを設定し、接続をテストして保存します。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

-

接続を保存後、「Table or view」を選択し、Databricks にエクスポートするテーブルまたはビューを選択して、CData Spark Source Editor を閉じます。

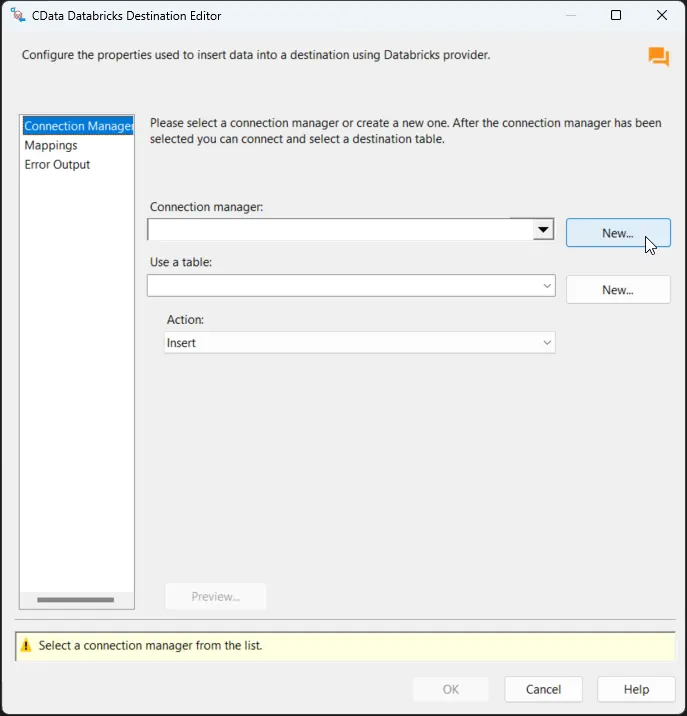

Databricks デスティネーションの設定

Spark Source を設定したら、Databricks 接続を設定してカラムをマッピングします。

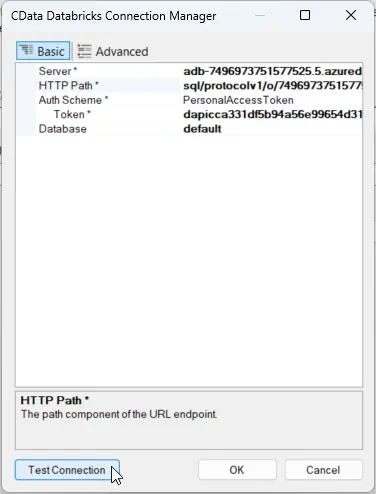

-

CData Databricks Destination をダブルクリックしてデスティネーションコンポーネントエディタを開き、新しい接続を追加します。

-

CData Databricks Connection Manager で接続プロパティを設定し、接続をテストして保存します。Databricks クラスターに接続するには、以下のようにプロパティを設定します。

注意:必要な値は、Databricks インスタンスで Clusters に移動し、目的のクラスターを選択して、Advanced Options の下にある JDBC/ODBC タブを選択することで確認できます。

- Server:Databricks クラスターの Server Hostname を設定します。

- HTTPPath:Databricks クラスターの HTTP Path を設定します。

- Token:個人用アクセストークンを設定します(この値は、Databricks インスタンスの User Settings ページに移動し、Access Tokens タブを選択することで取得できます)。

その他の便利な接続プロパティ

- QueryPassthrough: True に設定すると、クエリは Databricks に直接渡されます。

- ConvertDateTimetoGMT: True に設定すると、コンポーネントはローカルマシンの時刻ではなく、日時値を GMT に変換します。

- UseUploadApi: このプロパティを true に設定すると、Bulk INSERT 操作で大量のデータがある場合にパフォーマンスが向上します。

- UseCloudFetch: このオプションは、テーブルに 100 万件を超えるエントリがある場合にクエリ効率を向上させるために CloudFetch を使用するかどうかを指定します。

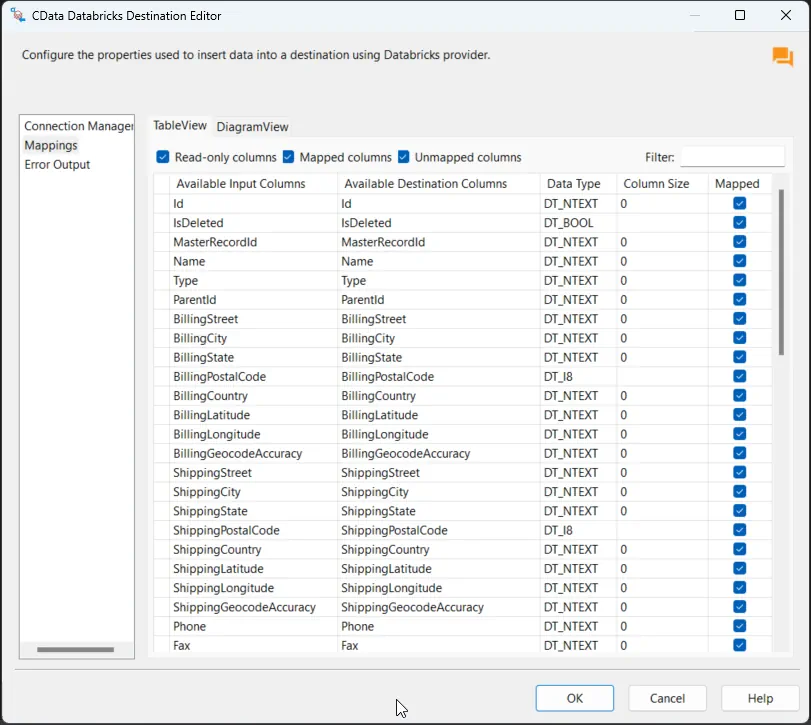

-

接続を保存後、Use a Table メニューでテーブルを選択し、Action メニューで Insert を選択します。

-

Column Mappings タブで、入力カラムからデスティネーションカラムへのマッピングを設定します。

プロジェクトの実行

これでプロジェクトを実行できます。SSIS Task の実行が完了すると、SQL テーブルのデータが選択したテーブルにエクスポートされます。