【ノーコード】SAP LumiraでSpark のOData フィードを取り込んでみる

CData API Server を使って、SAP Lumira でSpark に基づくビジュアライゼーションを作成できます。API Server により、リアルタイムデータへの接続が可能になります。ダッシュボードとレポートはオンデマンドで更新できます。この記事では、常に最新であるグラフを作成する方法を説明します。

API Server の設定

以下のリンクからAPI Server の無償トライアルをスタートしたら、セキュアなSpark OData サービスを作成していきましょう。

Spark への接続

Salesforce Connect からSpark のデータを操作するには、まずSpark への接続を作成・設定します。

- API Server にログインして、「Connections」をクリック、さらに「接続を追加」をクリックします。

- 「接続を追加」をクリックして、データソースがAPI Server に事前にインストールされている場合は、一覧から「Spark」を選択します。

- 事前にインストールされていない場合は、コネクタを追加していきます。コネクタ追加の手順は以下の記事にまとめてありますので、ご確認ください。

CData コネクタの追加方法はこちら >> - それでは、Spark への接続設定を行っていきましょう!

-

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

- 接続情報の入力が完了したら、「保存およびテスト」をクリックします。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

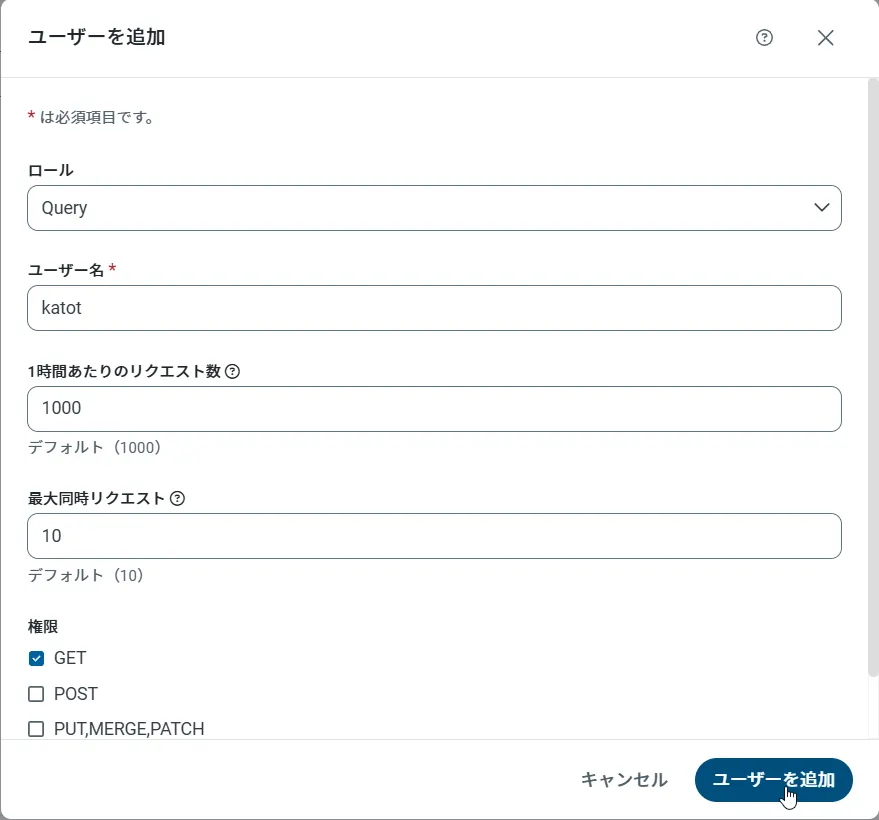

API Server のユーザー設定

次に、API Server 経由でSpark にアクセスするユーザーを作成します。「Users」ページでユーザーを追加・設定できます。やってみましょう。

- 「Users」ページで ユーザーを追加をクリックすると、「ユーザーを追加」ポップアップが開きます。

-

次に、「ロール」、「ユーザー名」、「権限」プロパティを設定し、「ユーザーを追加」をクリックします。

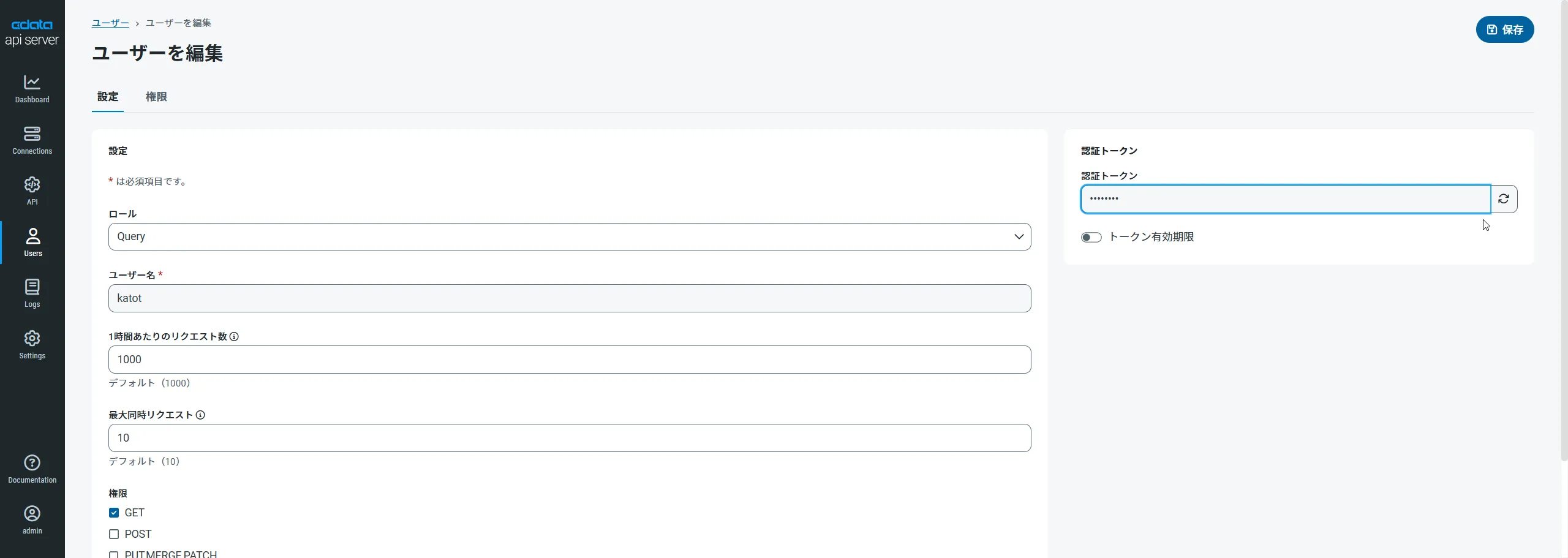

-

その後、ユーザーの認証トークンが生成されます。各ユーザーの認証トークンとその他の情報は「Users」ページで確認できます。

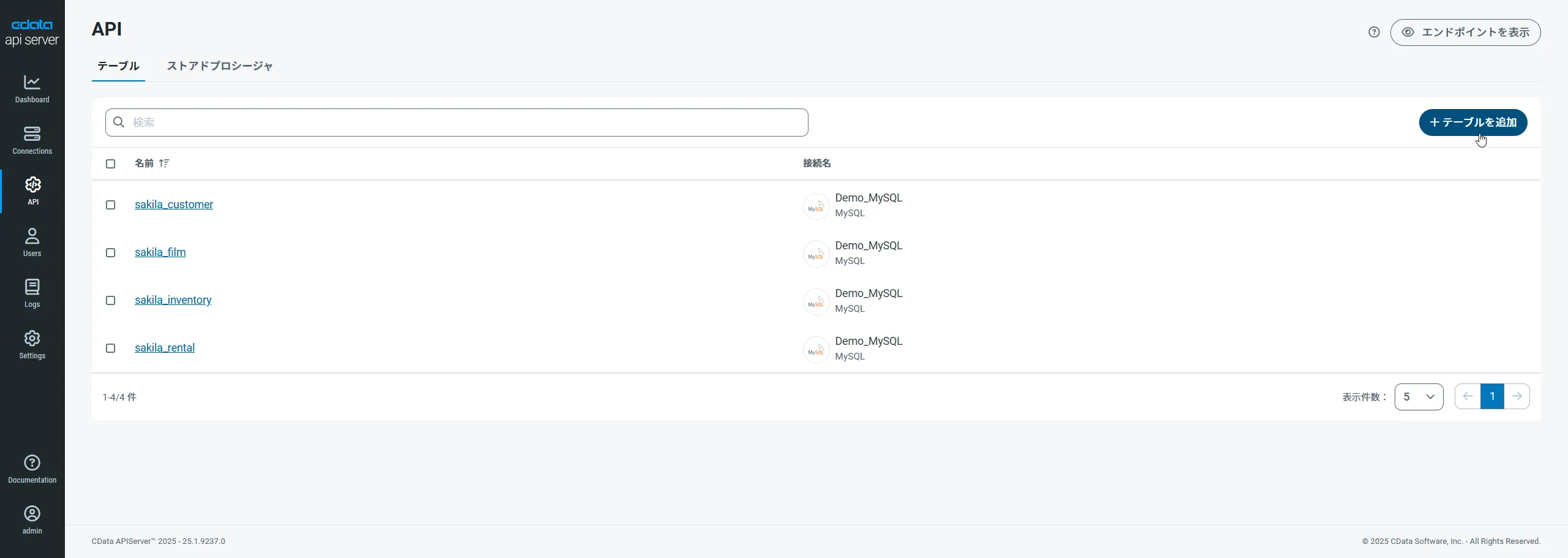

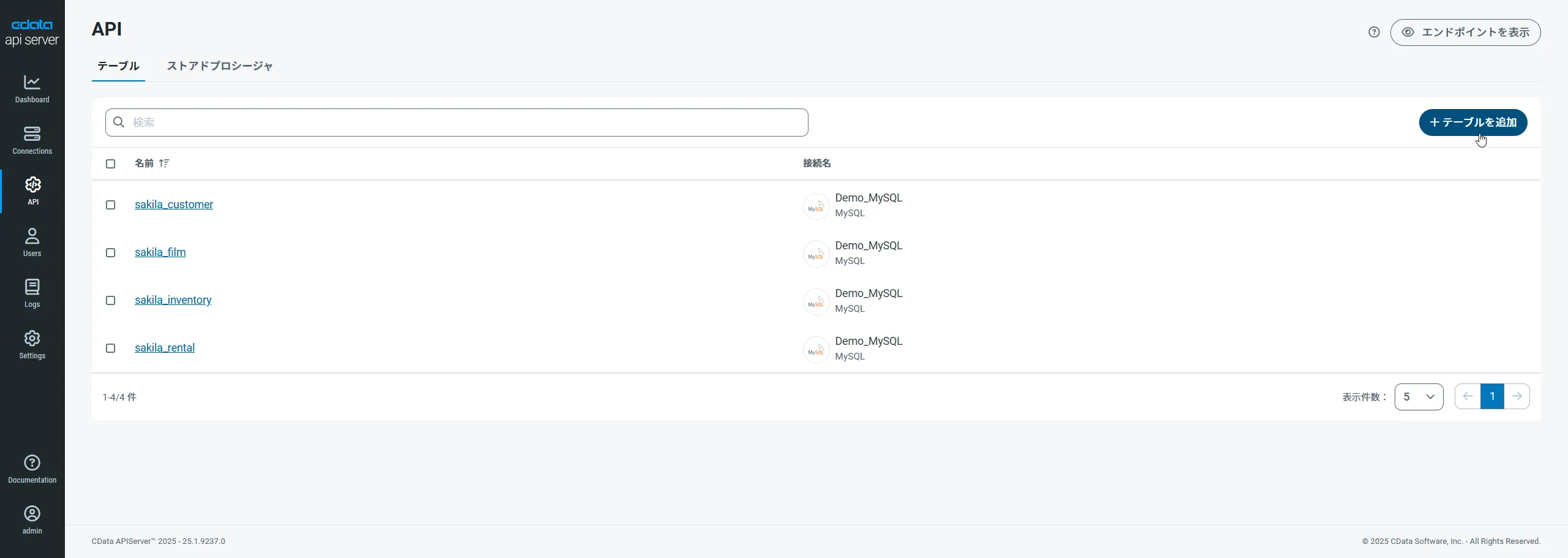

Spark 用のAPI エンドポイントの作成

ユーザーを作成したら、Spark のデータ用のAPI エンドポイントを作成していきます。

-

まず、「API」ページに移動し、

「 テーブルを追加」をクリックします。

-

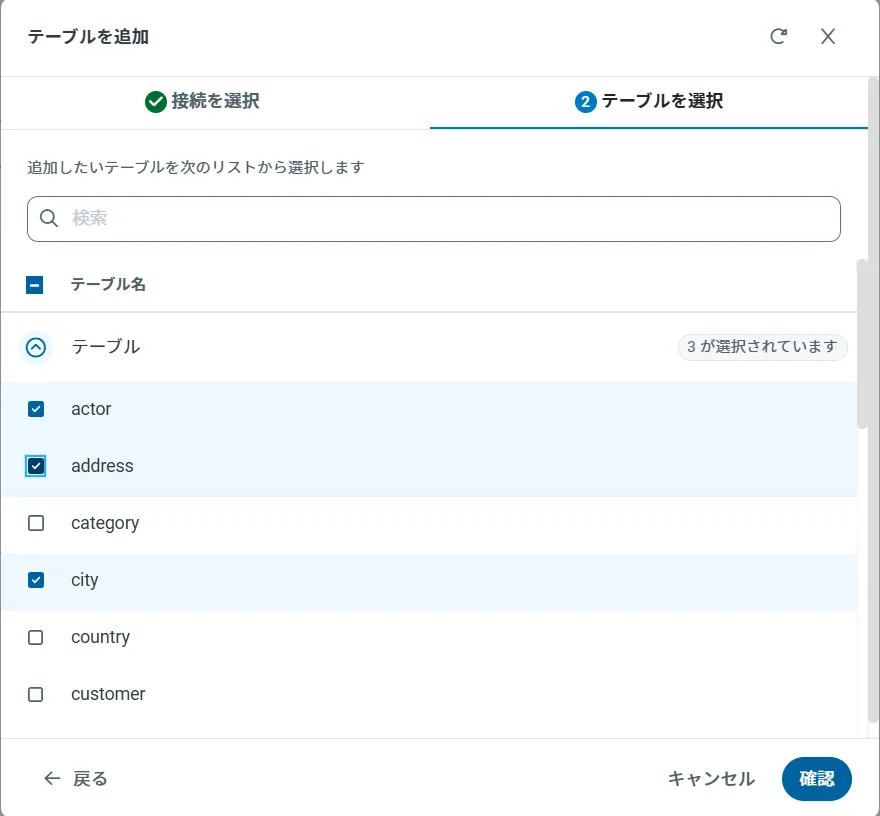

アクセスしたい接続を選択し、次へをクリックします。

-

接続を選択した状態で、各テーブルを選択して確認をクリックすることでエンドポイントを作成します。

OData のエンドポイントを取得

以上でSpark への接続を設定してユーザーを作成し、API Server でSpark データのAPI を追加しました。これで、OData 形式のSpark データをREST API で利用できます。API Server の「API」ページから、API のエンドポイントを表示およびコピーできます。

SAP Lumira からSpark への接続

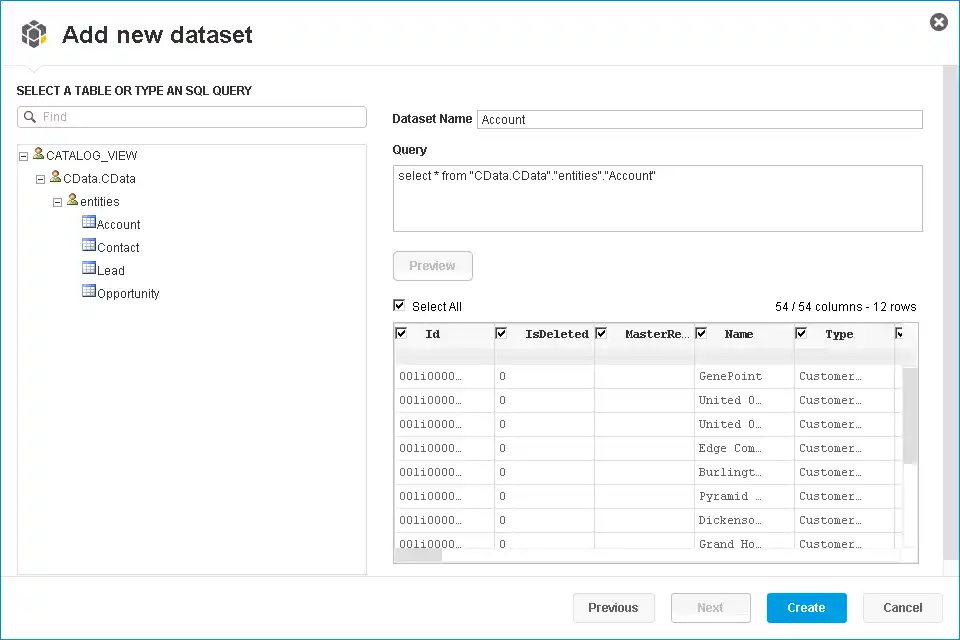

以下のステップに従って、Spark をSAP Lumira に取得します。SQL クエリを実行するか、UI を使用できます。

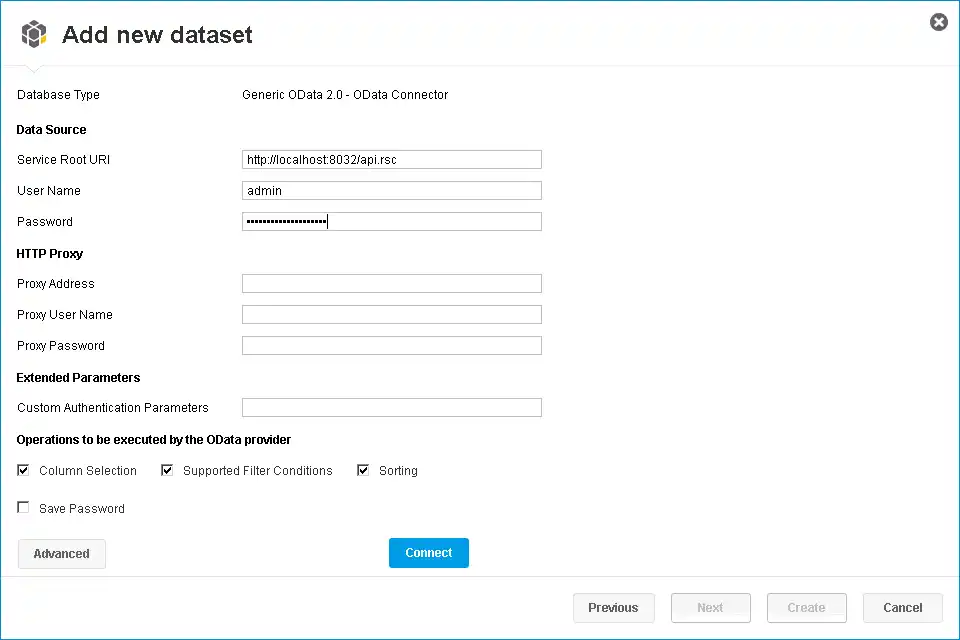

- SAP Lumira で[File]->[New]->[Query with SQL]とクリックします。Add New Dataset ダイアログが表示されます。

- [Generic]セクションを展開し、[Generic OData 2.0 Connector]オプションをクリックします。

-

[Service Root URI]ボックスに、API Server のOData エンドポイントを入力します。URL は次の例のようになります。

https://your-server:8032/api.rsc

-

[User Name]と[Password]のボックスにAPI ユーザーのユーザー名と認証トークンを入力します。これらの資格情報は、HTTP 基本認証で使用されます。

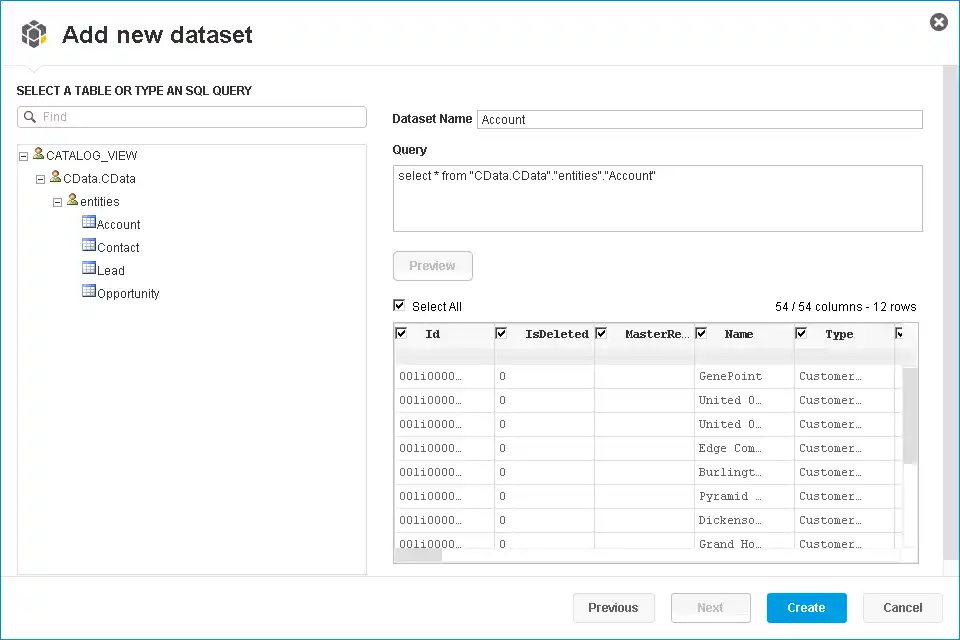

ツリーでエンティティを選択するか、SQL クエリを入力します。この記事では、Spark Customers エンティティをインポートします。

-

[Connect]をクリックすると、SAP Lumira は対応するOData 要求を生成し、結果をメモリにロードします。その後、フィルタ、集計、要約関数など、SAP Lumira で使用可能な任意のデータ処理ツールを使用できます。

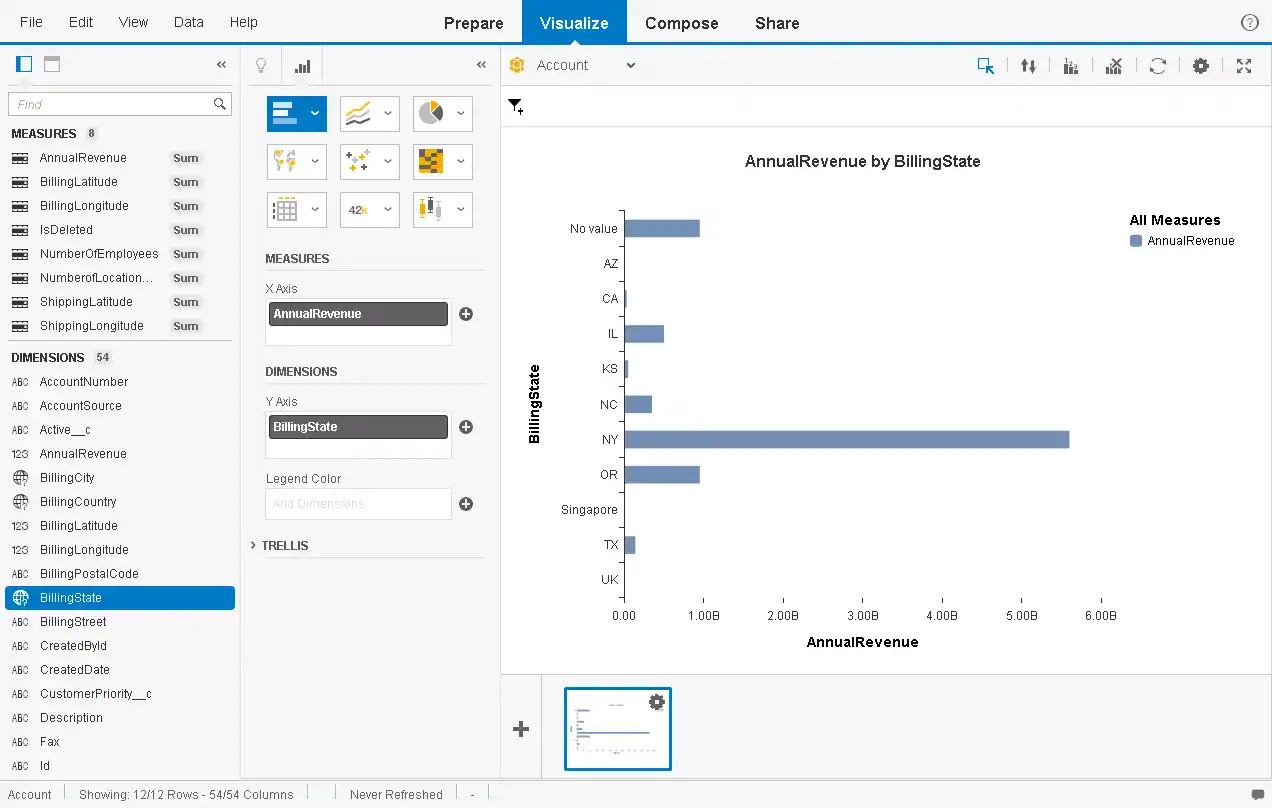

データのビジュアライゼーションを作成

データをインポートした後、[Visualize]ルームでデータのビジュアライゼーションを作成できます。以下のステップに従って、基本グラフを作成します。

[Measures and Dimensions]ペインで、メジャーとディメンションを[Visualization Tools]ペインの[x-axis]フィールドと[y-axis]フィールドにドラッグします。SAP Lumira は、API Server のメタデータサービスからディメンションとメジャーを自動的に検出します。

デフォルトでは、SUM 関数はすべてのメジャーに適用されます。メジャーの横にある歯車のアイコンをクリックしてデフォルトの要約を変更します。

- [Visualization Tools]ペインで、グラフの種類を選択します。

- [Chart Canvas]ペインで、フィルタを適用し、メジャーで並べ替え、ランキングを追加して現在のSpark でグラフを更新します。