CData JDBC Driver for Spark で SAP BusinessObjects ユニバースを作成

この記事では、CData JDBC Driver for Spark を使用して、SAP BusinessObjects Business Intelligence アプリケーションから Spark に接続する方法を説明します。Information Design Tool を使用してSpark のデータを分析し、CData JDBC Driver for Spark 上にユニバースを作成します。その後、Web Intelligence からユニバースに接続します。

Spark への JDBC 接続を作成

以下の手順に従って、Information Design Tool で Spark JDBC データソースへの接続を作成します。

- CData の JAR ファイルと .lic ファイルを BusinessObjects インストールディレクトリの dataAccess\connectionServer\jdbc\drivers\jdbc サブフォルダにコピーします。CData の JAR ファイルは、インストールディレクトリの lib サブフォルダにあります。

- プロジェクトを右クリックし、New -> New Relational Connection をクリックします。

- 表示されるウィザードで、Generic -> Generic JDBC datasource -> JDBC Drivers をクリックします。

- ウィザードの次のページで、接続の詳細を入力します。

次のページで、Authentication Mode オプションを「Use specified username and password」に設定します。ユーザー名、パスワード、JDBC URL を入力します。JDBC URL は jdbc:sparksql: で始まり、セミコロン区切りの接続プロパティが続きます。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

ビルトイン接続文字列デザイナ

JDBC URL の構成については、Spark JDBC Driver に組み込まれている接続文字列デザイナを使用できます。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行してください。

java -jar cdata.jdbc.sparksql.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

JDBC URL を設定する際に、Max Rows 接続プロパティの設定も検討してください。返される行数を制限することで、特にレポートやビジュアライゼーションの設計時にパフォーマンスを向上させることができます。

以下は一般的な JDBC URL です:

jdbc:sparksql:Server=127.0.0.1;

- ドライバークラスを入力します:cdata.jdbc.sparksql.SparkSQLDriver

- 接続プーリングとカスタムパラメータのデフォルト値でウィザードを完了します。

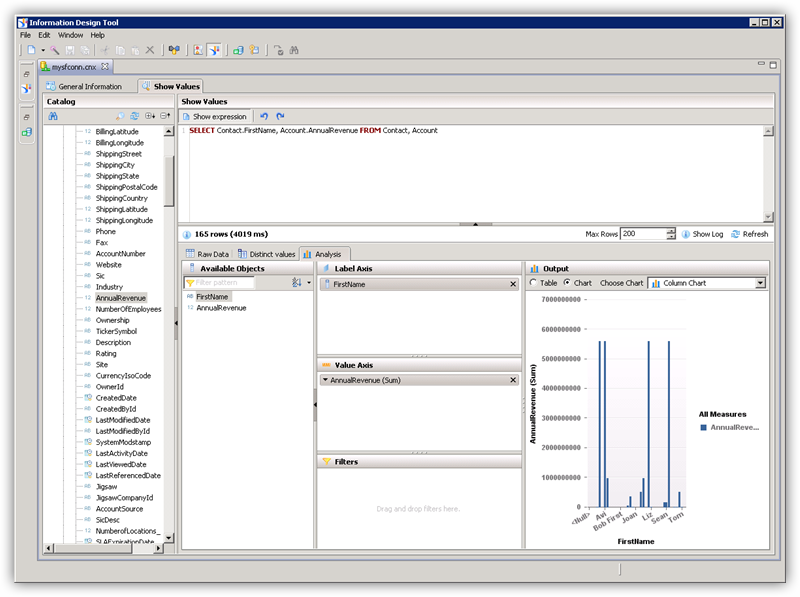

Information Design Tool で Spark のデータ を分析

JDBC 接続を使用して、Information Design Tool でSpark のデータを分析できます。

- Local Projects ビューで、接続(.cnx ファイル)をダブルクリックして Spark データソースを開きます。

- Show Values タブでは、テーブルデータをロードしたり SQL クエリを入力したりできます。テーブルデータを表示するには、テーブルのノードを展開し、テーブルを右クリックして Show Values をクリックします。値が Raw Data タブに表示されます。

- Analysis タブでは、カラムをチャートの軸にドラッグ&ドロップしてデータを分析できます。

ローカル接続を公開

ユニバースを CMS に公開するには、接続も公開する必要があります。

- Local Projects ビューで、接続を右クリックし、Publish Connection to a Repository をクリックします。

- リポジトリのホストとポート、接続の認証情報を入力します。

- 接続を公開するフォルダを選択します。

- 表示される成功ダイアログで Yes をクリックして、接続のショートカットを作成します。

JDBC Driver for Spark でユニバースを作成

以下の手順に従って、JDBC ドライバー上にユニバースを作成します。この例のユニバースはリポジトリに公開されるため、前のステップで作成した公開済み接続を使用します。

- Information Design Tool で、File -> New Universe をクリックします。

- プロジェクトを選択します。

- リレーショナルデータソース上にユニバースを作成するオプションを選択します。

- 公開済み接続へのショートカットを選択します。

- Data Foundation の名前を入力します。

- オブジェクトとしてアクセスしたいテーブルとカラムをインポートします。

- Business Layer の名前を入力します。

ユニバースを公開

以下の手順に従って、ユニバースを CMS に公開します。

- Local Projects ビューで、ビジネスレイヤーを右クリックし、Publish -> To a Repository をクリックします。

- Publish Universe ダイアログで、インポート前の整合性チェックを入力します。

- ユニバースを公開するリポジトリ上のフォルダを選択または作成します。

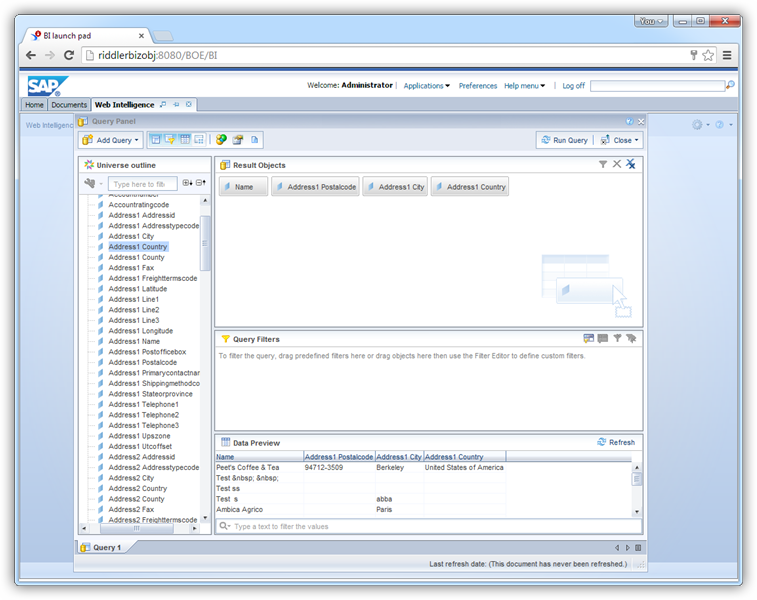

Web Intelligence で Spark のデータ をクエリ

公開されたユニバースを使用して、Web Intelligence から Spark に接続できます。

- cdata.jdbc.sparksql.lic ファイルを BusinessObjects インストールディレクトリの \dataAccess\connectionServer\jdbc\drivers\jdbc サブフォルダにコピーします。ライセンスファイルは、インストールディレクトリの lib サブフォルダにあります。

- BusinessObjects ランチパッドから Web Intelligence を開き、新しいドキュメントを作成します。

- データソースとして Universe オプションを選択します。

- Spark ユニバースを選択します。これによりクエリパネルが開きます。Result Objects ペインにオブジェクトをドラッグして、クエリで使用します。