Denodo Platform で Spark のデータ に接続

Denodo Platform は、エンタープライズデータベースのデータを統合的に扱うことができるデータ仮想化製品です。CData JDBC Driver for Apache Spark と組み合わせることで、Denodo ユーザーは他のエンタープライズデータソースと並んでライブ Spark のデータ を扱うことができます。本記事では、Denodo Virtual DataPort Administrator で Spark 用の仮想データソースを作成する方法を解説します。

CData JDBC Driver は、最適化されたデータ処理機能を内蔵しており、ライブ Spark のデータ とのやり取りにおいて比類のないパフォーマンスを提供します。Spark に対して複雑な SQL クエリを発行すると、ドライバーはフィルターや集計などのサポートされている SQL 操作を直接 Spark にプッシュし、内蔵の SQL エンジンを使用してサポートされていない操作(主に SQL 関数や JOIN 操作)をクライアントサイドで処理します。また、動的メタデータクエリ機能を内蔵しているため、ネイティブデータ型を使用して Spark のデータ を操作・分析できます。

Spark 仮想ポートの作成

Denodo からライブ Spark のデータ に接続するには、JDBC Driver の JAR ファイルを Denodo の外部ライブラリディレクトリにコピーし、Virtual DataPort Administrator ツールで新しい JDBC データソースを作成します。

- CData JDBC Driver for Apache Spark インストーラーをダウンロードし、パッケージを解凍して JAR ファイルを実行してドライバーをインストールします。

- インストール先(通常は C:\Program Files\CData\CData JDBC Driver for Apache Spark\lib\)から JAR ファイル(およびライセンスファイルが存在する場合はそれも)を Denodo 外部ライブラリディレクトリ(C:\Denodo\Denodo Platform\lib-external\jdbc-drivers\cdata-sparksql-19)にコピーします。

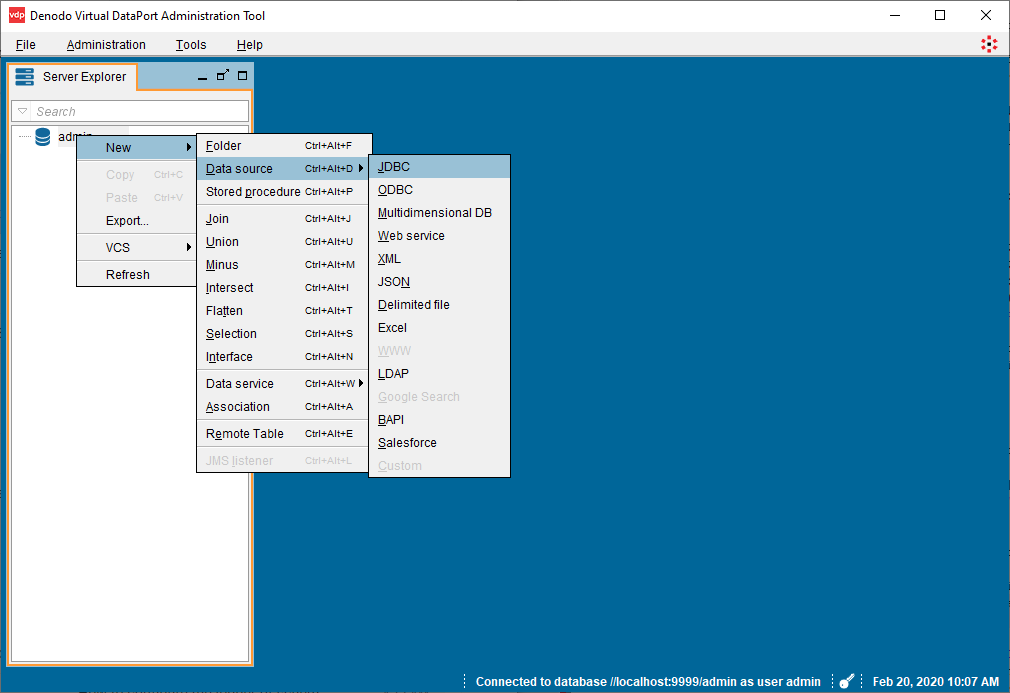

- Denodo Virtual DataPort Administrator ツールを開き、Server Explorer タブに移動します。

- "admin" を右クリックし、New -> Data source -> JDBC を選択します。

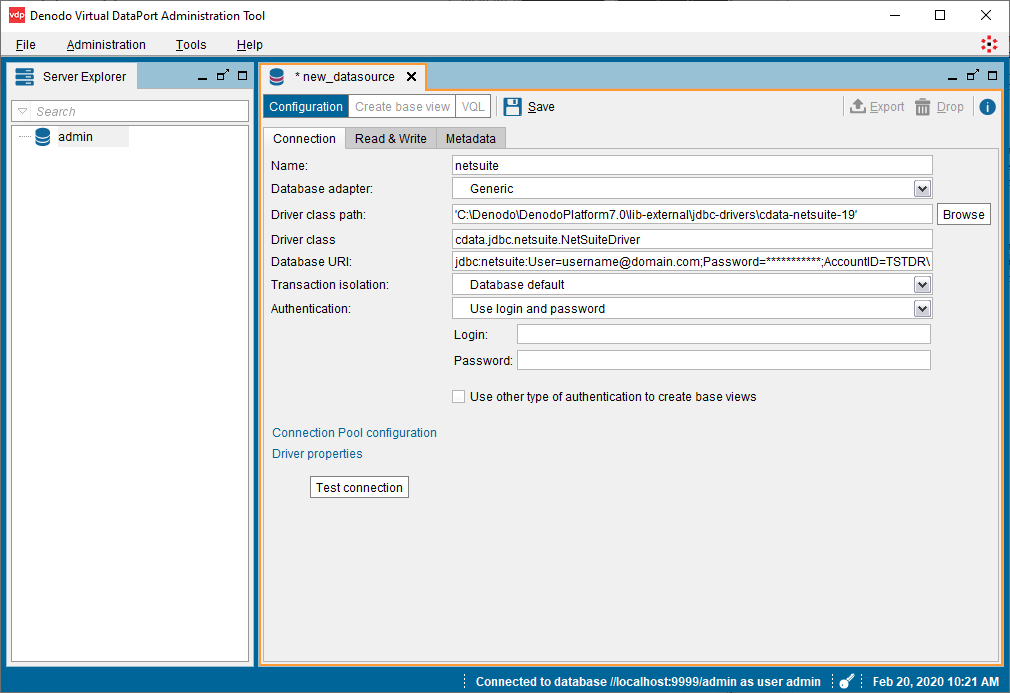

- JDBC 接続を設定します:

- Name: 任意の名前(例: sparksql)

- Database adapter: Generic

- Driver class path: C:\Denodo\Denodo Platform\lib-external\jdbc-drivers\cdata-sparksql-19

- Driver class: cdata.jdbc.sparksql.SparkSQLDriver

Database URI: 必要な接続プロパティを使用して JDBC URL を設定します。例:

jdbc:sparksql:Server=127.0.0.1;

Database URI の作成方法は以下のとおりです:

ビルトイン接続文字列デザイナー

JDBC URL の構築には、Spark JDBC Driver に組み込まれた接続文字列デザイナーを使用できます。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行してください。

java -jar cdata.jdbc.sparksql.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

- "Test connection" ボタンをクリックして設定を確認し、Save をクリックします。

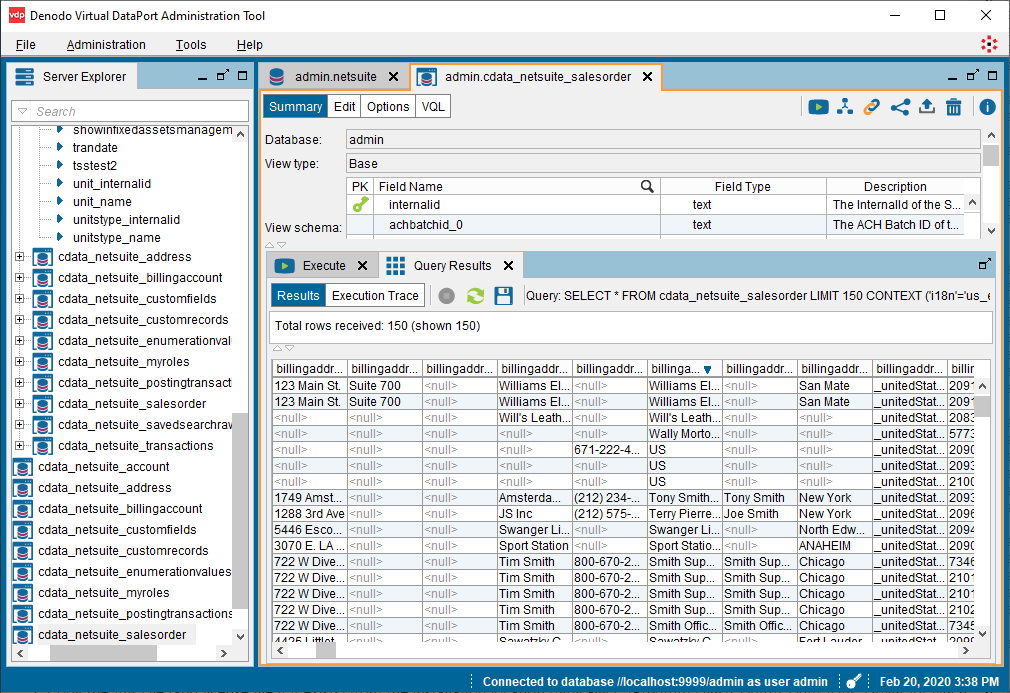

VirtualPort Administrator ツールで Spark のデータ を表示

データソースを作成したら、Denodo Platform で使用する Spark のデータ のベースビューを作成できます。

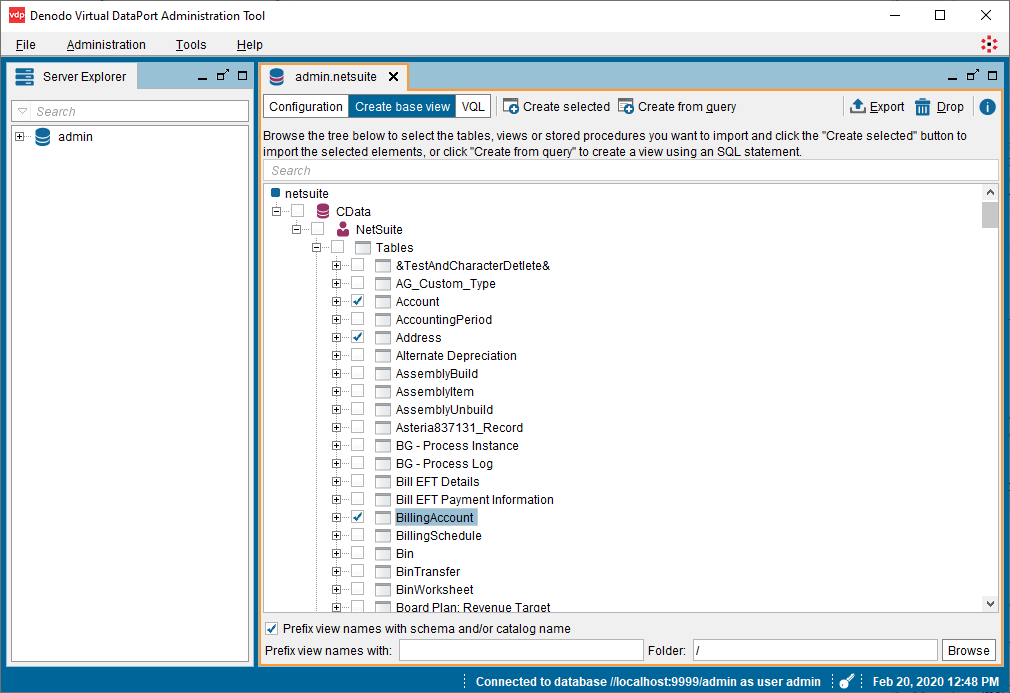

- 新しく作成した VirtualPort (admin.SparkSQL) で "Create base view" ボタンをクリックします。

- オブジェクトツリーを展開し、インポートするオブジェクト(テーブル)を選択します。

- "Create selected" ボタンをクリックして、Spark のデータ のビューを作成します。

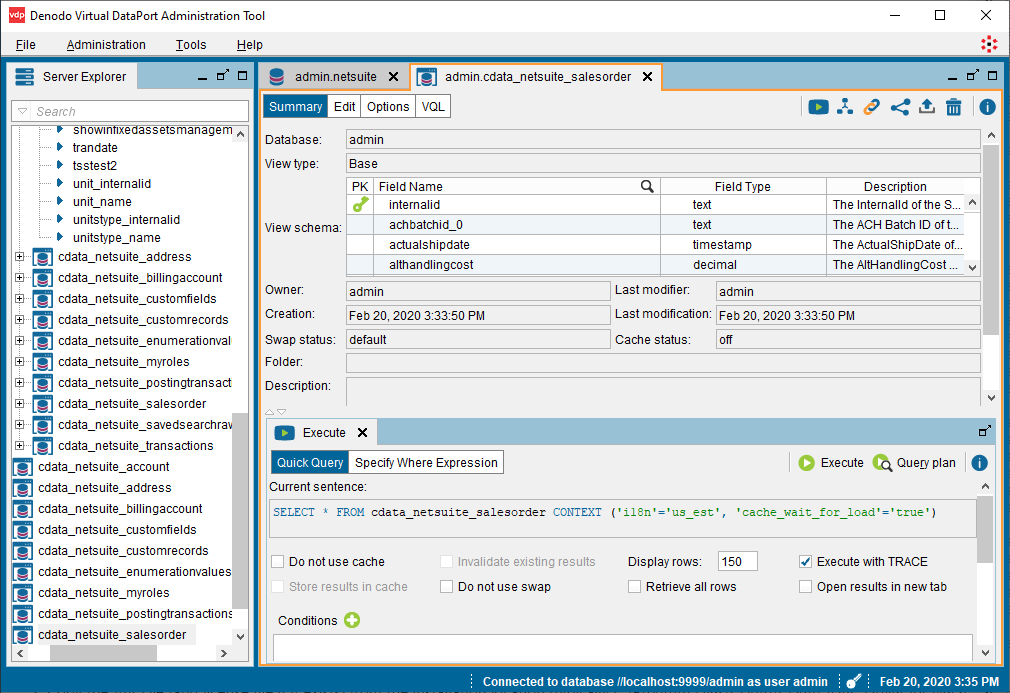

オプション: "Create associations from foreign keys" をクリックして、オブジェクト間のリレーションシップを定義できます。 - ビューが作成されたら、Server Explorer で対象テーブル(cdata_sparksql_customers)に移動し、選択したテーブルをダブルクリックします。

- 新しいタブで "Execution panel" をクリックしてクエリパネルを開きます。

- "Execute" タブでクエリをカスタマイズするか、デフォルトのクエリを使用します:

SELECT * FROM cdata_sparksql_customers CONTEXT ('i18n'='us_est', 'cache_wait_for_load'='true')

- Execute をクリックしてデータを表示します。

ベースビューの作成後は、Denodo Platform の他のデータソースと同様にライブ Spark のデータ を扱うことができます。たとえば、Denodo Data Catalog で Spark をクエリできます。

CData JDBC Driver for Apache Spark の 30日間無料トライアルをダウンロードして、Denodo Platform でライブ Spark のデータ の活用を始めましょう。ご不明な点がございましたら、サポートチーム までお問い合わせください。