CloverDX(旧CloverETL)で Spark のデータ に接続

CData JDBC Driver for Spark を使用すると、CloverDX(旧CloverETL)のデータ変換コンポーネントで Spark をソースおよびデスティネーションとして扱えます。この記事では、JDBC Driver for Spark を使用して、フラットファイルへのシンプルな転送を設定する方法を説明します。

JDBC データソースとして Spark に接続

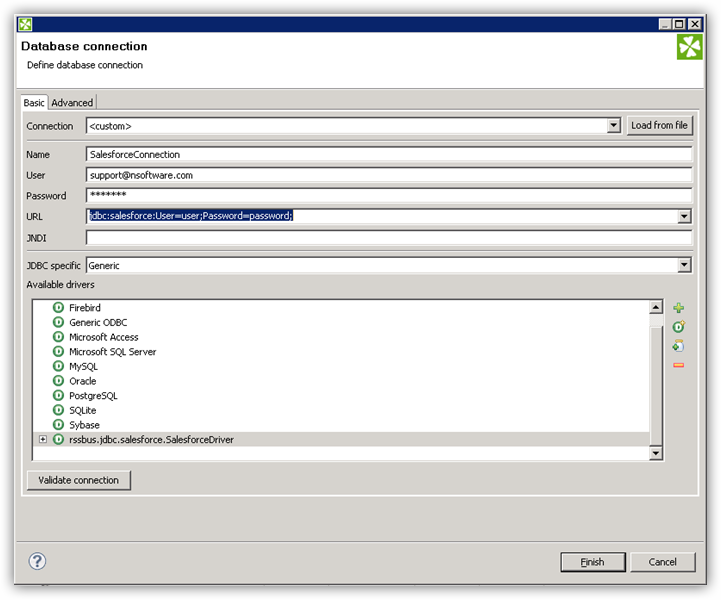

- Spark のデータ への接続を作成します。新規のCloverDX グラフで、Outline ペインの「Connections」ノードを右クリックし、「Connections」->「Create Connection」をクリックします。Database Connection ウィザードが表示されます。

- プラスアイコンをクリックし、JAR からドライバーをロードします。インストールディレクトリのlib サブフォルダを参照し、cdata.jdbc.sparksql.jar ファイルを選択します。

- JDBC URL を入力します。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

組み込みの接続文字列デザイナー

JDBC URL の構築には、Spark JDBC Driver に組み込まれている接続文字列デザイナーを使用してください。JAR ファイルをダブルクリックするか、コマンドラインから実行します。

java -jar cdata.jdbc.sparksql.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

一般的なJDBC URL は次のようになります:

jdbc:sparksql:Server=127.0.0.1;

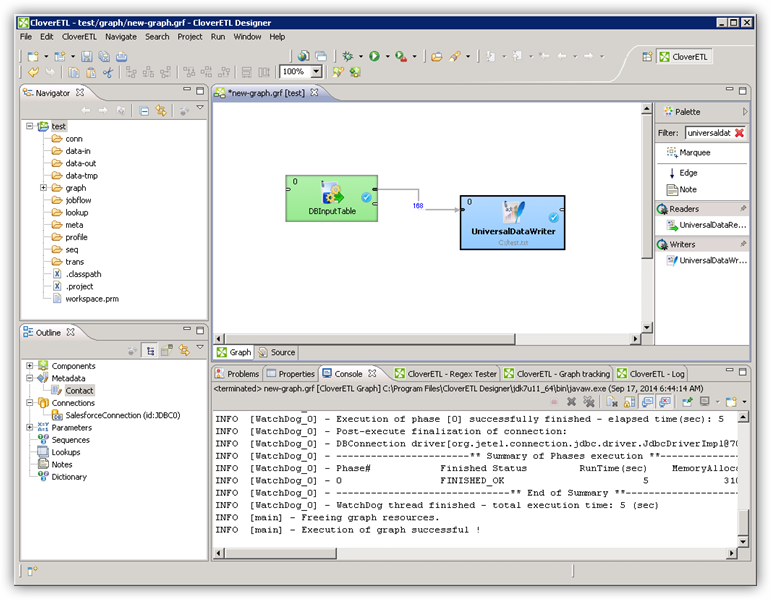

DBInputTable コンポーネントで Spark のデータ をクエリ

- Palette の「Readers」から「DBInputTable」をジョブフローにドラッグし、ダブルクリックして設定エディターを開きます。

- 「DB connection」プロパティで、ドロップダウンメニューから Spark JDBC データソースを選択します。

- SQL クエリを入力します。例:

SELECT City, Balance FROM Customers

クエリの出力をUniversalDataWriter に書き込む

- 「Writers」から「UniversalDataWriter」をジョブフローにドラッグします。

- UniversalDataWriter をダブルクリックして設定エディターを開き、ファイルURL を追加します。

- DBInputTable を右クリックし、「Extract Metadata」をクリックします。

- DBInputTable の出力ポートをUniversalDataWriter に接続します。

- UniversalDataWriter の「Select Metadata」メニューで、Customers テーブルを選択します。(このメニューはUniversalDataWriter の入力ポートを右クリックしても開けます。)

- 「Run」をクリックして、ファイルに書き込みます。