Apache Airflow で Okta データを連携

Apache Airflow は、データエンジニアリングワークフローの作成、スケジューリング、モニタリングをサポートするツールです。 CData JDBC Driver for Okta と組み合わせることで、Airflow からリアルタイムの Okta のデータ を扱うことができます。 この記事では、Apache Airflow インスタンスから Okta のデータ に接続してクエリを実行し、結果を CSV ファイルに保存する方法を説明します。

CData JDBC ドライバーは、最適化されたデータ処理機能を組み込んでおり、 リアルタイムの Okta のデータ を扱う際に比類のないパフォーマンスを発揮します。複雑な SQL クエリを Okta に発行すると、 ドライバーはフィルタや集計などのサポートされている SQL 操作を直接 Okta にプッシュし、 サポートされていない操作(主に SQL 関数や JOIN 操作)は組み込みの SQL エンジンを使用してクライアント側で処理します。 また、組み込みの動的メタデータクエリ機能により、ネイティブのデータ型を使用して Okta のデータ の操作・分析が可能です。

Okta への接続を設定

組み込みの接続文字列デザイナー

JDBC URL の構築には、Okta JDBC Driver に組み込まれている接続文字列デザイナーを使用できます。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行してください。

java -jar cdata.jdbc.okta.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

Okta に接続するには、Domain 接続文字列プロパティをお使いのOkta ドメインに設定します。 Okta はOAuth およびOAuthJWT 認証をサポートしています。

OAuth認証

OAuth で認証するには、AuthScheme をOAuth に設定する必要があります。また、カスタムOAuth アプリケーションを作成する必要があります。

カスタムOAuth アプリケーションの作成

Okta アカウントから:

- 管理者アカウントでOkta のデベロッパーエディションにサインインします。

- Admin Consoleで、Applications > Applications に移動します。

- Create App Integration をクリックします。

- Sign-in method は、OIDC - OpenID Connect を選択します。

- Application type は、Web Application を選択します。

- カスタムアプリケーションの名前を入力します。

- Grant TypeをAuthorization Code に設定します。トークンを自動的に更新したい場合は、Refresh Token もチェックしてください。

- コールバックURL を設定します。

- デスクトップアプリケーションやヘッドレスマシンでは、http://localhost:33333 または任意の別のポート番号を使用します。ここで設定したURI が、CallbackURL プロパティになります。

- Web アプリケーションの場合、コールバックURL を信頼できるリダイレクトURL に設定します。このURL は、アプリケーションへのアクセスが許可されたことを示すトークンを伴ってユーザーが戻ってくるWeb 上の場所です。

- Assignments セクションで、Limit access to selected groups を選択してグループを追加するか、グループの割り当ては一旦スキップします。

- OAuth アプリケーションを保存します。

- アプリケーションのGeneral タブに、アプリケーションのClient Id とClient Secret が表示されます。後で使用できるように、これらを記録してください。Client Id はOAuthClientId の設定に使用し、Client Secret はOAuthClientSecret の設定に使用します。

- Assignments タブを確認し、アプリケーションにアクセスする必要のあるすべてのユーザーがアプリケーションに割り当てられていることを確かめます。

- Okta API Scopes タブで、OAuth アプリケーションに付与するスコープを選択します。これらのスコープは、アプリが読み取り可能なデータを決定します。そのため、特定のビューに対するスコープを付与しないと、そのビューに対するクエリを実行する権限がドライバーに付与されません。各ビューに必要なスコープを確認するには、ヘルプドキュメントのデータモデル > ビュー のビュー固有のページを参照してください。

OAuth 認証の詳細や、OAuthJWT 認証については、ヘルプドキュメントを参照してください。

クラスター環境やクラウドで JDBC ドライバーをホストする場合は、ライセンス(製品版またはトライアル版)とランタイムキー(RTK)が必要です。ライセンス(またはトライアル)の取得については、弊社営業チームにお問い合わせください。

以下は、JDBC 接続に必要な主なプロパティです。

| プロパティ | 値 |

|---|---|

| データベース接続 URL | jdbc:okta:RTK=5246...;Domain=dev-44876464.okta.com; |

| データベースドライバークラス名 | cdata.jdbc.okta.OktaDriver |

Airflow で JDBC 接続を設定

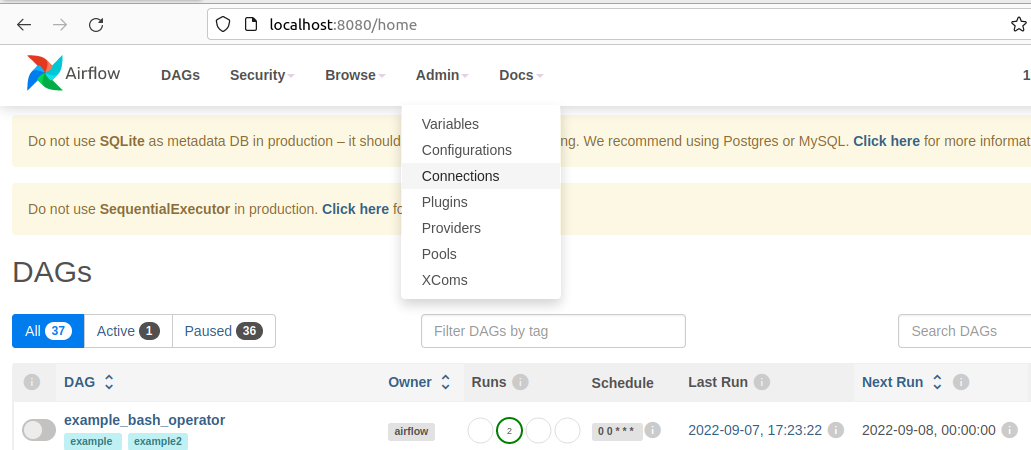

- Apache Airflow インスタンスにログインします。

- Airflow インスタンスのナビゲーションバーで、Admin にカーソルを合わせ、Connections をクリックします。

- 次の画面で + ボタンをクリックして、新しい接続を作成します。

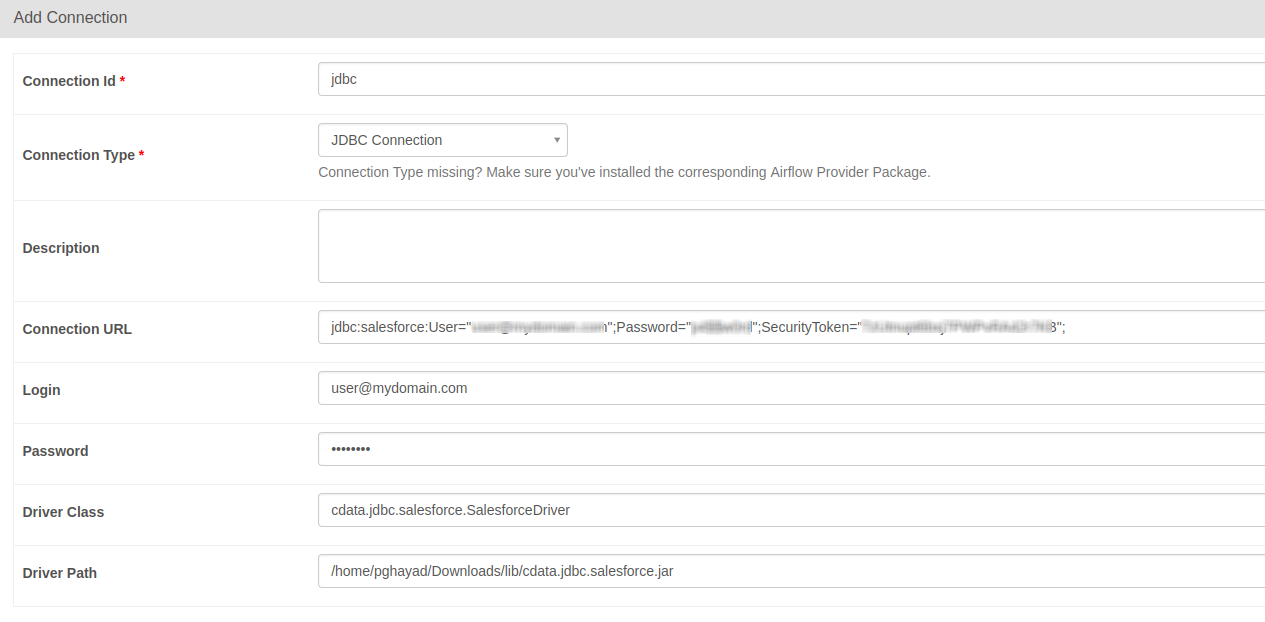

- Add Connection フォームで、必要な接続プロパティを入力します:

- Connection Id:接続の名前を入力します(例:okta_jdbc)

- Connection Type:JDBC Connection

- Connection URL:上記の JDBC 接続 URL(例:jdbc:okta:RTK=5246...;Domain=dev-44876464.okta.com;)

- Driver Class:cdata.jdbc.okta.OktaDriver

- Driver Path:PATH/TO/cdata.jdbc.okta.jar

- フォーム下部の Test ボタンをクリックして、新しい接続をテストします。

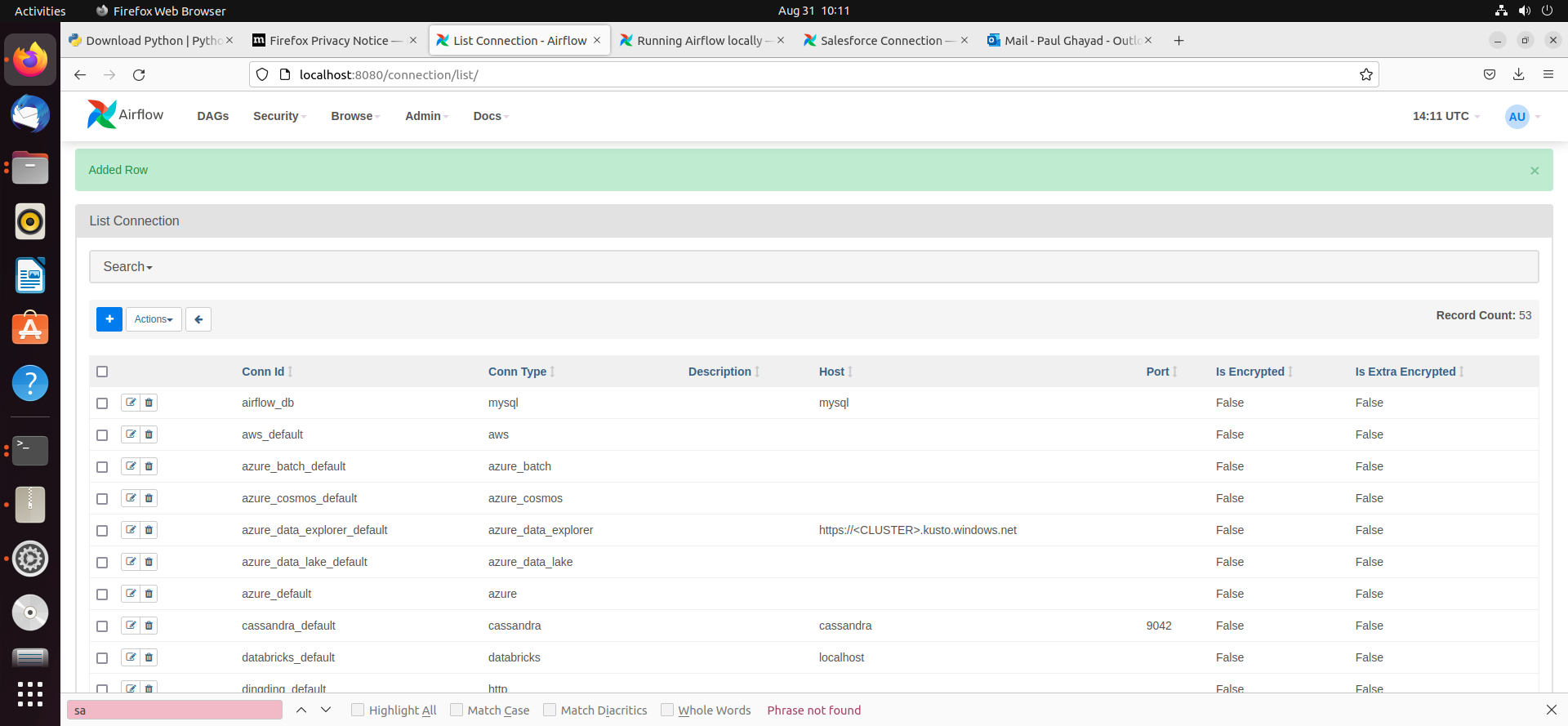

- 新しい接続を保存すると、次の画面で接続リストに新しい行が追加されたことを示す緑色のバナーが表示されます。

DAG の作成

Airflow の DAG は、ワークフローのプロセスを保存し、トリガーすることでワークフローを実行できるエンティティです。 ここでのワークフローは、Okta のデータ に対して SQL クエリを実行し、結果を CSV ファイルに保存するというシンプルなものです。

- まず、ホームディレクトリに「airflow」フォルダがあるはずです。その中に「dags」という新しいディレクトリを作成します。 ここに Python ファイルを保存すると、UI 上で Airflow DAG として表示されます。

- 次に、新しい Python ファイルを作成し、okta_hook.py という名前を付けます。このファイルに以下のコードを挿入してください:

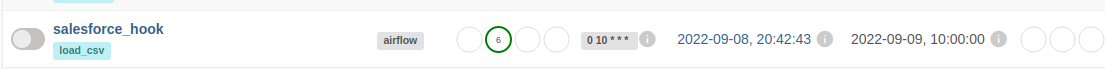

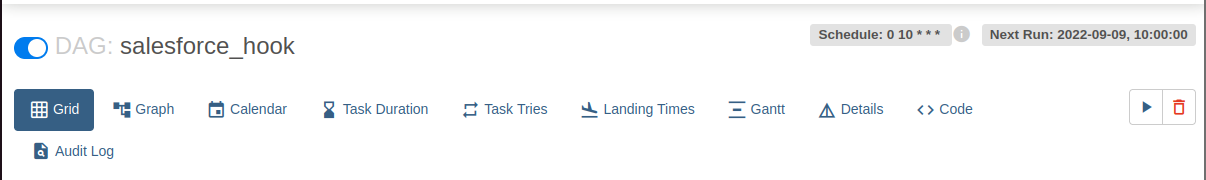

import time from datetime import datetime from airflow.decorators import dag, task from airflow.providers.jdbc.hooks.jdbc import JdbcHook import pandas as pd # DAG を宣言 @dag(dag_id="okta_hook", schedule_interval="0 10 * * *", start_date=datetime(2022,2,15), catchup=False, tags=['load_csv']) # DAG 関数を定義 def extract_and_load(): # タスクを定義 @task() def jdbc_extract(): try: hook = JdbcHook(jdbc_conn_id="jdbc") sql = """ select * from Account """ df = hook.get_pandas_df(sql) df.to_csv("/{some_file_path}/{name_of_csv}.csv",header=False, index=False, quoting=1) # print(df.head()) print(df) tbl_dict = df.to_dict('dict') return tbl_dict except Exception as e: print("Data extract error: " + str(e)) jdbc_extract() sf_extract_and_load = extract_and_load() - このファイルを保存し、Airflow インスタンスを更新します。DAG のリストに「okta_hook」という新しい DAG が表示されるはずです。

- この DAG をクリックし、次の画面で一時停止スイッチをクリックして青色にオンにします。次に、トリガー(再生)ボタンをクリックして DAG を実行します。これにより、okta_hook.py ファイル内の SQL クエリが実行され、コード内で指定したファイルパスに CSV として結果がエクスポートされます。

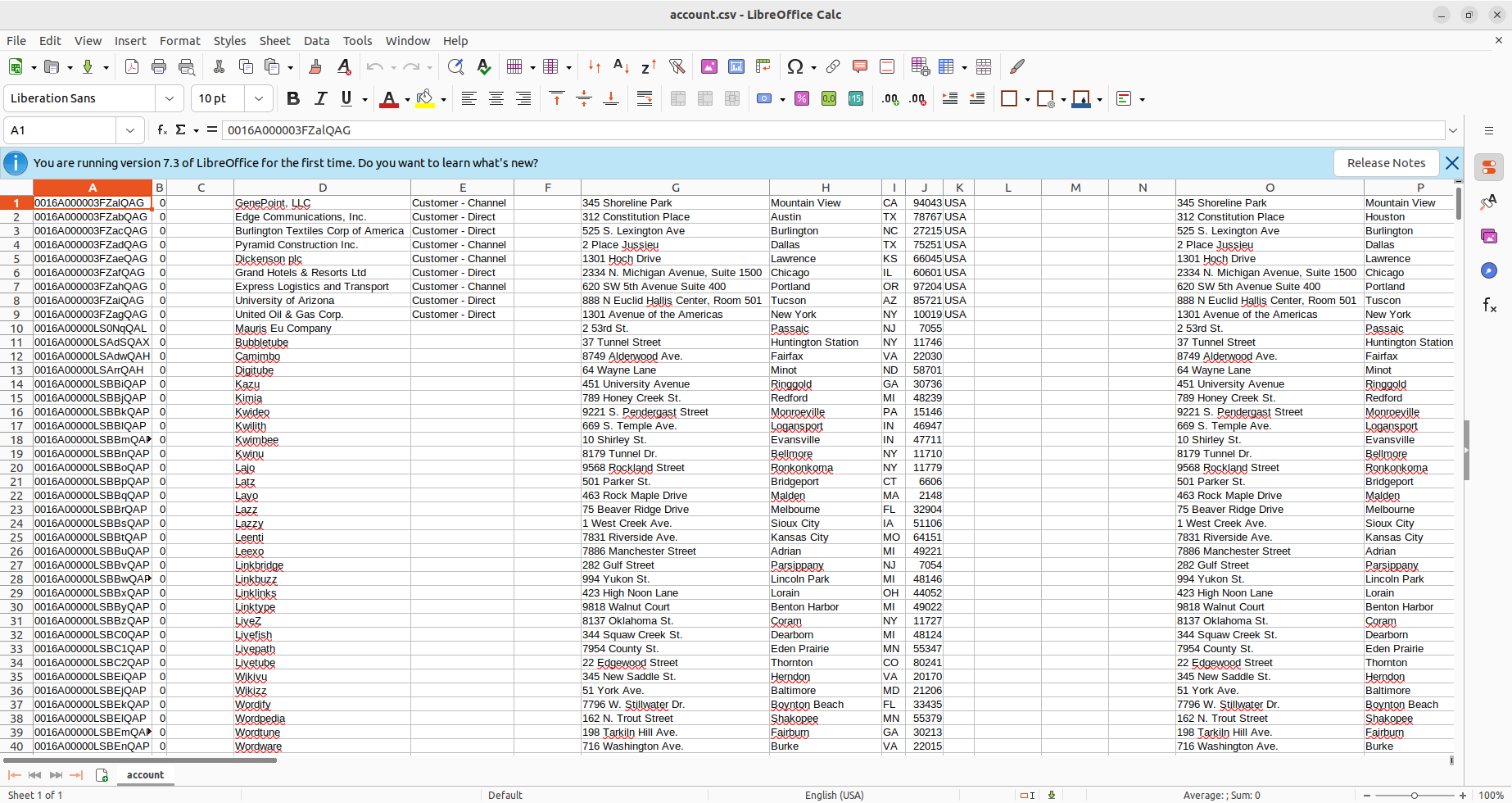

- 新しい DAG をトリガーした後、Downloads フォルダ(または Python スクリプト内で指定した場所)を確認すると、CSV ファイルが作成されていることがわかります。この例では account.csv です。

- CSV ファイルを開くと、Apache Airflow によって Okta のデータ が CSV 形式で利用可能になっていることを確認できます。