Google Data Fusion で Google Cloud Storage に連携した ETL プロセスを作成

Google Data Fusion を使用すると、セルフサービス型のデータ連携を行い、異なるデータソースを統合できます。CData JDBC Driver for Google Cloud Storage をアップロードすることで、Google Data Fusion のパイプライン内から Google Cloud Storage のデータ にリアルタイムでアクセスできるようになります。CData JDBC Driver を使用すると、Google Cloud Storage のデータ を Google Data Fusion でネイティブにサポートされている任意のデータソースにパイプできますが、この記事では、Google Cloud Storage から Google BigQuery へデータをパイプする方法を説明します。

CData JDBC Driver for Google Cloud Storage を Google Data Fusion にアップロード

CData JDBC Driver for Google Cloud Storage を Google Data Fusion インスタンスにアップロードして、Google Cloud Storage のデータ にリアルタイムでアクセスしましょう。Google Data Fusion では JDBC ドライバーの命名規則に制限があるため、JAR ファイルを driver-version.jar という形式に合わせてコピーまたはリネームしてください。例:cdatagooglecloudstorage-2020.jar

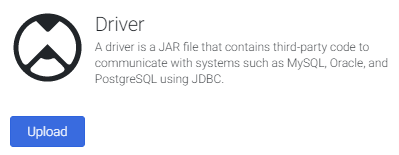

- Google Data Fusion インスタンスを開きます

- をクリックしてエンティティを追加し、ドライバーをアップロードします

- "Upload driver" タブで、リネームした JAR ファイルをドラッグまたは参照します。

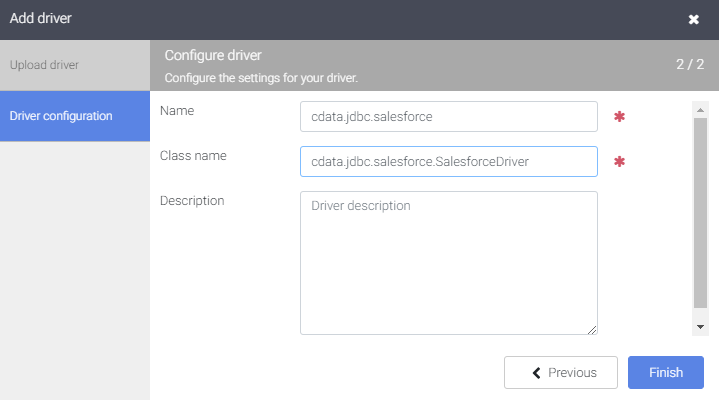

- "Driver configuration" タブで以下を設定します:

- Name: ドライバーの名前(cdata.jdbc.googlecloudstorage)を作成し、メモしておきます

- Class name: JDBC クラス名を設定します:(cdata.jdbc.googlecloudstorage.GoogleCloudStorageDriver)

- "Finish" をクリックします

Google Data Fusion で Google Cloud Storage のデータ に接続

JDBC Driver をアップロードしたら、Google Data Fusion のパイプラインで Google Cloud Storage のデータ にリアルタイムでアクセスできます。

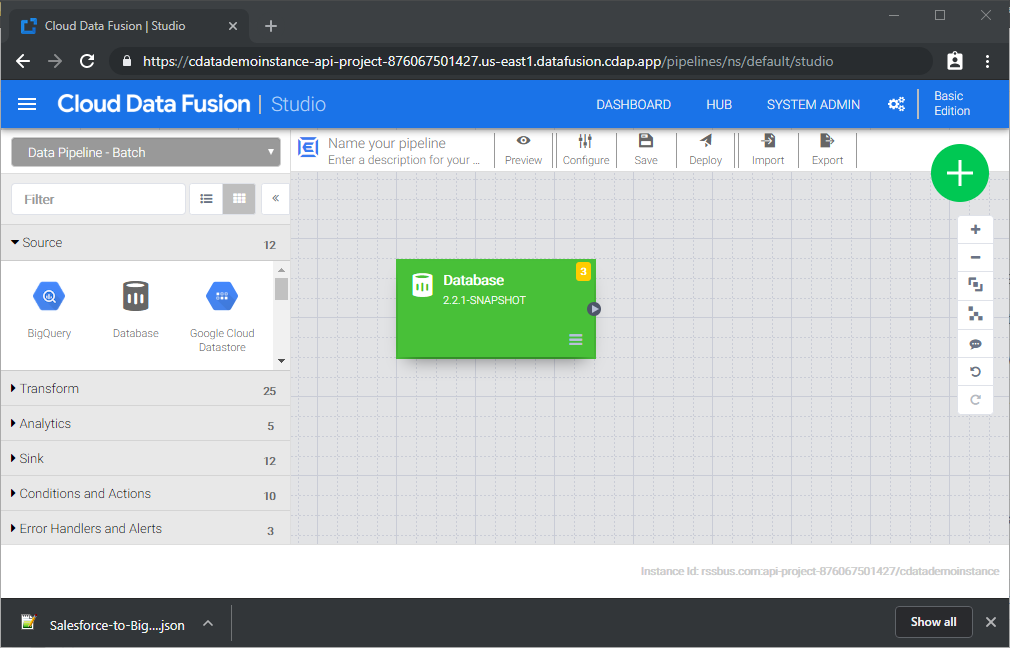

- Pipeline Studio に移動して、新しいパイプラインを作成します

- "Source" オプションから "Database" をクリックして、JDBC Driver 用のソースを追加します

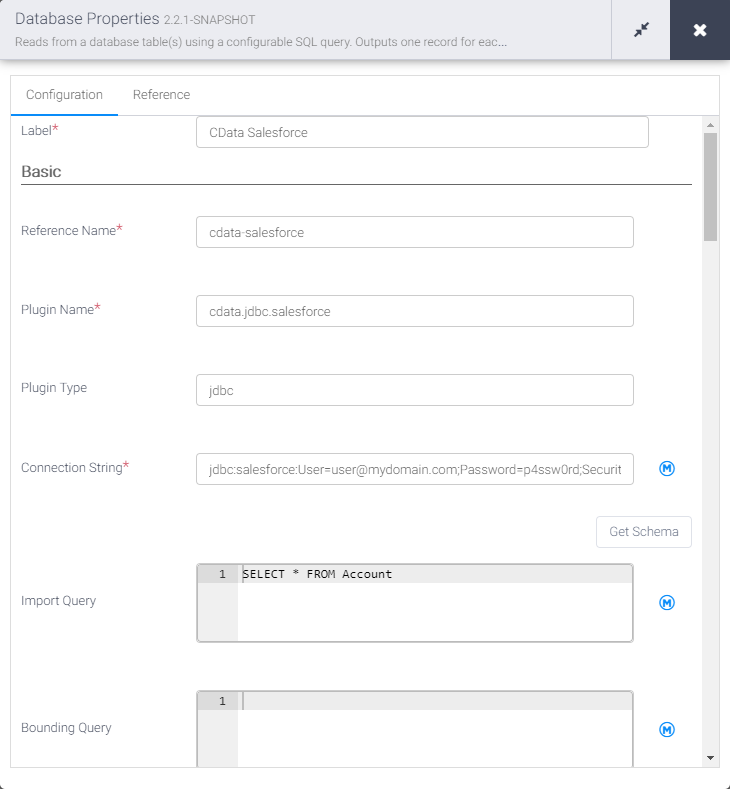

- Database ソースの "Properties" をクリックしてプロパティを編集します

NOTE:Google Data Fusion で JDBC Driver を使用するには、ライセンス(製品版またはトライアル)とランタイムキー(RTK)が必要です。ライセンス(またはトライアル)の取得については、CData までお問い合わせください。

- Label を設定します

- Reference Name を将来の参照用の値に設定します(例:cdata-googlecloudstorage)

- Plugin Type を "jdbc" に設定します

- Connection String を Google Cloud Storage の JDBC URL に設定します。例:

jdbc:googlecloudstorage:RTK=5246...;ProjectId='project1';ユーザーアカウントでの認証

ユーザー資格情報の接続プロパティを設定することなく接続できます。InitiateOAuth をGETANDREFRESH に設定したら、接続の準備が完了です。

接続すると、Google Cloud Storage OAuth エンドポイントがデフォルトブラウザで開きます。ログインして権限を付与すると、OAuth プロセスが完了します。

サービスアカウントでの認証

サービスアカウントには、ブラウザでユーザー認証を行わないサイレント認証があります。サービスアカウントを使用して、企業全体のアクセススコープを委任することもできます。

このフローでは、OAuth アプリケーションを作成する必要があります。詳しくは、ヘルプドキュメントを参照してください。以下の接続プロパティを設定したら、接続の準備が完了です:

- InitiateOAuth: GETANDREFRESH に設定。

- OAuthJWTCertType: PFXFILE に設定。

- OAuthJWTCert: 生成した.p12 ファイルへのパスに設定。

- OAuthJWTCertPassword: .p12 ファイルのパスワードに設定。

- OAuthJWTCertSubject: 証明書ストアの最初の証明書が選ばれるように"*" に設定。

- OAuthJWTIssuer: 「サービスアカウント」セクションで「サービスアカウントの管理」をクリックし、このフィールドをサービスアカウントID フィールドに表示されているE メールアドレスに設定。

- OAuthJWTSubject: サブジェクトタイプが"enterprise" に設定されている場合はエンタープライズID に設定し、"user" に設定されている場合はアプリユーザーID に設定。

- ProjectId: 接続するプロジェクトのID に設定。

これで、サービスアカウントのOAuth フローが完了します。

ビルトイン接続文字列デザイナー

JDBC URL の作成には、Google Cloud Storage JDBC Driver に組み込まれている接続文字列デザイナーを使用できます。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行してください。

java -jar cdata.jdbc.googlecloudstorage.jar接続プロパティを入力し、接続文字列をクリップボードにコピーします。

- Import Query を Google Cloud Storage から取得したいデータを抽出する SQL クエリに設定します。例:

SELECT * FROM Buckets

- "Sink" タブから、同期先シンクを追加します(この例では Google BigQuery を使用します)

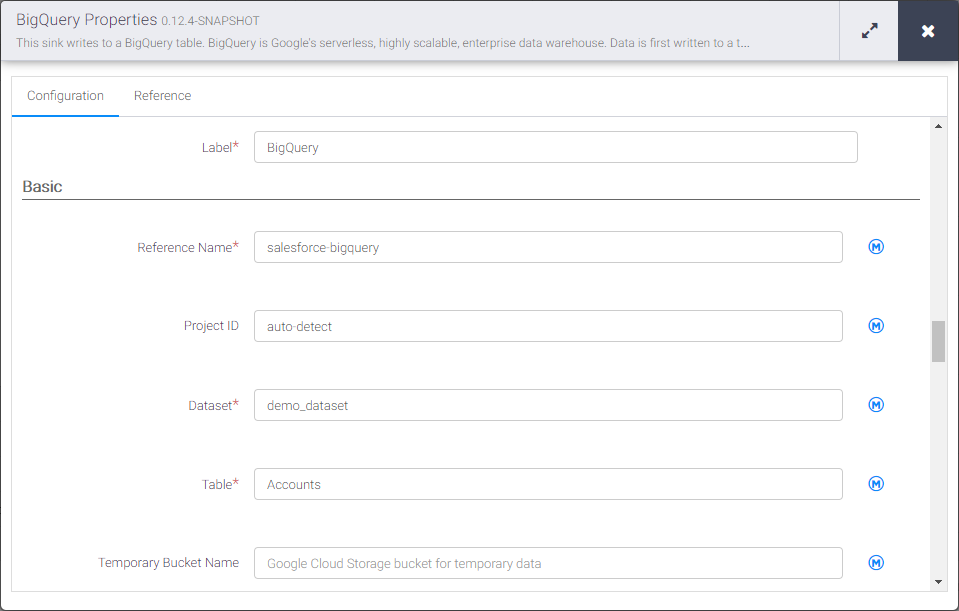

- BigQuery シンクの "Properties" をクリックしてプロパティを編集します

- Label を設定します

- Reference Name を googlecloudstorage-bigquery のような値に設定します

- Project ID を特定の Google BigQuery プロジェクト ID に設定します(またはデフォルトの "auto-detect" のままにします)

- Dataset を特定の Google BigQuery データセットに設定します

- Table を Google Cloud Storage のデータ を挿入するテーブル名に設定します

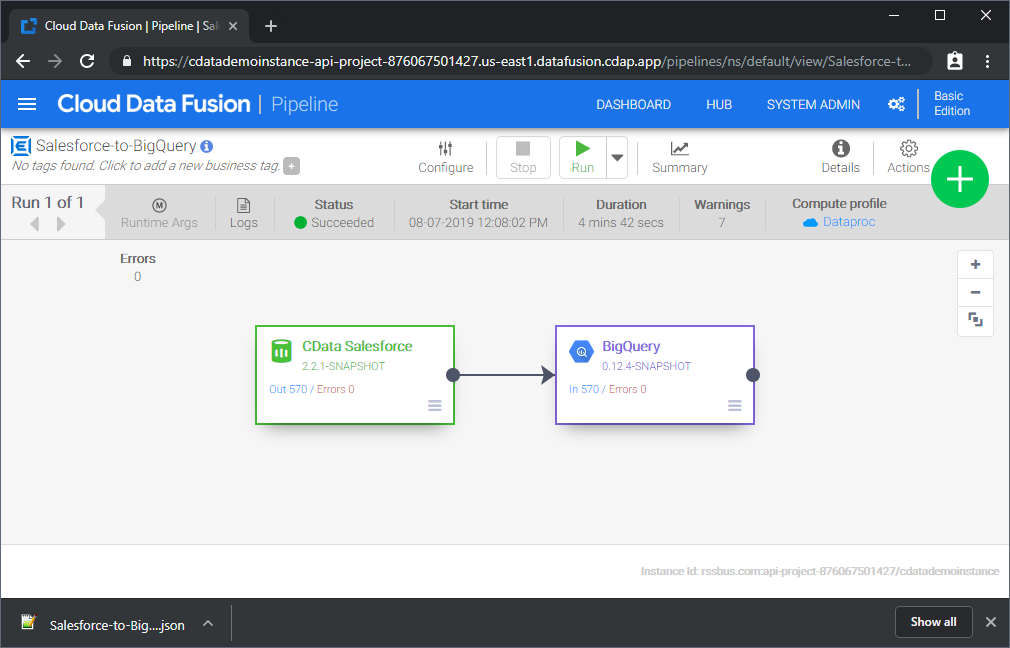

Source と Sink を設定すると、Google Cloud Storage のデータ を Google BigQuery にパイプする準備が整います。パイプラインを保存してデプロイしてください。パイプラインを実行すると、Google Data Fusion が Google Cloud Storage からリアルタイムデータをリクエストし、Google BigQuery にインポートします。

これはシンプルなパイプラインの例ですが、変換、分析、条件などを使用してより複雑な Google Cloud Storage パイプラインを作成できます。CData JDBC Driver for Google Cloud Storage の 30日間の無償トライアルをダウンロードして、今すぐ Google Data Fusion で Google Cloud Storage のデータ をリアルタイムで活用しましょう。