Oracle Data Integrator で Databricks データをETL

JDBC 標準を使用して、既存のスキルを活かしながらDatabricks に読み書きできます。 Oracle Data Integrator(ODI)などの ETL ツールにドロップインで統合できる CData JDBC Driver for Databricks を使えば、リアルタイムのDatabricks のデータをデータウェアハウス、ビジネスインテリジェンス、ビッグデータテクノロジーに接続できます。

JDBC 接続により、ODI でDatabricks を他のデータベースと同様に扱うことができます。RDBMS と同じように、フラットファイルではなくリアルタイムでDatabricks API に直接接続できます。

この記事では、JDBC ベースの ETL(Databricks から Oracle へ)の手順を説明します。Databricks エンティティのデータモデルをリバースエンジニアリングした後、マッピングを作成し、データロード戦略を選択します。ドライバーが SQL-92 をサポートしているため、組み込みの SQL to SQL Loading Knowledge Module を選択するだけで簡単に実現できます。

Databricks データ連携について

CData を使用すれば、Databricks のライブデータへのアクセスと統合がこれまでになく簡単になります。お客様は CData の接続機能を以下の目的で利用しています:

- Runtime バージョン 9.1 - 13.X から Pro および Classic Databricks SQL バージョンまで、すべてのバージョンの Databricks にアクセスできます。

- あらゆるホスティングソリューションとの互換性により、お好みの環境で Databricks を使用し続けることができます。

- パーソナルアクセストークン、Azure サービスプリンシパル、Azure AD など、さまざまな方法で安全に認証できます。

- Databricks ファイルシステム、Azure Blob ストレージ、AWS S3 ストレージを使用して Databricks にデータをアップロードできます。

多くのお客様が、さまざまなシステムから Databricks データレイクハウスにデータを移行するために CData のソリューションを使用していますが、ライブ接続ソリューションを使用して、データベースと Databricks 間の接続をフェデレートしているお客様も多数います。これらのお客様は、SQL Server リンクサーバーまたは Polybase を使用して、既存の RDBMS 内から Databricks へのライブアクセスを実現しています。

一般的な Databricks のユースケースと CData のソリューションがデータの問題解決にどのように役立つかについては、ブログをご覧ください:What is Databricks Used For? 6 Use Cases

はじめに

ドライバーのインストール

ドライバーをインストールするには、インストールフォルダにあるドライバー JAR(cdata.jdbc.databricks.jar)と .lic ファイル(cdata.jdbc.databricks.lic)を、ODI の適切なディレクトリにコピーします。

- UNIX/Linux(エージェントなし): ~/.odi/oracledi/userlib

- UNIX/Linux(エージェントあり): ~/.odi/oracledi/userlib および $ODI_HOME/odi/agent/lib

- Windows(エージェントなし): %APPDATA%\Roaming\odi\oracledi\userlib

- Windows(エージェントあり): %APPDATA%\odi\oracledi\userlib および %APPDATA%\odi\agent\lib

ODI を再起動してインストールを完了します。

モデルのリバースエンジニアリング

モデルをリバースエンジニアリングすると、ドライバーのDatabricks のデータに対するリレーショナルビューのメタデータが取得されます。リバースエンジニアリング後は、リアルタイムのDatabricks のデータをクエリし、Databricks テーブルに基づいてマッピングを作成できます。

-

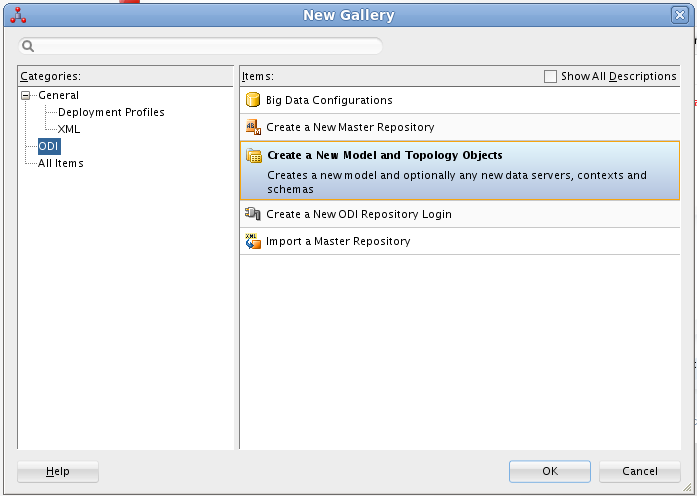

ODI でリポジトリに接続し、New -> Model and Topology Objects をクリックします。

- 表示されるダイアログの Model 画面で、以下の情報を入力します。

- Name: Databricks と入力します。

- Technology: Generic SQL を選択します(ODI バージョン 12.2 以降の場合は Microsoft SQL Server を選択)。

- Logical Schema: Databricks と入力します。

- Context: Global を選択します。

- 表示されるダイアログの Data Server 画面で、以下の情報を入力します。

- Name: Databricks と入力します。

- Driver List: Oracle JDBC Driver を選択します。

- Driver: cdata.jdbc.databricks.DatabricksDriver と入力します。

- URL: 接続文字列を含む JDBC URL を入力します。

Databricks 接続プロパティの取得・設定方法

Databricks クラスターに接続するには、以下のプロパティを設定します。

- Database:Databricks データベース名。

- Server:Databricks クラスターのサーバーのホスト名。

- HTTPPath:Databricks クラスターのHTTP パス。

- Token:個人用アクセストークン。この値は、Databricks インスタンスのユーザー設定ページに移動してアクセストークンタブを選択することで取得できます。

Databricks への認証

CData は、次の認証スキームをサポートしています。

- 個人用アクセストークン

- Microsoft Entra ID(Azure AD)

- Azure サービスプリンシパル

- OAuthU2M

- OAuthM2M

個人用アクセストークン

認証するには、次を設定します。

- AuthScheme:PersonalAccessToken。

- Token:Databricks サーバーへの接続に使用するトークン。Databricks インスタンスのユーザー設定ページに移動してアクセストークンタブを選択することで取得できます。

その他の認証方法については、ヘルプドキュメント の「はじめに」セクションを参照してください。

組み込みの接続文字列デザイナー

JDBC URL の作成には、Databricks JDBC Driver に組み込まれている接続文字列デザイナーをご利用ください。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行します。

java -jar cdata.jdbc.databricks.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

一般的な接続文字列は以下のとおりです。

jdbc:databricks:Server=127.0.0.1;HTTPPath=MyHTTPPath;User=MyUser;Token=MyToken;

- Physical Schema 画面で、以下の情報を入力します。

- Name: ドロップダウンメニューから選択します。

- Database (Catalog): CData と入力します。

- Owner (Schema): Databricks でスキーマを選択した場合は選択したスキーマを入力し、それ以外の場合は Databricks と入力します。

- Database (Work Catalog): CData と入力します。

- Owner (Work Schema): Databricks でスキーマを選択した場合は選択したスキーマを入力し、それ以外の場合は Databricks と入力します。

- 開いたモデルで Reverse Engineer をクリックして、Databricks テーブルのメタデータを取得します。

Databricks のデータの編集と保存

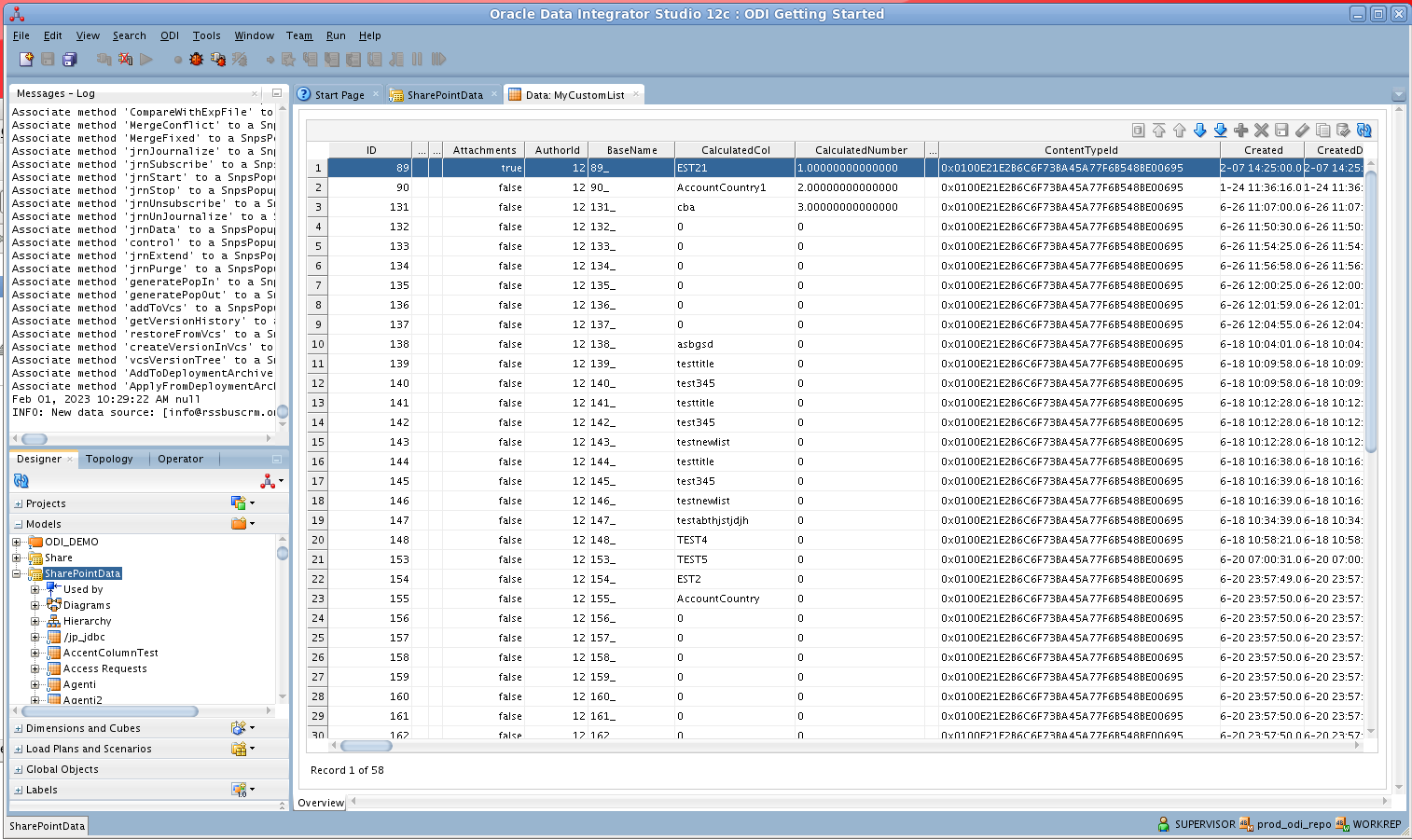

リバースエンジニアリングが完了すると、ODI でDatabricks のデータを操作できるようになります。

Databricks のデータを編集・保存するには、Designer ナビゲーターで Models アコーディオンを展開し、テーブルを右クリックして Data をクリックします。Refresh をクリックするとデータの変更を取得できます。変更が完了したら Save Changes をクリックします。

ETL プロジェクトの作成

以下の手順に従って、Databricks からの ETL を作成します。ODI Getting Started VM に含まれるサンプルデータウェアハウスに Customers エンティティをロードします。

SQL Developer を開き、Oracle データベースに接続します。Connections ペインでデータベースのノードを右クリックし、new SQL Worksheet をクリックします。

または、SQLPlus を使用することもできます。コマンドプロンプトから以下を入力します。

sqlplus / as sysdba

- 以下のクエリを入力して、ODI_DEMO スキーマにあるサンプルデータウェアハウスに新しいターゲットテーブルを作成します。以下のクエリでは、Databricks の Customers テーブルに対応するいくつかのカラムを定義しています。

CREATE TABLE ODI_DEMO.TRG_CUSTOMERS (COMPANYNAME NUMBER(20,0),City VARCHAR2(255));

- ODI で Designer ナビゲーターの Models アコーディオンを展開し、ODI_DEMO フォルダ内の Sales Administration ノードをダブルクリックします。モデルエディターでモデルが開きます。

- Reverse Engineer をクリックします。TRG_CUSTOMERS テーブルがモデルに追加されます。

- プロジェクト内の Mappings ノードを右クリックし、New Mapping をクリックします。マッピングの名前を入力し、Create Empty Dataset オプションのチェックを外します。Mapping Editor が表示されます。

- Sales Administration モデルから TRG_CUSTOMERS テーブルをマッピングにドラッグします。

- Databricks モデルから Customers テーブルをマッピングにドラッグします。

- ソースのコネクタポイントをクリックし、ターゲットのコネクタポイントにドラッグします。Attribute Matching ダイアログが表示されます。この例では、デフォルトのオプションを使用します。ターゲットカラムのプロパティにターゲット式が表示されます。

- Mapping Editor の Physical タブを開き、TARGET_GROUP 内の CUSTOMERS_AP をクリックします。

- CUSTOMERS_AP のプロパティで、Loading Knowledge Module タブの LKM SQL to SQL (Built-In) を選択します。

マッピングを実行して、Databricks のデータを Oracle にロードできます。