Google Data Fusion で Databricks に連携した ETL プロセスを作成

Google Data Fusion を使用すると、セルフサービス型のデータ連携を行い、異なるデータソースを統合できます。CData JDBC Driver for Databricks をアップロードすることで、Google Data Fusion のパイプライン内から Databricks のデータ にリアルタイムでアクセスできるようになります。CData JDBC Driver を使用すると、Databricks のデータ を Google Data Fusion でネイティブにサポートされている任意のデータソースにパイプできますが、この記事では、Databricks から Google BigQuery へデータをパイプする方法を説明します。

Databricks データ連携について

CData を使用すれば、Databricks のライブデータへのアクセスと統合がこれまでになく簡単になります。お客様は CData の接続機能を以下の目的で利用しています:

- Runtime バージョン 9.1 - 13.X から Pro および Classic Databricks SQL バージョンまで、すべてのバージョンの Databricks にアクセスできます。

- あらゆるホスティングソリューションとの互換性により、お好みの環境で Databricks を使用し続けることができます。

- パーソナルアクセストークン、Azure サービスプリンシパル、Azure AD など、さまざまな方法で安全に認証できます。

- Databricks ファイルシステム、Azure Blob ストレージ、AWS S3 ストレージを使用して Databricks にデータをアップロードできます。

多くのお客様が、さまざまなシステムから Databricks データレイクハウスにデータを移行するために CData のソリューションを使用していますが、ライブ接続ソリューションを使用して、データベースと Databricks 間の接続をフェデレートしているお客様も多数います。これらのお客様は、SQL Server リンクサーバーまたは Polybase を使用して、既存の RDBMS 内から Databricks へのライブアクセスを実現しています。

一般的な Databricks のユースケースと CData のソリューションがデータの問題解決にどのように役立つかについては、ブログをご覧ください:What is Databricks Used For? 6 Use Cases

はじめに

CData JDBC Driver for Databricks を Google Data Fusion にアップロード

CData JDBC Driver for Databricks を Google Data Fusion インスタンスにアップロードして、Databricks のデータ にリアルタイムでアクセスしましょう。Google Data Fusion では JDBC ドライバーの命名規則に制限があるため、JAR ファイルを driver-version.jar という形式に合わせてコピーまたはリネームしてください。例:cdatadatabricks-2020.jar

- Google Data Fusion インスタンスを開きます

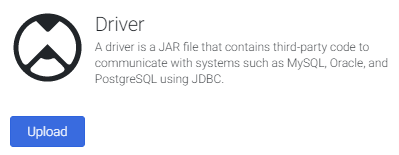

- をクリックしてエンティティを追加し、ドライバーをアップロードします

- "Upload driver" タブで、リネームした JAR ファイルをドラッグまたは参照します。

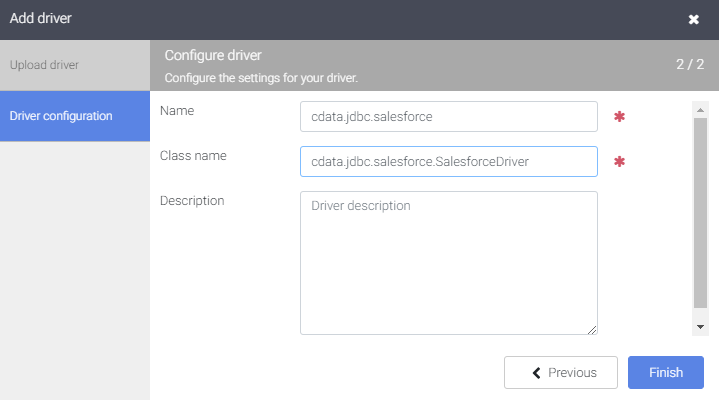

- "Driver configuration" タブで以下を設定します:

- Name: ドライバーの名前(cdata.jdbc.databricks)を作成し、メモしておきます

- Class name: JDBC クラス名を設定します:(cdata.jdbc.databricks.DatabricksDriver)

- "Finish" をクリックします

Google Data Fusion で Databricks のデータ に接続

JDBC Driver をアップロードしたら、Google Data Fusion のパイプラインで Databricks のデータ にリアルタイムでアクセスできます。

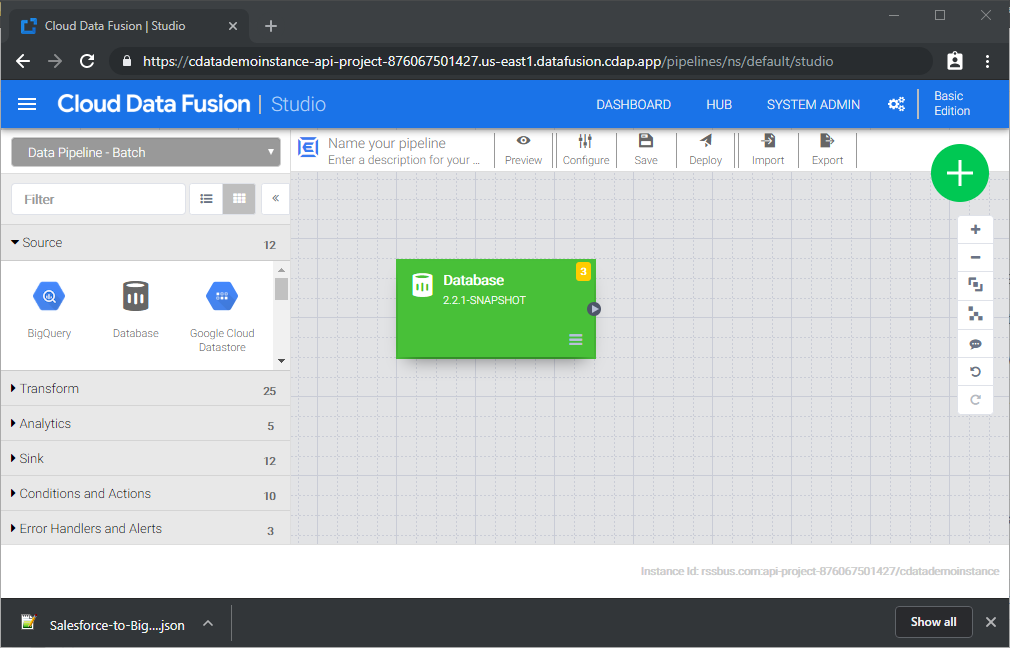

- Pipeline Studio に移動して、新しいパイプラインを作成します

- "Source" オプションから "Database" をクリックして、JDBC Driver 用のソースを追加します

- Database ソースの "Properties" をクリックしてプロパティを編集します

NOTE:Google Data Fusion で JDBC Driver を使用するには、ライセンス(製品版またはトライアル)とランタイムキー(RTK)が必要です。ライセンス(またはトライアル)の取得については、CData までお問い合わせください。

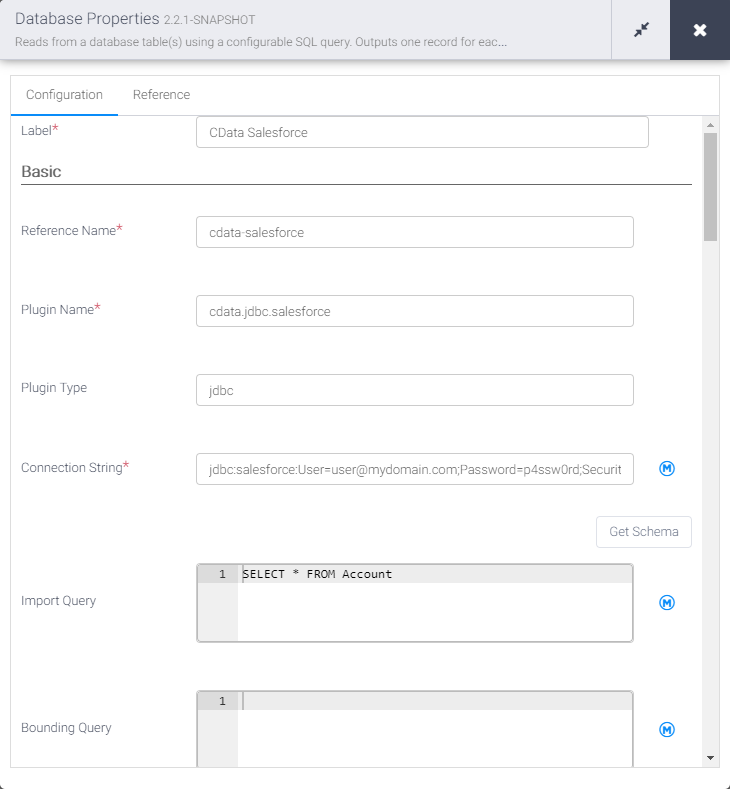

- Label を設定します

- Reference Name を将来の参照用の値に設定します(例:cdata-databricks)

- Plugin Type を "jdbc" に設定します

- Connection String を Databricks の JDBC URL に設定します。例:

jdbc:databricks:RTK=5246...;Server=127.0.0.1;HTTPPath=MyHTTPPath;User=MyUser;Token=MyToken;Databricks 接続プロパティの取得・設定方法

Databricks クラスターに接続するには、以下のプロパティを設定します。

- Database:Databricks データベース名。

- Server:Databricks クラスターのサーバーのホスト名。

- HTTPPath:Databricks クラスターのHTTP パス。

- Token:個人用アクセストークン。この値は、Databricks インスタンスのユーザー設定ページに移動してアクセストークンタブを選択することで取得できます。

Databricks への認証

CData は、次の認証スキームをサポートしています。

- 個人用アクセストークン

- Microsoft Entra ID(Azure AD)

- Azure サービスプリンシパル

- OAuthU2M

- OAuthM2M

個人用アクセストークン

認証するには、次を設定します。

- AuthScheme:PersonalAccessToken。

- Token:Databricks サーバーへの接続に使用するトークン。Databricks インスタンスのユーザー設定ページに移動してアクセストークンタブを選択することで取得できます。

その他の認証方法については、ヘルプドキュメント の「はじめに」セクションを参照してください。

ビルトイン接続文字列デザイナー

JDBC URL の作成には、Databricks JDBC Driver に組み込まれている接続文字列デザイナーを使用できます。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行してください。

java -jar cdata.jdbc.databricks.jar接続プロパティを入力し、接続文字列をクリップボードにコピーします。

- Import Query を Databricks から取得したいデータを抽出する SQL クエリに設定します。例:

SELECT * FROM Customers

- "Sink" タブから、同期先シンクを追加します(この例では Google BigQuery を使用します)

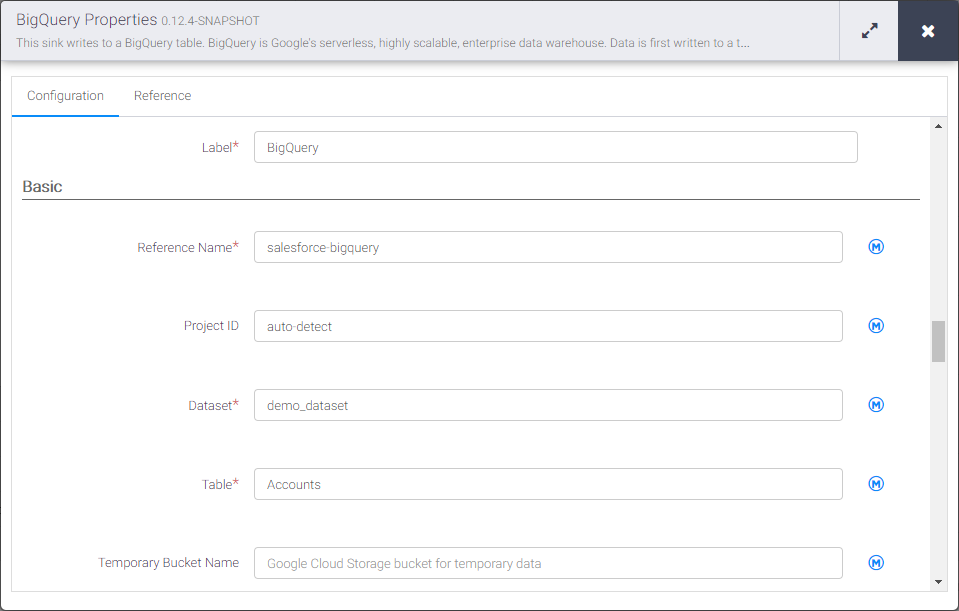

- BigQuery シンクの "Properties" をクリックしてプロパティを編集します

- Label を設定します

- Reference Name を databricks-bigquery のような値に設定します

- Project ID を特定の Google BigQuery プロジェクト ID に設定します(またはデフォルトの "auto-detect" のままにします)

- Dataset を特定の Google BigQuery データセットに設定します

- Table を Databricks のデータ を挿入するテーブル名に設定します

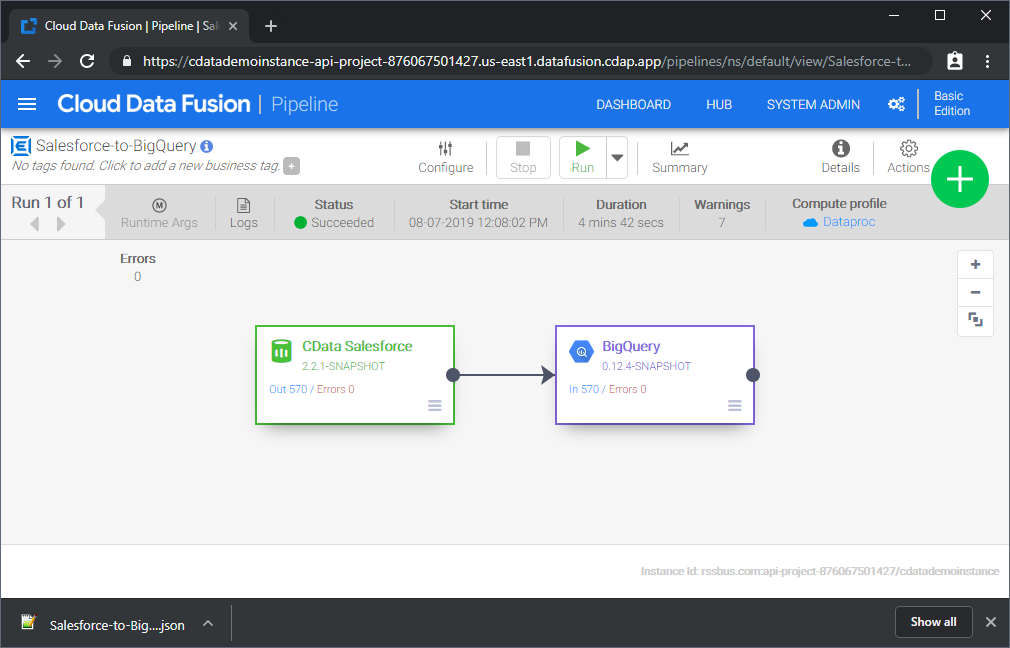

Source と Sink を設定すると、Databricks のデータ を Google BigQuery にパイプする準備が整います。パイプラインを保存してデプロイしてください。パイプラインを実行すると、Google Data Fusion が Databricks からリアルタイムデータをリクエストし、Google BigQuery にインポートします。

これはシンプルなパイプラインの例ですが、変換、分析、条件などを使用してより複雑な Databricks パイプラインを作成できます。CData JDBC Driver for Databricks の 30日間の無償トライアルをダウンロードして、今すぐ Google Data Fusion で Databricks のデータ をリアルタイムで活用しましょう。