Apache NiFi で Databricks に接続

Apache NiFi は、強力かつスケーラブルなデータルーティング、変換、システム間連携ロジックの有向グラフをサポートしています。CData JDBC Driver for Databricks と組み合わせることで、NiFi からリアルタイムのDatabricks のデータ を操作できます。この記事では、Apache NiFi Flow からDatabricks のデータ に接続してクエリを実行する方法を説明します。

CData JDBC Driver は、最適化されたデータ処理機能が組み込まれており、リアルタイムのDatabricks のデータ とのやり取りにおいて比類のないパフォーマンスを提供します。複雑なSQL クエリをDatabricks に発行すると、ドライバーはフィルタや集計などのサポートされているSQL 操作を直接Databricks にプッシュし、サポートされていない操作(多くの場合SQL 関数やJOIN 操作)は組み込みのSQL エンジンでクライアント側に処理します。また、組み込みの動的メタデータクエリにより、ネイティブのデータ型を使用してDatabricks のデータ を操作・分析できます。

Databricks データ連携について

CData を使用すれば、Databricks のライブデータへのアクセスと統合がこれまでになく簡単になります。お客様は CData の接続機能を以下の目的で利用しています:

- Runtime バージョン 9.1 - 13.X から Pro および Classic Databricks SQL バージョンまで、すべてのバージョンの Databricks にアクセスできます。

- あらゆるホスティングソリューションとの互換性により、お好みの環境で Databricks を使用し続けることができます。

- パーソナルアクセストークン、Azure サービスプリンシパル、Azure AD など、さまざまな方法で安全に認証できます。

- Databricks ファイルシステム、Azure Blob ストレージ、AWS S3 ストレージを使用して Databricks にデータをアップロードできます。

多くのお客様が、さまざまなシステムから Databricks データレイクハウスにデータを移行するために CData のソリューションを使用していますが、ライブ接続ソリューションを使用して、データベースと Databricks 間の接続をフェデレートしているお客様も多数います。これらのお客様は、SQL Server リンクサーバーまたは Polybase を使用して、既存の RDBMS 内から Databricks へのライブアクセスを実現しています。

一般的な Databricks のユースケースと CData のソリューションがデータの問題解決にどのように役立つかについては、ブログをご覧ください:What is Databricks Used For? 6 Use Cases

はじめに

Apache NiFi でDatabricks のデータ に接続

- CData JDBC Driver for Databricks のインストーラーをダウンロードし、パッケージを解凍して、.exe ファイルを実行してドライバーをインストールします。

CData JDBC Driver のJAR ファイル(およびライセンスファイルがある場合はそれも)、cdata.jdbc.databricks.jar(および cdata.jdbc.databricks.lic)を Apache NiFi の lib サブフォルダにコピーします(例:C:\nifi-1.3.0-bin\nifi-1.3.0\lib)。

Windows では、CData JDBC Driver のデフォルトのインストール場所は C:\Program Files\CData\CData JDBC Driver for Databricks です。

bin サブフォルダにある run-nifi.bat ファイルを実行して Apache NiFi を起動します(例:C:\nifi-1.3.0-bin\nifi-1.3.0\bin)。

(または)

コマンドプロンプトで対象のディレクトリに移動し、run-nifi.bat ファイルを実行します:

cd C:\nifi-1.3.0-bin\nifi-1.3.0\bin .\run-nifi.bat

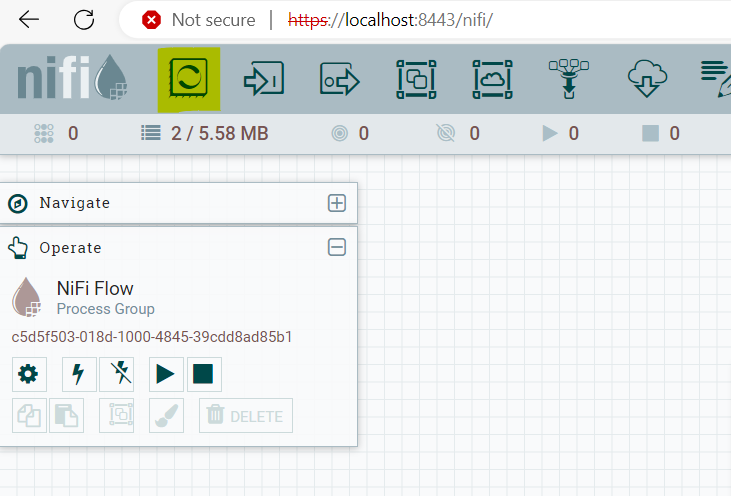

Web ブラウザで Apache NiFi の UI に移動します:https://localhost:8443/nifi でアクセスできます。

注意:古いバージョンの Apache NiFi を使用している場合は、http://localhost:8080/nifi からアクセスする必要があります。以前のバージョンでは HTTP プロトコルが使用されていましたが、最新バージョンでは HTTPS が標準になっています。デフォルトでは、HTTP はポート 8080 で動作し、HTTPS はポート 8443 を使用します。

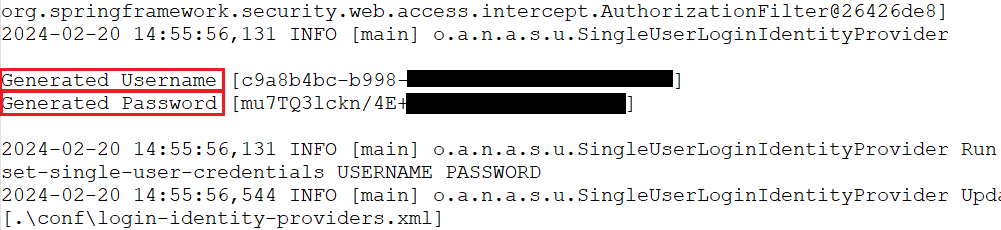

URL から Apache NiFi にアクセスすると、ログイン用のユーザー名とパスワードの入力を求められます。

ログイン資格情報を取得するには、NiFi のインストールディレクトリ内の log ディレクトリにある「App.log」ファイルを確認してください。このファイルには通常、NiFi インターフェースにアクセスするために必要な情報が含まれています。

- NiFi Flow のワークスペースを右クリックし、「Controller Services」をクリックします。

- ボタンをクリックして、新しいコントローラーサービスを作成します。

- Controller Services セクションで、新しく作成した「DBCPConnection Pool」を見つけ、メニュー()から「Edit」をクリックして新しい接続を設定します。

以下のプロパティを入力します:

- Database Connection URL:jdbc:databricks:Server=127.0.0.1;HTTPPath=MyHTTPPath;User=MyUser;Token=MyToken;

- Database Driver Class Name:cdata.jdbc.databricks.DatabricksDriver

- Database Driver Location(s):Apache NiFi の lib フォルダへのパス(JAR ファイルが配置されている場所)。

組み込みの接続文字列デザイナー

JDBC URL の構築には、Databricks JDBC Driver に組み込まれている接続文字列デザイナーを使用できます。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行してください。

java -jar cdata.jdbc.databricks.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

Databricks 接続プロパティの取得・設定方法

Databricks クラスターに接続するには、以下のプロパティを設定します。

- Database:Databricks データベース名。

- Server:Databricks クラスターのサーバーのホスト名。

- HTTPPath:Databricks クラスターのHTTP パス。

- Token:個人用アクセストークン。この値は、Databricks インスタンスのユーザー設定ページに移動してアクセストークンタブを選択することで取得できます。

Databricks への認証

CData は、次の認証スキームをサポートしています。

- 個人用アクセストークン

- Microsoft Entra ID(Azure AD)

- Azure サービスプリンシパル

- OAuthU2M

- OAuthM2M

個人用アクセストークン

認証するには、次を設定します。

- AuthScheme:PersonalAccessToken。

- Token:Databricks サーバーへの接続に使用するトークン。Databricks インスタンスのユーザー設定ページに移動してアクセストークンタブを選択することで取得できます。

その他の認証方法については、ヘルプドキュメント の「はじめに」セクションを参照してください。

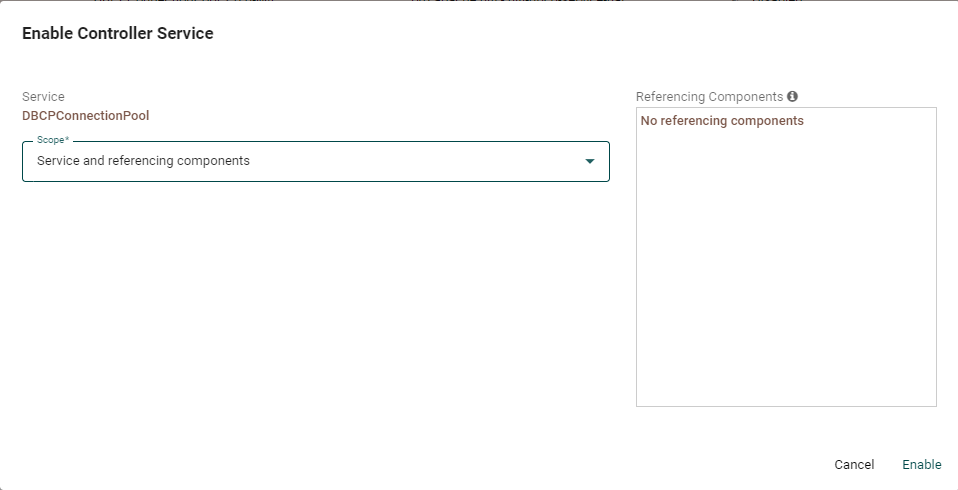

- Controller Services セクションで、新しく作成した DBCPConnection Pool を見つけ、メニュー()から「Enable」をクリックして新しい接続を有効にします。

- 「Enable Controller Service」ウィンドウで、Scope を「Service and referencing components」に設定します。

- 接続を確立し、SELECT クエリを実行するには、プロセッサー(黄色でハイライトされている部分)をワークスペースにドラッグ&ドロップします。

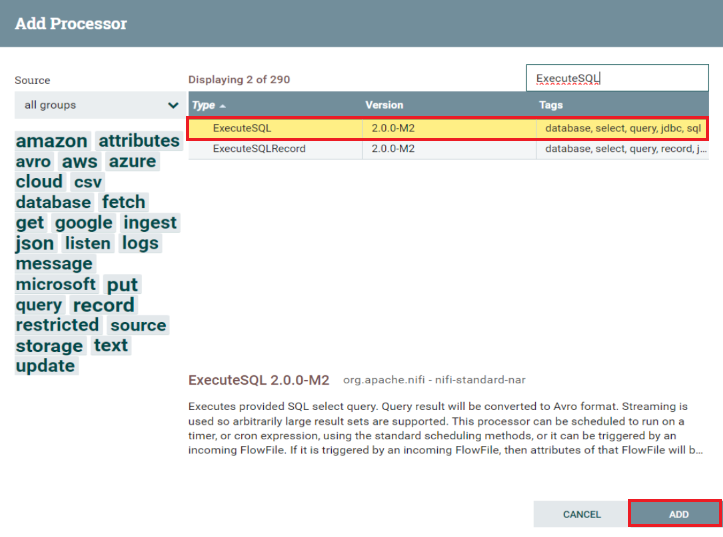

- 「ExecuteSQL」プロセッサーを選択し、「Add」ボタンをクリックしてワークスペースに表示させます。

- 追加したプロセッサー(ExecuteSQL)をダブルクリックして、接続ページを開きます。

- Properties セクションで、必要な情報を入力します。Database Connection Pooling Service を作成した DBCPConnectionPool に一致させ、SQL select query セクションに実行したい SQL クエリを設定してください。

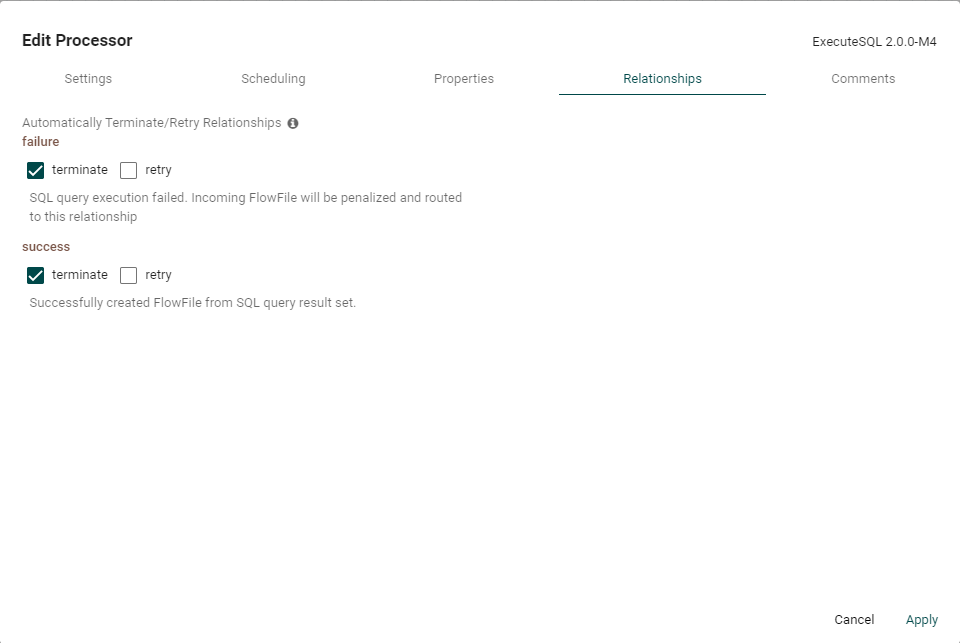

- Relationships に移動し、実行プロセスの成功時と失敗時にコンポーネントがどのように処理を進めるかのオプションを選択してください。

- ExecuteSQL コンポーネントを有効にするには、それを選択して Operation セクションの「Enable」をクリックするか、右クリックして「Enable」を選択します。

これでDatabricks のデータ が Apache NiFi で使用できるようになりました。たとえば、DBCPConnection Pool を QueryDatabaseTable プロセッサーのソースとして使用できます(以下に表示)。

30日間の無料トライアルをダウンロードして、Apache NiFi でリアルタイムのDatabricks のデータ を操作してみてください。ご不明な点は、サポートチームまでお気軽にお問い合わせください。