CData Connect AI 経由でPostgreSQL インターフェースからリアルタイムの Databricks のデータに接続

インターネット上には数多くのPostgreSQL クライアントがあります。PostgreSQL はデータアクセスのための一般的なインターフェースです。PostgreSQL をCData Connect AI と組み合わせることで、PostgreSQL からリアルタイムのDatabricks のデータにデータベースのようにアクセスできます。この記事では、Connect AI でDatabricks のデータに接続し、TDS foreign data wrapper(FDW)を使用してConnect AI とPostgreSQL 間の接続を確立するプロセスを説明します。

CData Connect AI は Databricks 専用のSQL Server インターフェースを提供し、ネイティブでサポートされているデータベースにデータをレプリケートすることなく Databricks のデータをクエリできます。最適化されたデータ処理を標準で使用し、CData Connect AI はサポートされているすべてのSQL 操作(フィルター、JOIN など)を Databricks に直接プッシュし、サーバーサイド処理を活用して必要なDatabricks のデータを迅速に返します。

Databricks データ連携について

CData を使用すれば、Databricks のライブデータへのアクセスと統合がこれまでになく簡単になります。お客様は CData の接続機能を以下の目的で利用しています:

- Runtime バージョン 9.1 - 13.X から Pro および Classic Databricks SQL バージョンまで、すべてのバージョンの Databricks にアクセスできます。

- あらゆるホスティングソリューションとの互換性により、お好みの環境で Databricks を使用し続けることができます。

- パーソナルアクセストークン、Azure サービスプリンシパル、Azure AD など、さまざまな方法で安全に認証できます。

- Databricks ファイルシステム、Azure Blob ストレージ、AWS S3 ストレージを使用して Databricks にデータをアップロードできます。

多くのお客様が、さまざまなシステムから Databricks データレイクハウスにデータを移行するために CData のソリューションを使用していますが、ライブ接続ソリューションを使用して、データベースと Databricks 間の接続をフェデレートしているお客様も多数います。これらのお客様は、SQL Server リンクサーバーまたは Polybase を使用して、既存の RDBMS 内から Databricks へのライブアクセスを実現しています。

一般的な Databricks のユースケースと CData のソリューションがデータの問題解決にどのように役立つかについては、ブログをご覧ください:What is Databricks Used For? 6 Use Cases

はじめに

Connect AI で Databricks に接続

CData Connect AI は、シンプルなポイント&クリック操作でデータソースに接続できるインターフェースを提供しています。

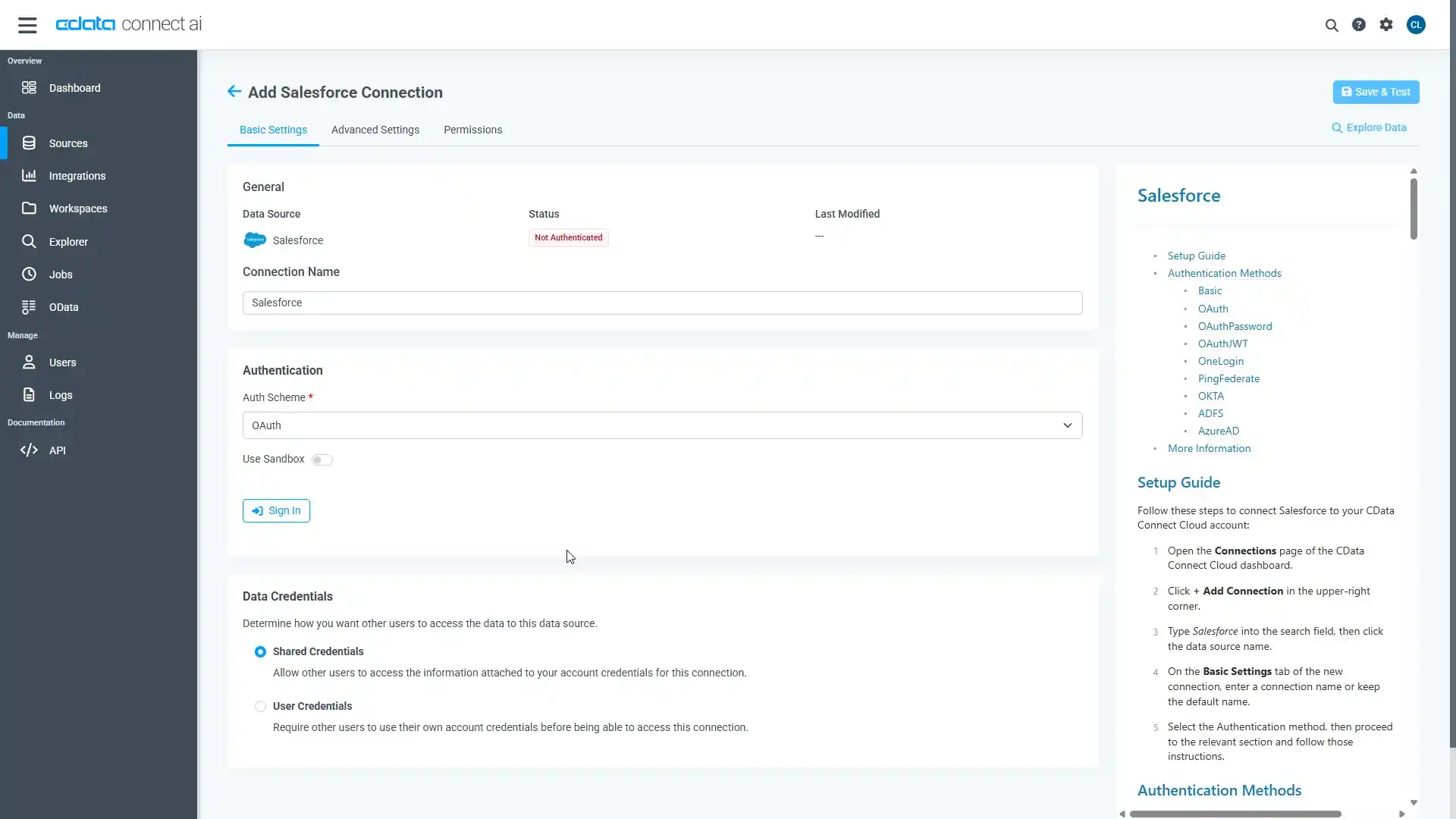

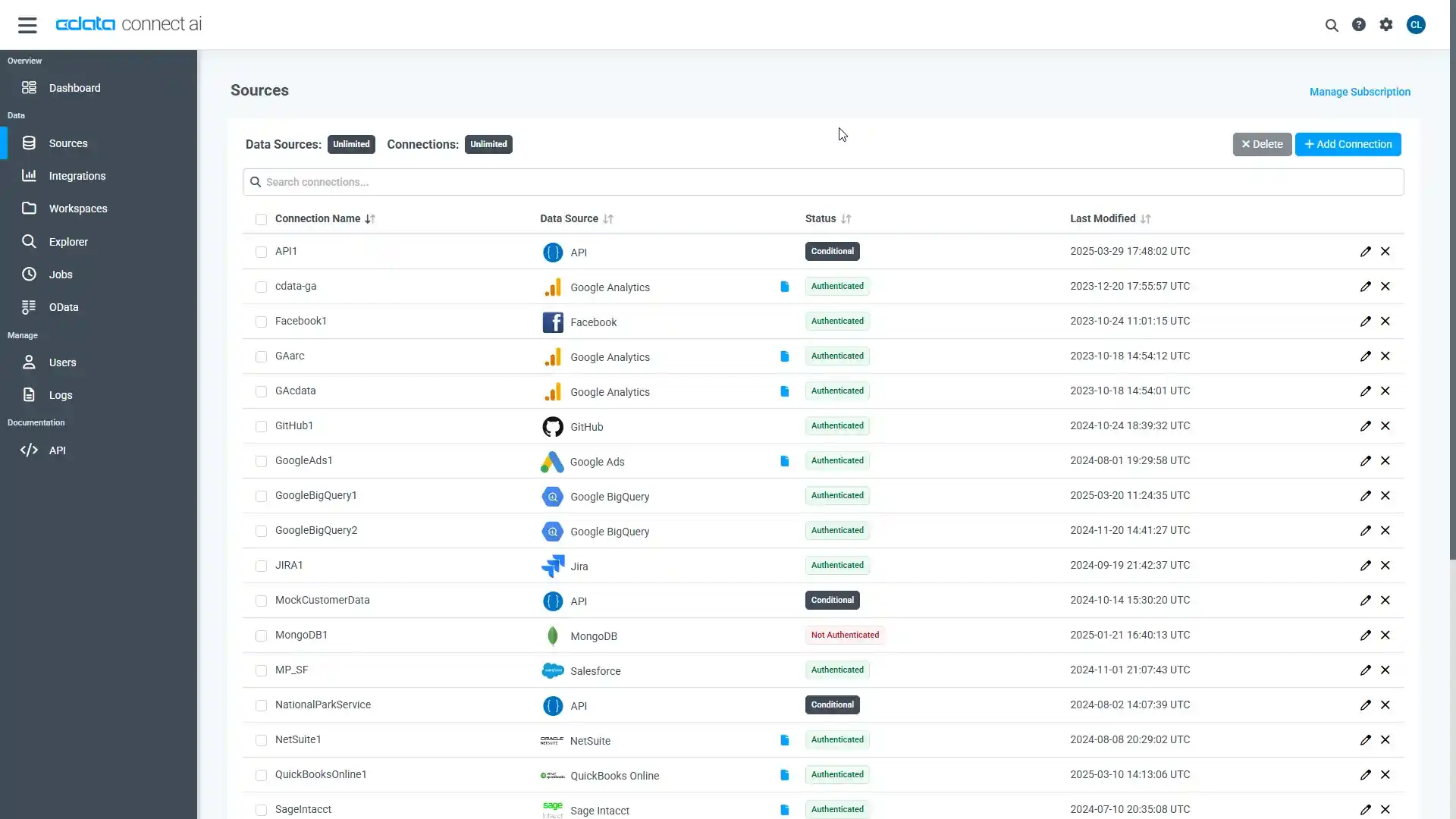

- Connect AI にログインして「Sources」をクリックし、 Add Connection をクリックします

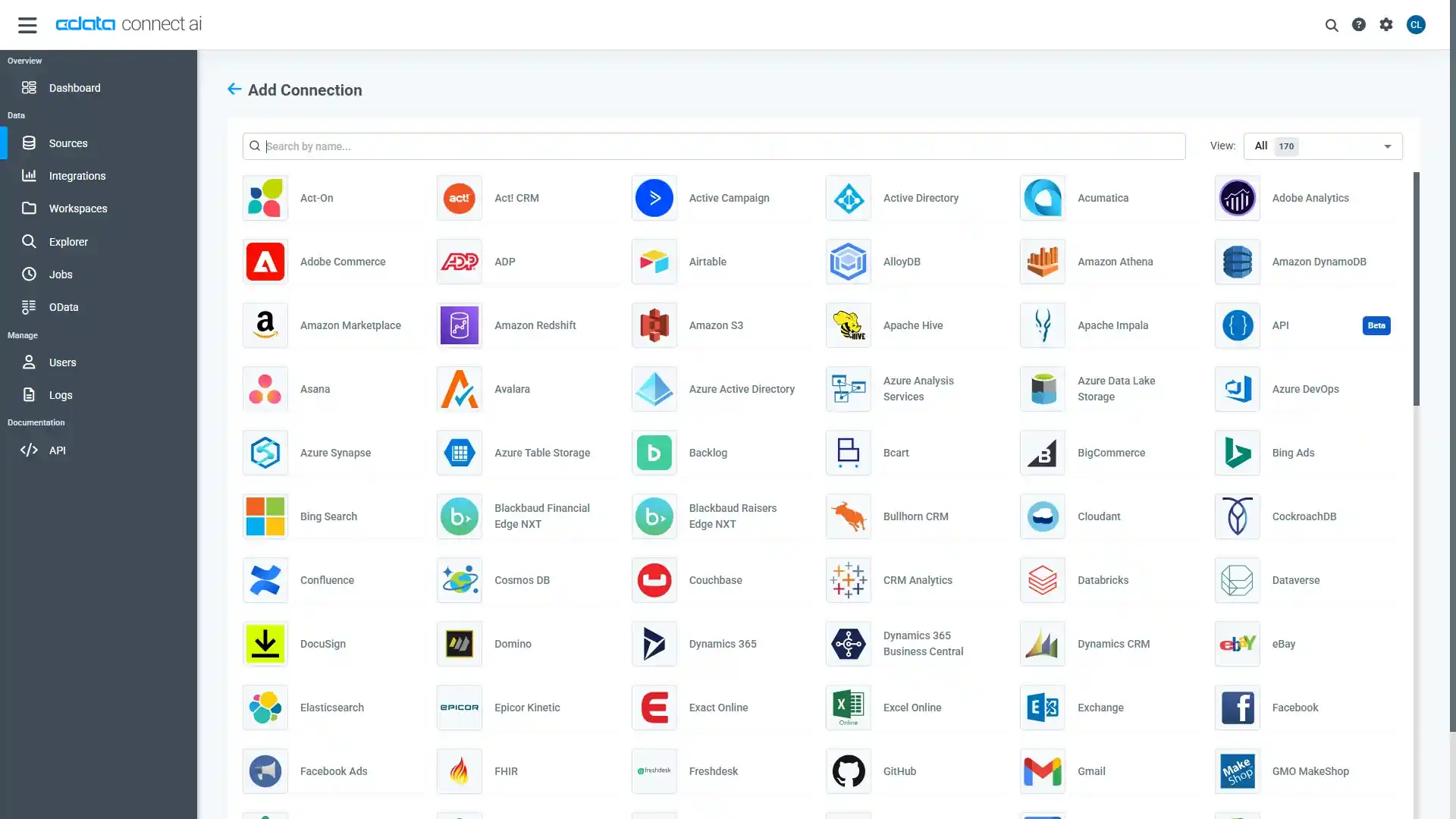

- Add Connection パネルから「Databricks」を選択します

-

Databricks への接続に必要な認証プロパティを入力します。

Databricks 接続プロパティの取得・設定方法

Databricks クラスターに接続するには、以下のプロパティを設定します。

- Database:Databricks データベース名。

- Server:Databricks クラスターのサーバーのホスト名。

- HTTPPath:Databricks クラスターのHTTP パス。

- Token:個人用アクセストークン。この値は、Databricks インスタンスのユーザー設定ページに移動してアクセストークンタブを選択することで取得できます。

Databricks への認証

CData は、次の認証スキームをサポートしています。

- 個人用アクセストークン

- Microsoft Entra ID(Azure AD)

- Azure サービスプリンシパル

- OAuthU2M

- OAuthM2M

個人用アクセストークン

認証するには、次を設定します。

- AuthScheme:PersonalAccessToken。

- Token:Databricks サーバーへの接続に使用するトークン。Databricks インスタンスのユーザー設定ページに移動してアクセストークンタブを選択することで取得できます。

その他の認証方法については、ヘルプドキュメント の「はじめに」セクションを参照してください。

- Save & Test をクリックします

-

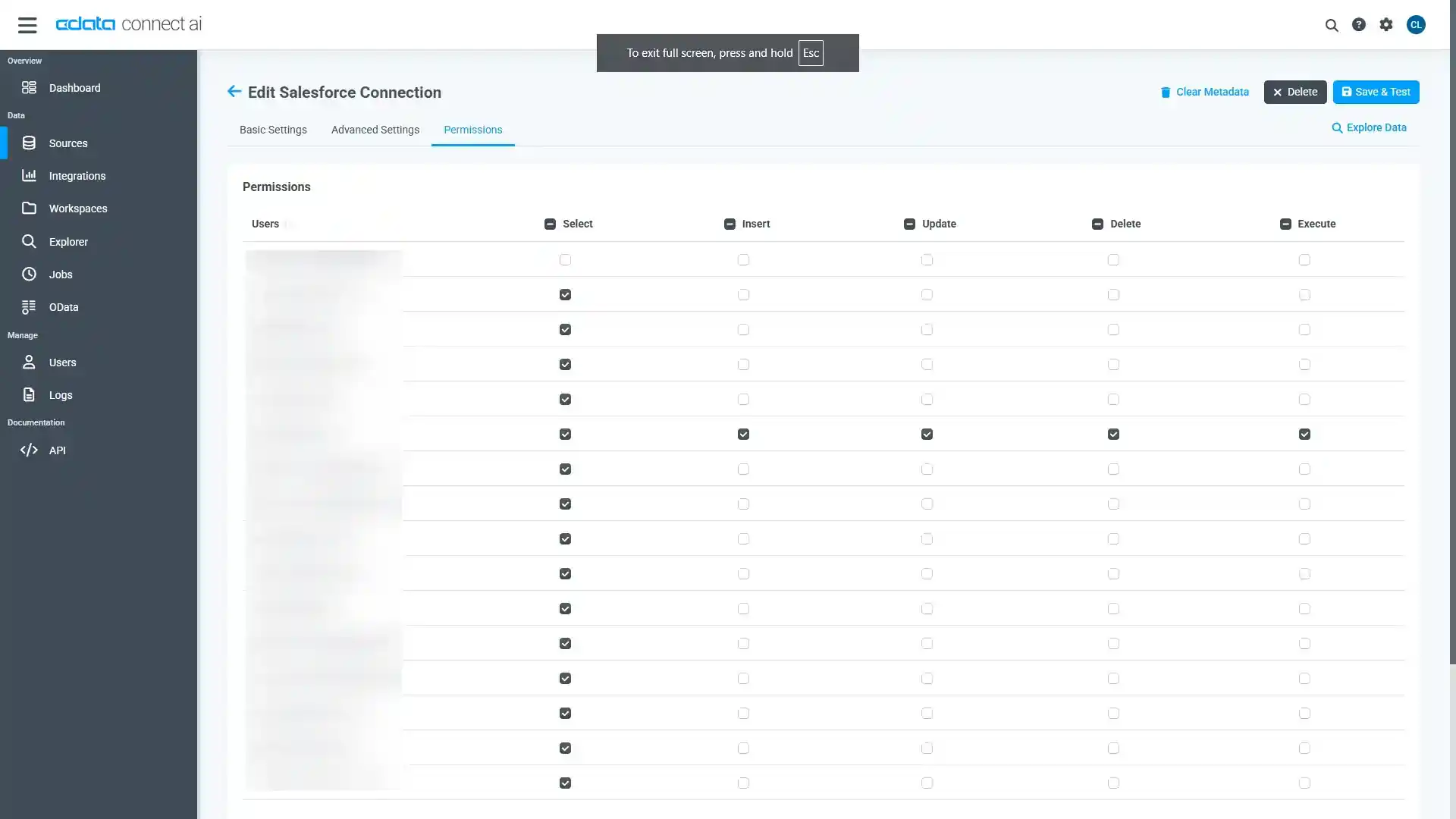

Add Databricks Connection ページの「Permissions」タブに移動し、ユーザーベースの権限を更新します。

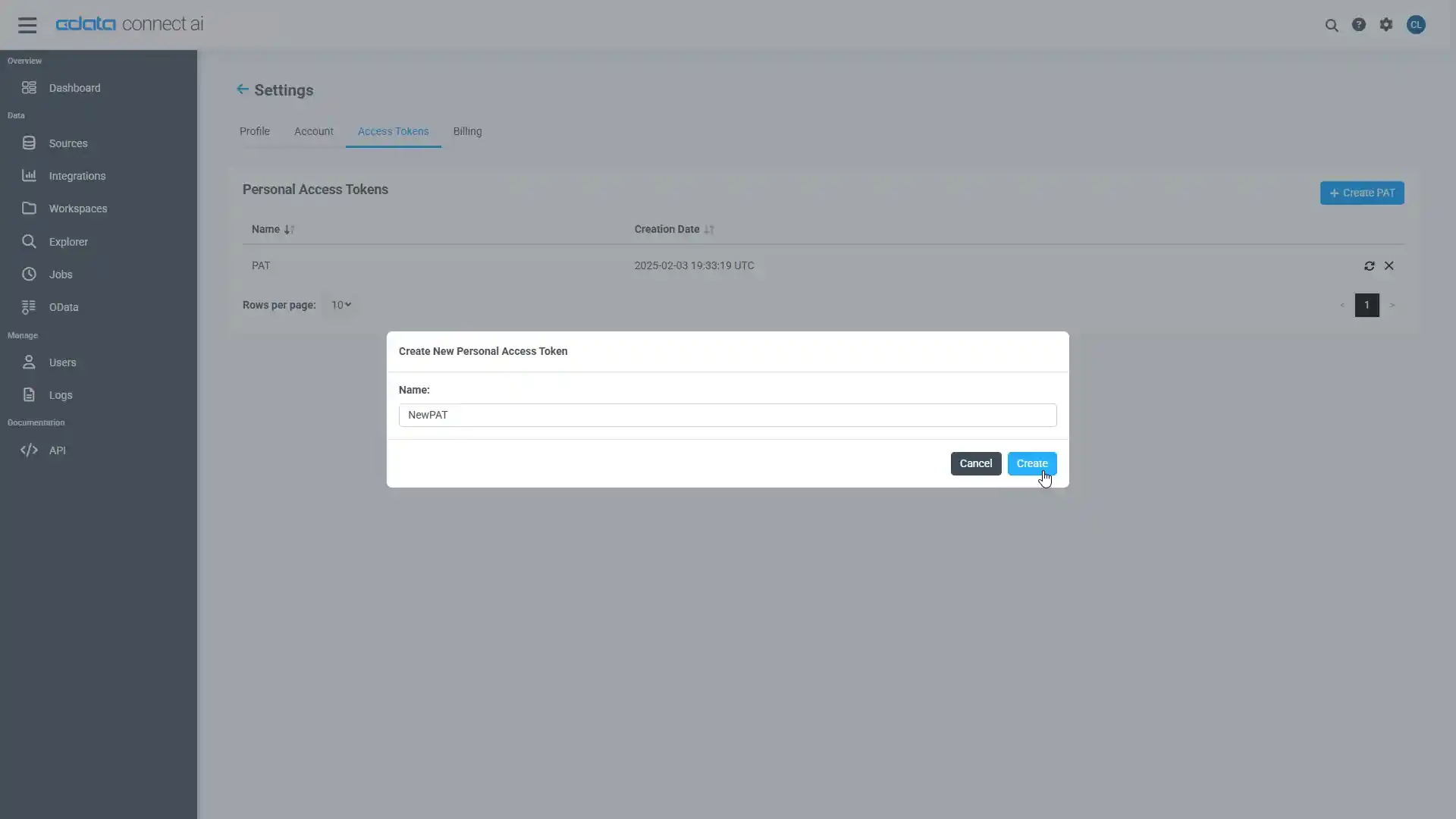

Personal Access Token の追加

REST API、OData API、またはVirtual SQL Server 経由でConnect AI に接続する場合、Personal Access Token(PAT)を使用してConnect AI への接続を認証します。アクセス管理の粒度を維持するために、サービスごとに個別のPAT を作成することをお勧めします。

- Connect AI アプリの右上にある歯車アイコン()をクリックして設定ページを開きます。

- Settings ページで「Access Tokens」セクションに移動し、 Create PAT をクリックします。

-

PAT に名前を付けて「Create」をクリックします。

- Personal Access Token は作成時にのみ表示されるため、必ずコピーして安全な場所に保存してください。

接続の設定とPAT の生成が完了したら、PostgreSQL からDatabricks のデータに接続する準備が整いました。

TDS Foreign Data Wrapper のビルド

Foreign Data Wrapper は、PostgreSQL を再コンパイルすることなく、PostgreSQL の拡張機能としてインストールできます。例として tds_fdw 拡張機能を使用します(https://github.com/tds-fdw/tds_fdw)。

- 以下のようにgit リポジトリをクローンしてビルドできます:

sudo apt-get install git git clone https://github.com/tds-fdw/tds_fdw.git cd tds_fdw make USE_PGXS=1 sudo make USE_PGXS=1 install

注意:複数のPostgreSQL バージョンがあり、デフォルト以外のバージョン用にビルドする場合は、まずpg_config のバイナリの場所を見つけてフルパスをメモし、make コマンドでUSE_PGXS=1 の後にPG_CONFIG=を追加します。 - インストールが完了したら、サーバーを起動します:

sudo service postgresql start

- 次に、Postgres データベースに入ります

psql -h localhost -U postgres -d postgres

注意:localhost の代わりにPostgreSQL がホストされているIP を指定することもできます。

PostgreSQL データベースとしてDatabricks のデータに接続し、データをクエリ!

拡張機能をインストールした後、以下の手順に従ってDatabricks のデータへのクエリを開始します:

- データベースにログインします。

- データベース用の拡張機能をロードします:

CREATE EXTENSION tds_fdw;

- Databricks のデータ 用のサーバーオブジェクトを作成します:

CREATE SERVER "Databricks1" FOREIGN DATA WRAPPER tds_fdw OPTIONS (servername'tds.cdata.com', port '14333', database 'Databricks1');

- Connect AI アカウントのメールアドレスとPersonal Access Token を使用してユーザーマッピングを設定します:

CREATE USER MAPPING for postgres SERVER "Databricks1" OPTIONS (username 'username@cdata.com', password 'your_personal_access_token' );

- ローカルスキーマを作成します:

CREATE SCHEMA "Databricks1";

- ローカルデータベースに外部テーブルを作成します:

#table_name 定義を使用: CREATE FOREIGN TABLE "Databricks1".Customers ( id varchar, CompanyName varchar) SERVER "Databricks1" OPTIONS(table_name 'Databricks.Customers', row_estimate_method 'showplan_all'); #またはschema_name とtable_name 定義を使用: CREATE FOREIGN TABLE "Databricks1".Customers ( id varchar, CompanyName varchar) SERVER "Databricks1" OPTIONS (schema_name 'Databricks', table_name 'Customers', row_estimate_method 'showplan_all'); #またはquery 定義を使用: CREATE FOREIGN TABLE "Databricks1".Customers ( id varchar, CompanyName varchar) SERVER "Databricks1" OPTIONS (query 'SELECT * FROM Databricks.Customers', row_estimate_method 'showplan_all'); #またはリモートカラム名を設定: CREATE FOREIGN TABLE "Databricks1".Customers ( id varchar, col2 varchar OPTIONS (column_name 'CompanyName')) SERVER "Databricks1" OPTIONS (schema_name 'Databricks', table_name 'Customers', row_estimate_method 'showplan_all');

- これで、Databricks に対して読み取り/書き込みコマンドを実行できます:

SELECT id, CompanyName FROM "Databricks1".Customers;

詳細情報と無償トライアル

これで、リアルタイムのDatabricks のデータからシンプルなクエリを作成できました。Databricks(およびその他200以上のデータソース)への接続の詳細については、Connect AI ページをご覧ください。無償トライアルに登録して、今すぐPostgreSQL でリアルタイムのDatabricks のデータを活用してみてください。