Apache Spark でBitbucket のデータをSQL で操作する方法

Apache Spark は大規模データ処理のための高速エンジンです。CData JDBC Driver for Bitbucket と組み合わせると、Spark はリアルタイムでBitbucket のデータに連携して処理ができます。本記事では、Spark シェルに接続してBitbucket をクエリする方法について解説します。

CData JDBC Driver は、最適化されたデータ処理がドライバーに組み込まれているため、リアルタイムBitbucket と対話するための高いパフォーマンスを提供します。Bitbucket に複雑なSQL クエリを発行すると、ドライバーはフィルタや集計など、サポートされているSQL操作を直接Bitbucket にプッシュし、組込みSQL エンジンを使用してサポートされていない操作(SQL 関数やJOIN 操作)をクライアント側で処理します。組み込みの動的メタデータクエリを使用すると、ネイティブデータ型を使用してBitbucket を操作して分析できます。

CData JDBC Driver for Bitbucket をインストール

まずは、本記事右側のサイドバーからBitbucket JDBC Driver の無償トライアルをダウンロード・インストールしてください。30日間無償で、製品版の全機能が使用できます。

Spark Shell を起動してBitbucket のデータに接続

- ターミナルを開き、Spark shell でCData JDBC Driver for Bitbucket JAR file をjars パラメータに設定します:

$ spark-shell --jars /CData/CData JDBC Driver for Bitbucket/lib/cdata.jdbc.bitbucket.jar

- Shell でJDBC URL を使ってBitbucket に接続し、SQL Context load() function でテーブルを読み込みます。

ほとんどのクエリでは、ワークスペースを設定する必要があります。唯一の例外は、Workspacesテーブルです。このテーブルはこのプロパティの設定を必要とせず、クエリを実行すると、Workspaceの設定に使用できるワークスペーススラッグのリストが提供されます。このテーブルにクエリを実行するには、スキーマを'Information'に設定し、SELECT * FROM Workspacesクエリを実行する必要があります。

Schemaを'Information'に設定すると、一般的な情報が表示されます。Bitbucketに接続するには、以下のパラメータを設定してください。

- Schema: ワークスペースのユーザー、リポジトリ、プロジェクトなどの一般的な情報を表示するには、これを'Information'に設定します。それ以外の場合は、クエリを実行するリポジトリまたはプロジェクトのスキーマに設定します。利用可能なスキーマの完全なセットを取得するには、sys_schemasテーブルにクエリを実行してください。

- Workspace: Workspacesテーブルにクエリを実行する場合を除き、必須です。Workspacesテーブルへのクエリにはこのプロパティは必要ありません。そのクエリはWorkspaceの設定に使用できるワークスペーススラッグのリストのみを返すためです。

Bitbucketでの認証

BitbucketはOAuth認証のみをサポートしています。すべてのOAuthフローからこの認証を有効にするには、カスタムOAuthアプリケーションを作成し、AuthSchemeをOAuthに設定する必要があります。

特定の認証ニーズ(デスクトップアプリケーション、Webアプリケーション、ヘッドレスマシン)に必要な接続プロパティについては、ヘルプドキュメントを必ず確認してください。

カスタムOAuthアプリケーションの作成

Bitbucketアカウントから、以下のステップを実行します。

- 設定(歯車アイコン)に移動し、ワークスペース設定を選択します。

- アプリと機能セクションで、OAuthコンシューマーを選択します。

- コンシューマーを追加をクリックします。

- カスタムアプリケーションの名前と説明を入力します。

- コールバックURLを設定します。

- デスクトップアプリケーションとヘッドレスマシンの場合、http://localhost:33333または任意のポート番号を使用します。ここで設定するURIがCallbackURLプロパティになります。

- Webアプリケーションの場合、信頼できるリダイレクトURLにコールバックURLを設定します。このURLは、ユーザーがアプリケーションにアクセスが許可されたことを確認するトークンを持って戻るWebの場所です。

- クライアント認証情報を使用して認証する予定の場合、これはプライベートコンシューマーですを選択する必要があります。ドライバーでは、AuthSchemeをclientに設定する必要があります。

- OAuthアプリケーションに与える権限を選択します。これにより、読み取りおよび書き込みできるデータが決まります。

- 新しいカスタムアプリケーションを保存するには、保存をクリックします。

- アプリケーションが保存された後、それを選択して設定を表示できます。アプリケーションのKeyとSecretが表示されます。これらを将来の使用のために記録してください。Keyを使用してOAuthClientIdを設定し、Secretを使用してOAuthClientSecretを設定します。

組み込みの接続文字列デザイナー

JDBC 接続文字列URL の作成には、Bitbucket JDBC Driver にビルトインされたデザイナを使用できます。JAR ファイルをダブルクリックするか、コマンドラインでJAR ファイルを実行するとデザイナが開きます。

java -jar cdata.jdbc.bitbucket.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

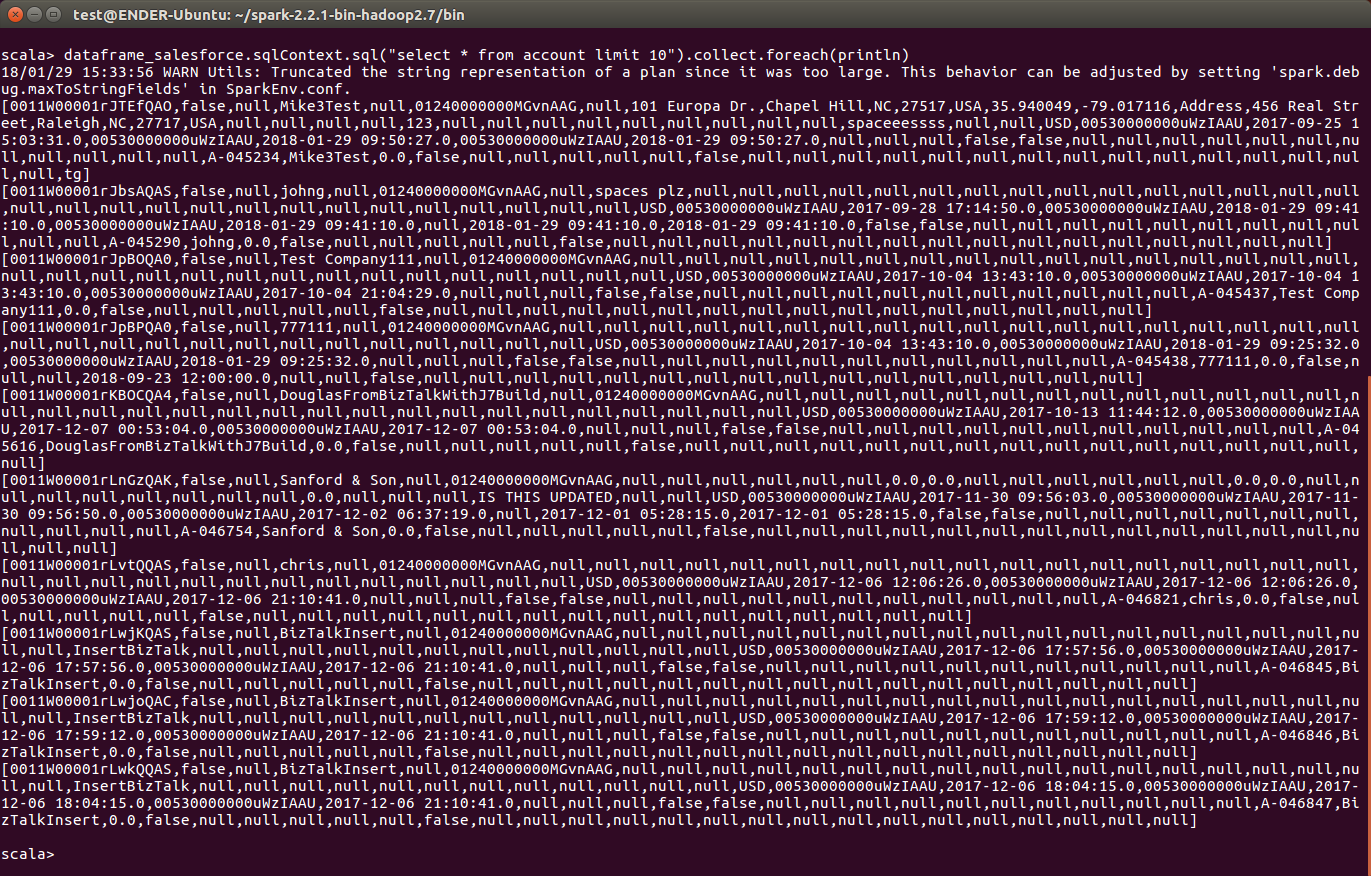

scala> val bitbucket_df = spark.sqlContext.read.format("jdbc").option("url", "jdbc:bitbucket:Workspace=myworkspaceslug;Schema=Information").option("dbtable","Issues").option("driver","cdata.jdbc.bitbucket.BitbucketDriver").load() - 接続が完了し、データがロードされたら、テーブルスキーマが表示されます。

Bitbucket をテンポラリーテーブルとして登録します:

scala> bitbucket_df.registerTable("issues")-

データに対して、次のようなカスタムSQL クエリを実行します。

scala> bitbucket_df.sqlContext.sql("SELECT Title, ContentRaw FROM Issues WHERE Id = 1").collect.foreach(println)コンソールで、次のようなBitbucket のデータを取得できました!これでBitbucket との連携は完了です。

CData JDBC Driver for Bitbucket をApache Spark で使って、Bitbucket に対して、複雑かつハイパフォーマンスなクエリを実行できます。30日の無償評価版 をダウンロードしてぜひお試しください。