Python で pandas を使って Azure Data Lake Storage データを可視化する方法

Python の豊富なエコシステムを活用することで、作業を迅速に開始し、システム間の連携をより効果的に行うことができます。CData Python Connector for Azure Data Lake Storage、pandas および Matplotlib モジュール、SQLAlchemy ツールキットを組み合わせることで、Azure Data Lake Storage に接続した Python アプリケーションやスクリプトを構築し、Azure Data Lake Storage のデータを可視化できます。この記事では、pandas、SQLAlchemy、Matplotlib の組み込み関数を使用して Azure Data Lake Storage のデータに接続し、クエリを実行して結果を可視化する方法を説明します。

CData Python Connector は、組み込みの最適化されたデータ処理機能により、Python での Azure Data Lake Storage のデータへのリアルタイムアクセスにおいて比類のないパフォーマンスを提供します。Azure Data Lake Storage に対して複雑な SQL クエリを発行すると、ドライバーはフィルタや集計などのサポートされている SQL 操作を Azure Data Lake Storage に直接プッシュし、サポートされていない操作(多くの場合、SQL 関数や JOIN 操作)は組み込みの SQL エンジンを使用してクライアント側で処理します。

Azure Data Lake Storage のデータへの接続

Azure Data Lake Storage のデータへの接続は、他のリレーショナルデータソースへの接続と同様です。必要な接続プロパティを使用して接続文字列を作成します。この記事では、接続文字列を create_engine 関数のパラメータとして渡します。

Azure Data Lake Storage 接続プロパティの取得・設定方法

Azure Data Lake Storage Gen2 への接続

それでは、Gen2 Data Lake Storage アカウントに接続していきましょう。接続するには、以下のプロパティを設定します。

- Account:ストレージアカウントの名前

- FileSystem:このアカウントに使用されるファイルシステム名。例えば、Azure Blob コンテナの名前

- Directory(オプション):レプリケートされたファイルが保存される場所へのパス。パスが指定されない場合、ファイルはルートディレクトリに保存されます

Azure Data Lake Storage Gen2への認証

続いて、認証方法を設定しましょう。CData 製品では、5つの認証方法をサポートしています:アクセスキー(AccessKey)の使用、共有アクセス署名(SAS)の使用、Azure Active Directory OAuth(AzureAD)経由、Azure サービスプリンシパル(AzureServicePrincipal またはAzureServicePrincipalCert)経由、およびManaged Service Identity(AzureMSI)経由です。

アクセスキー

アクセスキーを使用して接続するには、まずADLS Gen2ストレージアカウントで利用可能なアクセスキーを取得する必要があります。

Azure ポータルでの手順は以下のとおりです:

- ADLS Gen2ストレージアカウントにアクセスします

- 設定でアクセスキーを選択します

- 利用可能なアクセスキーの1つの値をAccessKey 接続プロパティにコピーします

接続の準備ができたら、以下のプロパティを設定してください。

- AuthScheme:AccessKey

- AccessKey:先ほどAzure ポータルで取得したアクセスキーの値

共有アクセス署名(SAS)

共有アクセス署名を使用して接続するには、まずAzure Storage Explorer ツールを使用して署名を生成する必要があります。

接続の準備ができたら、以下のプロパティを設定してください。

- AuthScheme:SAS

- SharedAccessSignature:先ほど生成した共有アクセス署名の値

その他の認証方法については、 href="/kb/help/" target="_blank">ヘルプドキュメントの「Azure Data Lake Storage Gen2への認証」セクションをご確認ください。

以下の手順に従って、必要なモジュールをインストールし、Python オブジェクトを介して Azure Data Lake Storage にアクセスしてみましょう。

必要なモジュールのインストール

pip ユーティリティを使用して、pandas、Matplotlib モジュール、および SQLAlchemy ツールキットをインストールします。

pip install pandas pip install matplotlib pip install sqlalchemy

以下のようにモジュールをインポートしてください。

import pandas import matplotlib.pyplot as plt from sqlalchemy import create_engine

Python で Azure Data Lake Storage のデータを可視化する

接続文字列を使用して接続できます。create_engine 関数を使用して、Azure Data Lake Storage のデータを操作するための Engine を作成します。

engine = create_engine("adls:///?Schema=ADLSGen2&Account=myAccount&FileSystem=myFileSystem&AccessKey=myAccessKey")

Azure Data Lake Storage への SQL の実行

pandas の read_sql 関数を使用して、SQL ステートメントを実行し、結果セットを DataFrame に格納します。

df = pandas.read_sql("SELECT FullPath, Permission FROM Resources WHERE Type = 'FILE'", engine)

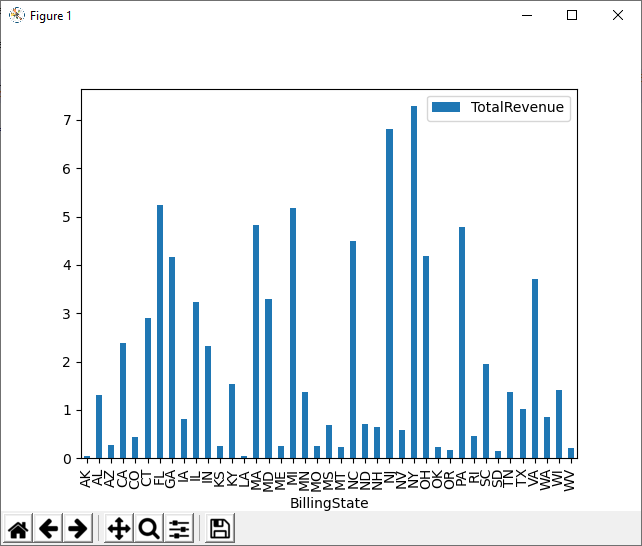

Azure Data Lake Storage のデータの可視化

クエリ結果が DataFrame に格納されたら、plot 関数を使用して Azure Data Lake Storage のデータを表示するグラフを作成します。show メソッドで、グラフを新しいウィンドウに表示します。

df.plot(kind="bar", x="FullPath", y="Permission") plt.show()

無料トライアル & 詳細情報

CData Python Connector for Azure Data Lake Storage の 30日間無料トライアルをダウンロードして、Azure Data Lake Storage のデータに接続する Python アプリケーションやスクリプトの構築を始めましょう。ご質問がありましたら、サポートチームまでお気軽にお問い合わせください。

完全なソースコード

import pandas

import matplotlib.pyplot as plt

from sqlalchemy import create_engin

engine = create_engine("adls:///?Schema=ADLSGen2&Account=myAccount&FileSystem=myFileSystem&AccessKey=myAccessKey")

df = pandas.read_sql("SELECT FullPath, Permission FROM Resources WHERE Type = 'FILE'", engine)

df.plot(kind="bar", x="FullPath", y="Permission")

plt.show()