AWS Lambda でリアルタイムAzure Data Lake Storage のデータにアクセス(IntelliJ IDEA を使用)

AWS Lambda は、新しい情報やイベントに素早く応答するアプリケーションを構築できるコンピューティングサービスです。CData JDBC Driver for Azure Data Lake Storage と組み合わせることで、AWS Lambda 関数からリアルタイムAzure Data Lake Storage のデータを操作できます。この記事では、IntelliJ で Maven を使用して AWS Lambda 関数を構築し、Azure Data Lake Storage のデータに接続してクエリを実行する方法を説明します。

最適化されたデータ処理機能を組み込んだ CData JDBC ドライバは、リアルタイムAzure Data Lake Storage のデータとのインタラクションにおいて卓越したパフォーマンスを発揮します。Azure Data Lake Storage に対して複雑な SQL クエリを発行すると、ドライバーはフィルタや集計などのサポートされている SQL 操作を直接Azure Data Lake Storageにプッシュし、サポートされていない操作(主に SQL 関数や JOIN 操作)は組み込みの SQL エンジンを使用してクライアント側で処理します。さらに、動的メタデータクエリ機能により、ネイティブのデータ型を使用してAzure Data Lake Storage のデータの操作・分析が可能です。

ステップ1:接続プロパティの設定と接続文字列の構築

CData JDBC Driver for Azure Data Lake Storage のインストーラーをダウンロードし、パッケージを解凍して JAR ファイルを実行してドライバーをインストールします。次に、必要な接続プロパティを収集します。

Azure Data Lake Storage 接続プロパティの取得・設定方法

Azure Data Lake Storage Gen2 への接続

それでは、Gen2 Data Lake Storage アカウントに接続していきましょう。接続するには、以下のプロパティを設定します。

- Account:ストレージアカウントの名前

- FileSystem:このアカウントに使用されるファイルシステム名。例えば、Azure Blob コンテナの名前

- Directory(オプション):レプリケートされたファイルが保存される場所へのパス。パスが指定されない場合、ファイルはルートディレクトリに保存されます

Azure Data Lake Storage Gen2への認証

続いて、認証方法を設定しましょう。CData 製品では、5つの認証方法をサポートしています:アクセスキー(AccessKey)の使用、共有アクセス署名(SAS)の使用、Azure Active Directory OAuth(AzureAD)経由、Azure サービスプリンシパル(AzureServicePrincipal またはAzureServicePrincipalCert)経由、およびManaged Service Identity(AzureMSI)経由です。

アクセスキー

アクセスキーを使用して接続するには、まずADLS Gen2ストレージアカウントで利用可能なアクセスキーを取得する必要があります。

Azure ポータルでの手順は以下のとおりです:

- ADLS Gen2ストレージアカウントにアクセスします

- 設定でアクセスキーを選択します

- 利用可能なアクセスキーの1つの値をAccessKey 接続プロパティにコピーします

接続の準備ができたら、以下のプロパティを設定してください。

- AuthScheme:AccessKey

- AccessKey:先ほどAzure ポータルで取得したアクセスキーの値

共有アクセス署名(SAS)

共有アクセス署名を使用して接続するには、まずAzure Storage Explorer ツールを使用して署名を生成する必要があります。

接続の準備ができたら、以下のプロパティを設定してください。

- AuthScheme:SAS

- SharedAccessSignature:先ほど生成した共有アクセス署名の値

その他の認証方法については、 href="/kb/help/" target="_blank">ヘルプドキュメントの「Azure Data Lake Storage Gen2への認証」セクションをご確認ください。

NOTE: AWS Lambda 関数で JDBC ドライバーを使用するには、ライセンス(製品版または試用版)とランタイムキー(RTK)が必要です。ライセンス(または試用版)の取得については、弊社営業チームまでお問い合わせください。

組み込みの接続文字列デザイナー

JDBC URL の構築には、Azure Data Lake Storage JDBC Driver に組み込まれている接続文字列デザイナーを使用できます。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行してください。

java -jar cdata.jdbc.adls.jar

接続プロパティ(RTK を含む)を入力し、接続文字列をクリップボードにコピーします。

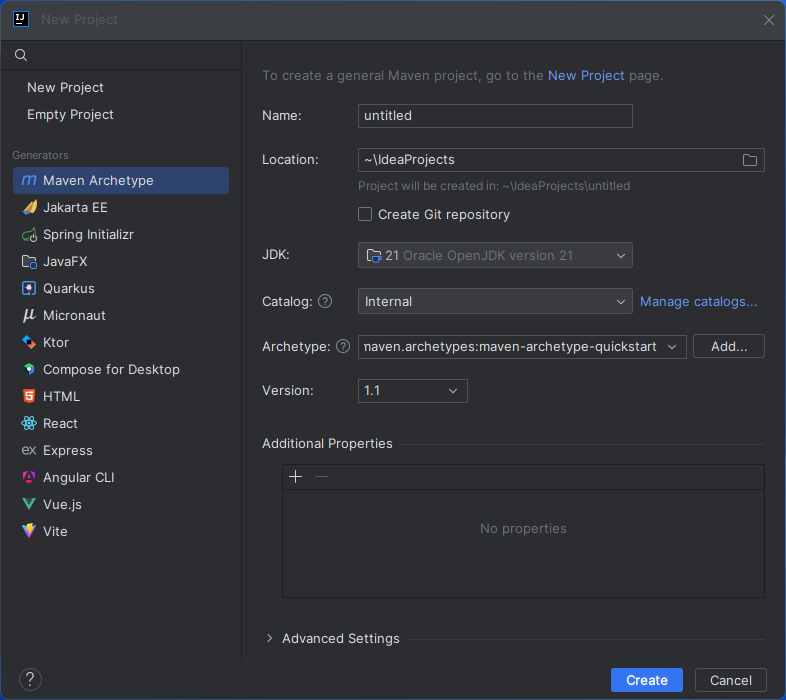

ステップ2:IntelliJ でプロジェクトを作成

- IntelliJ IDEA で「New Project」をクリックします。

- Generators から「Maven Archetype」を選択します。

- プロジェクトに名前を付け、Archetype として「maven.archetypes:maven-archetype-quickstart」を選択します。

- 「Create」をクリックします。

CData JDBC Driver for Azure Data Lake Storage JAR ファイルのインストール

プロジェクトのルートフォルダから以下の Maven コマンドを実行して、JAR ファイルをプロジェクトにインストールします。

mvn install:install-file -Dfile="PATH/TO/CData JDBC Driver for Azure Data Lake Storage 20XX/lib/cdata.jdbc.adls.jar" -DgroupId="org.cdata.connectors" -DartifactId="cdata-adls-connector" -Dversion="23" -Dpackaging=jar

依存関係の追加

Maven プロジェクトの pom.xml ファイル内で、AWS とCData JDBC Driver for Azure Data Lake Storageを依存関係として追加します(<dependencies> 要素内に以下の XML を追加)。

- AWS

<dependency> <groupId>com.amazonaws</groupId> <artifactId>aws-lambda-java-core</artifactId> <version>1.2.2</version> <!--Replace with the actual version--> </dependency>

- CData JDBC Driver for Azure Data Lake Storage

<dependency> <groupId>org.cdata.connectors</groupId> <artifactId>cdata-adls-connector</artifactId> <version>25</version> <!--Replace with the actual version--> </dependency>

- Fat JAR 作成用の Maven Shade Plugin

<build> <plugins> <plugin> <groupId>org.apache.maven.plugins</groupId> <artifactId>maven-shade-plugin</artifactId> <version>3.4.1</version> <executions> <execution> <phase>package</phase> <goals> <goal>shade</goal> </goals> <configuration> <createDependencyReducedPom>false</createDependencyReducedPom> <transformers> <transformer implementation="org.apache.maven.plugins.shade.resource.ManifestResourceTransformer"> <mainClass>com.example.CDataLambda</mainClass> <!-- Change to your actual Lambda handler class --> </transformer> </transformers> </configuration> </execution> </executions> </plugin> </plugins> </build>

AWS Lambda 関数の作成

このサンプルプロジェクトでは、CDataLambda.java と CDataLambdaTest.java の2つのソースファイルを作成します。

Lambda 関数の定義

- CDataLambda クラスを AWS Lambda SDK の RequestHandler インターフェースを実装するように更新します。handleRequest メソッドを追加する必要があります。このメソッドは、Lambda 関数がトリガーされたときに以下のタスクを実行します:

- 入力を使用して SQL クエリを構築

- OAuth 資格情報を保存するための AWS 資格情報と S3 設定を構成

- CData JDBC Driver for Azure Data Lake Storage を登録

- JDBC を使用してAzure Data Lake Storageへの接続を確立

- Azure Data Lake Storage で SQL クエリを実行

- 結果をコンソールに出力

- 出力メッセージを返す

-

以下の完全な Lambda クラスを使用してください。インポート、クラス定義、handleRequest メソッドが含まれています。DriverManager.getConnection 呼び出し内の接続文字列値は、実際の値に置き換えてください。

package com.example; import com.amazonaws.services.lambda.runtime.Context; import com.amazonaws.services.lambda.runtime.RequestHandler; import java.sql.Connection; import java.sql.DriverManager; import java.sql.ResultSet; import java.sql.ResultSetMetaData; import java.sql.SQLException; import java.sql.Statement; public class CDataLambda implements RequestHandler < Object, String > { @Override public String handleRequest(Object input, Context context) { String query = "SELECT * FROM " + input; String bucketName = "MY_AWS_BUCKET"; String oauthSettings = "s3://" + bucketName + "/oauth/OAuthSettings.txt"; String oauthConnection = "InitiateOAuth=REFRESH;" + "OAuthSettingsLocation=" + oauthSettings + ";"; try { Class.forName("cdata.jdbc.adls.ADLSDriver"); cdata.jdbc.adls.ADLSDriver driver = new cdata.jdbc.adls.ADLSDriver(); DriverManager.registerDriver(driver); } catch (SQLException ex) { // Registering the driver failed throw new RuntimeException("Failed to register JDBC driver", ex); } catch (ClassNotFoundException e) { // The driver class was not found in the classpath throw new RuntimeException("JDBC Driver class not found", e); } Connection connection = null; try { connection = DriverManager.getConnection("jdbc:cdata:adls:RTK=52465...;Schema=ADLSGen2;Account=myAccount;FileSystem=myFileSystem;AccessKey=myAccessKey;" + oauthConnection + ""); } catch (SQLException ex) { context.getLogger().log("Error getting connection: " + ex.getMessage()); } catch (Exception ex) { context.getLogger().log("Error: " + ex.getMessage()); } if (connection != null) { context.getLogger().log("Connected Successfully! "); } ResultSet resultSet = null; try { //executing query Statement stmt = connection.createStatement(); resultSet = stmt.executeQuery(query); ResultSetMetaData metaData = resultSet.getMetaData(); int numCols = metaData.getColumnCount(); //printing the results while (resultSet.next()) { for (int i = 1; i <= numCols; i++) { System.out.printf("%-25s", (resultSet.getObject(i) != null) ? resultSet.getObject(i).toString().replaceAll(" ", "") : null); } System.out.print(" "); } } catch (SQLException ex) { System.out.println("SQL Exception: " + ex.getMessage()); } catch (Exception ex) { System.out.println("General exception: " + ex.getMessage()); } return "v24 query: " + query + " complete"; } }

ステップ3:Lambda 関数のデプロイと実行

IntelliJ で関数をビルドしたら、Maven プロジェクト全体を単一の JAR ファイルとしてデプロイする準備が整います。

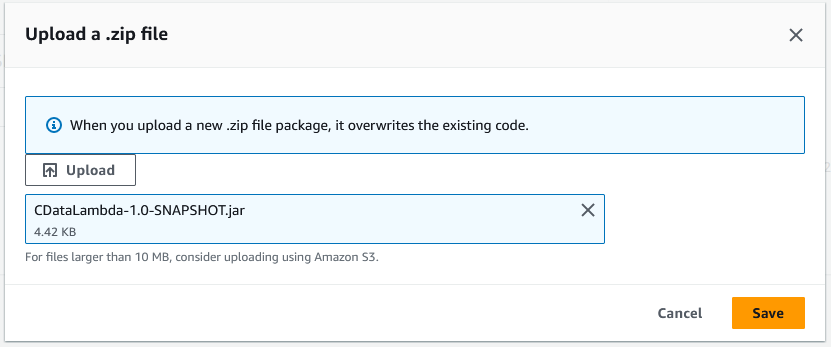

- IntelliJ で mvn install コマンドを使用して SNAPSHOT JAR ファイルをビルドします。

Note: Maven Shade Plugin は target フォルダに2つの JAR を生成します。AWS Lambda には常に、すべての必要な依存関係を含むサイズの大きい -shaded.jar ファイルをアップロードしてください。

- AWS Lambda で新しい関数を作成します(または既存の関数を開きます)。

- 関数に名前を付け、IAM ロールを選択し、タイムアウト値を関数が完了するのに十分な値に設定します(クエリの結果サイズによって異なります)。

- 「Upload from」->「.zip file」をクリックし、SNAPSHOT JAR ファイルを選択します。

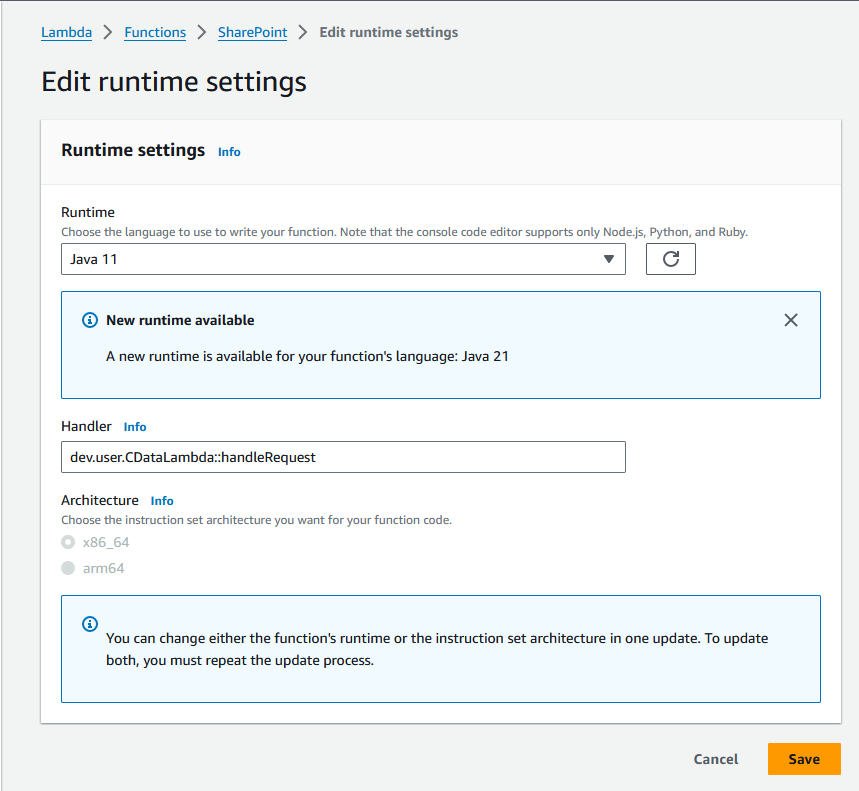

- 「Runtime settings」セクションで「Edit」をクリックし、Handler を handleRequest メソッドに設定します(例:package.class::handleRequest)。

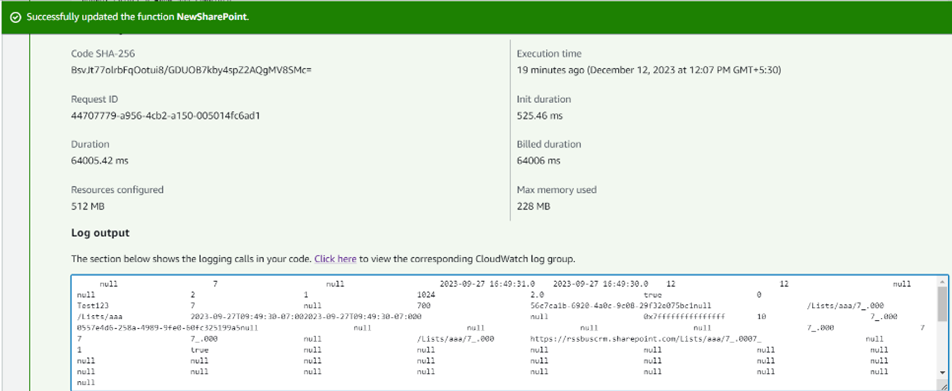

- これで関数をテストできます。「Event JSON」フィールドにテーブル名を設定し、「Test」をクリックします。

無償トライアル・詳細情報

CData JDBC Driver for Azure Data Lake Storage の30日間の無償トライアルをダウンロードして、AWS Lambda でリアルタイムAzure Data Lake Storage のデータを活用してみてください。ご不明な点があれば、サポートチームまでお気軽にお問い合わせください。