コラボフローでAzure Data Lake Storage のデータと連携したワークフローを作成

コラボフロー(www.collabo-style.co.jp/ )は誰でも簡単に作れるクラウドベースのワークフローサービスです。さらにCData Connect AI と連携することで、Azure Data Lake Storage のデータへのクラウドベースのアクセスをノーコードで追加できます。本記事では、CData Connect AI 経由でコラボフローからAzure Data Lake Storage 連携を実現する方法を紹介します。

CData Connect AI はAzure Data Lake Storage のデータへのクラウドベースのOData インターフェースを提供し、コラボフローからAzure Data Lake Storage のデータへのリアルタイム連携を実現します。

Connect AI を構成

コラボフローでAzure Data Lake Storage のデータを操作するには、Connect AI からAzure Data Lake Storage に接続し、コネクションにユーザーアクセスを提供してAzure Data Lake Storage のデータのOData エンドポイントを作成する必要があります。

Azure Data Lake Storage に接続したら、目的のテーブルのOData エンドポイントを作成します。

(オプション)新しいConnect AI ユーザーの追加

必要であれば、Connect AI 経由でAzure Data Lake Storage に接続するユーザーを作成します。

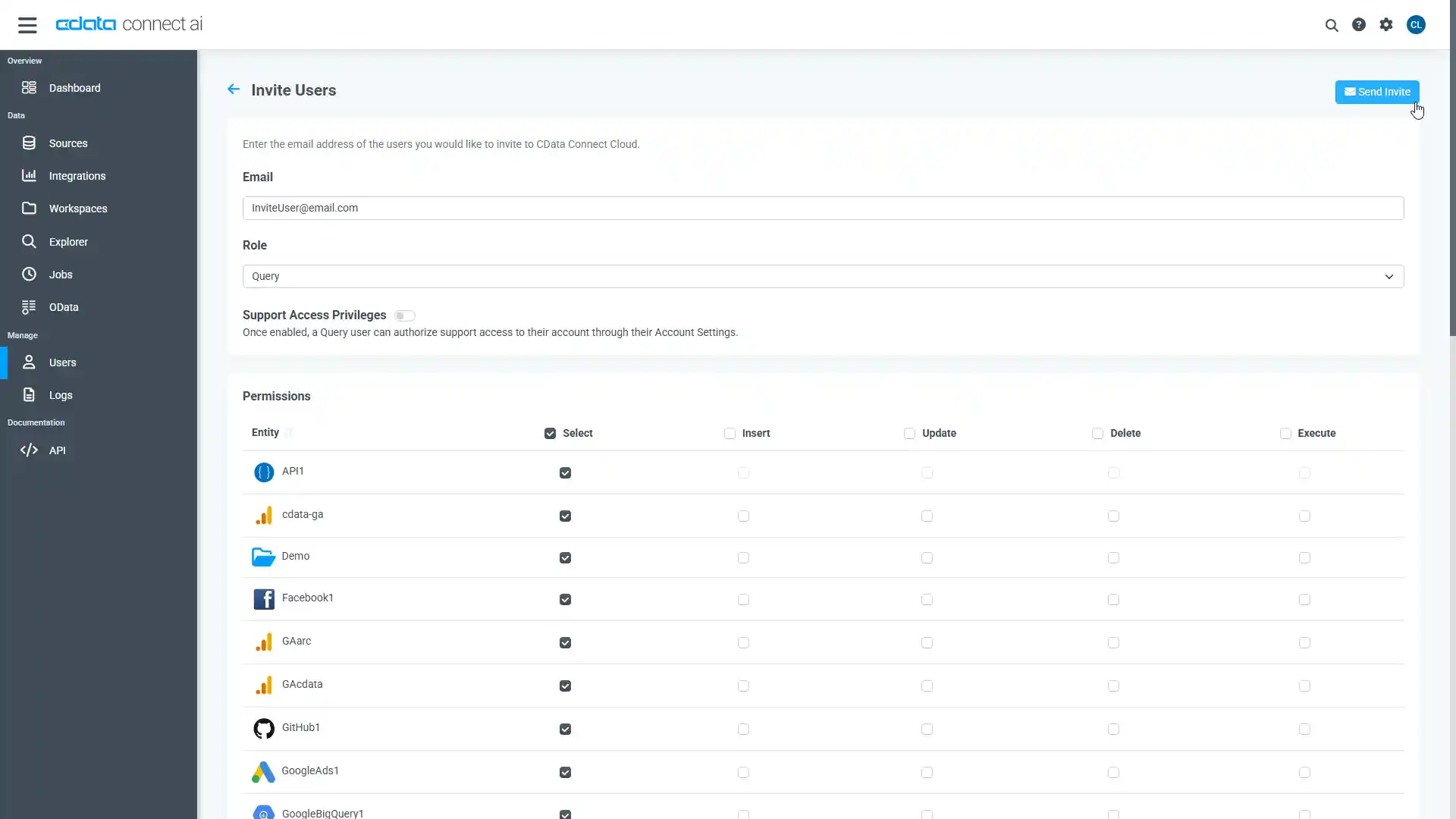

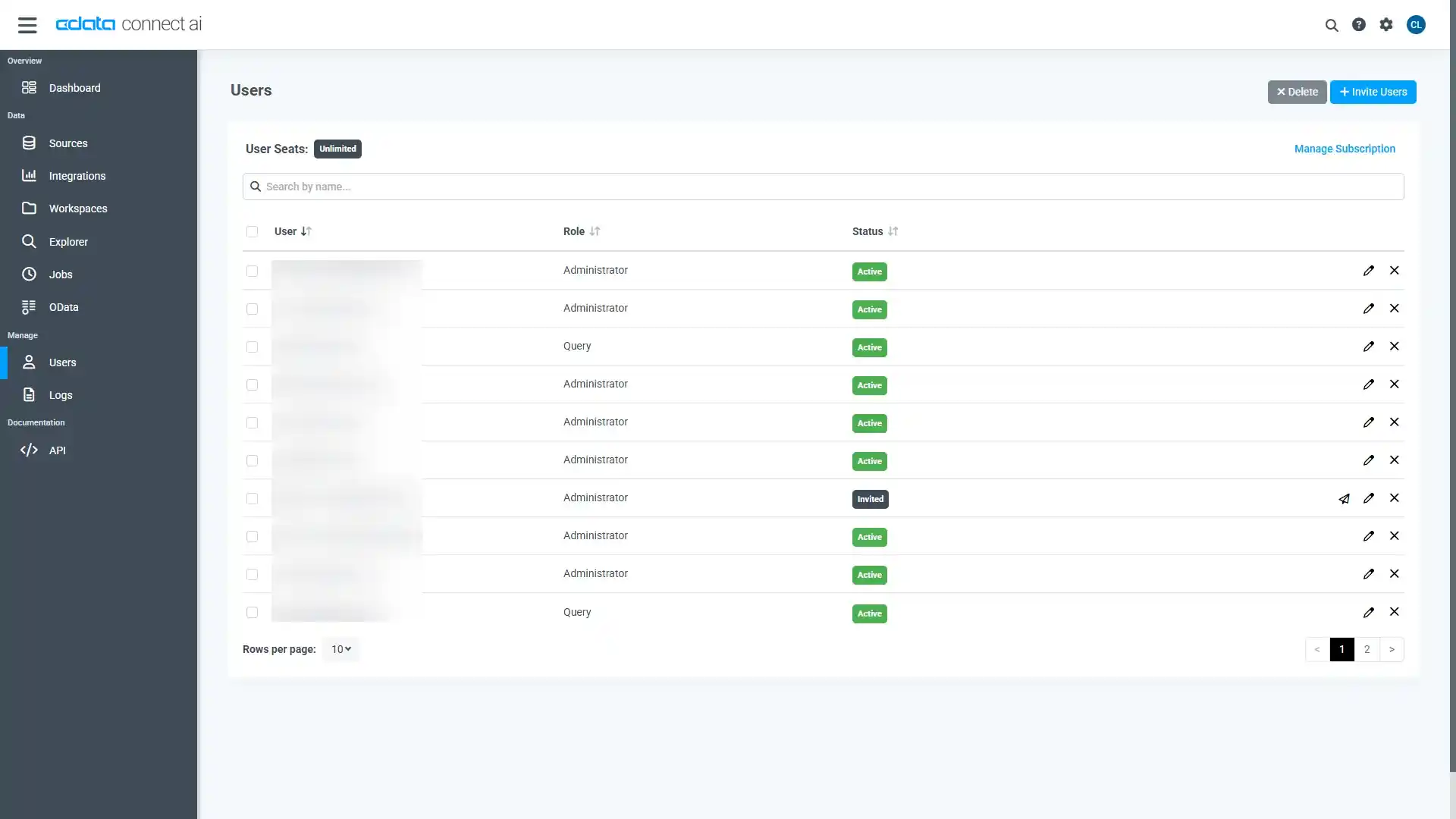

- 「Users」ページに移動し、 Invite Users をクリックします。

- 新しいユーザーのE メールアドレスを入力して、 Send をクリックしてユーザーを招待します。

- 「Users」ページからユーザーを確認および編集できます。

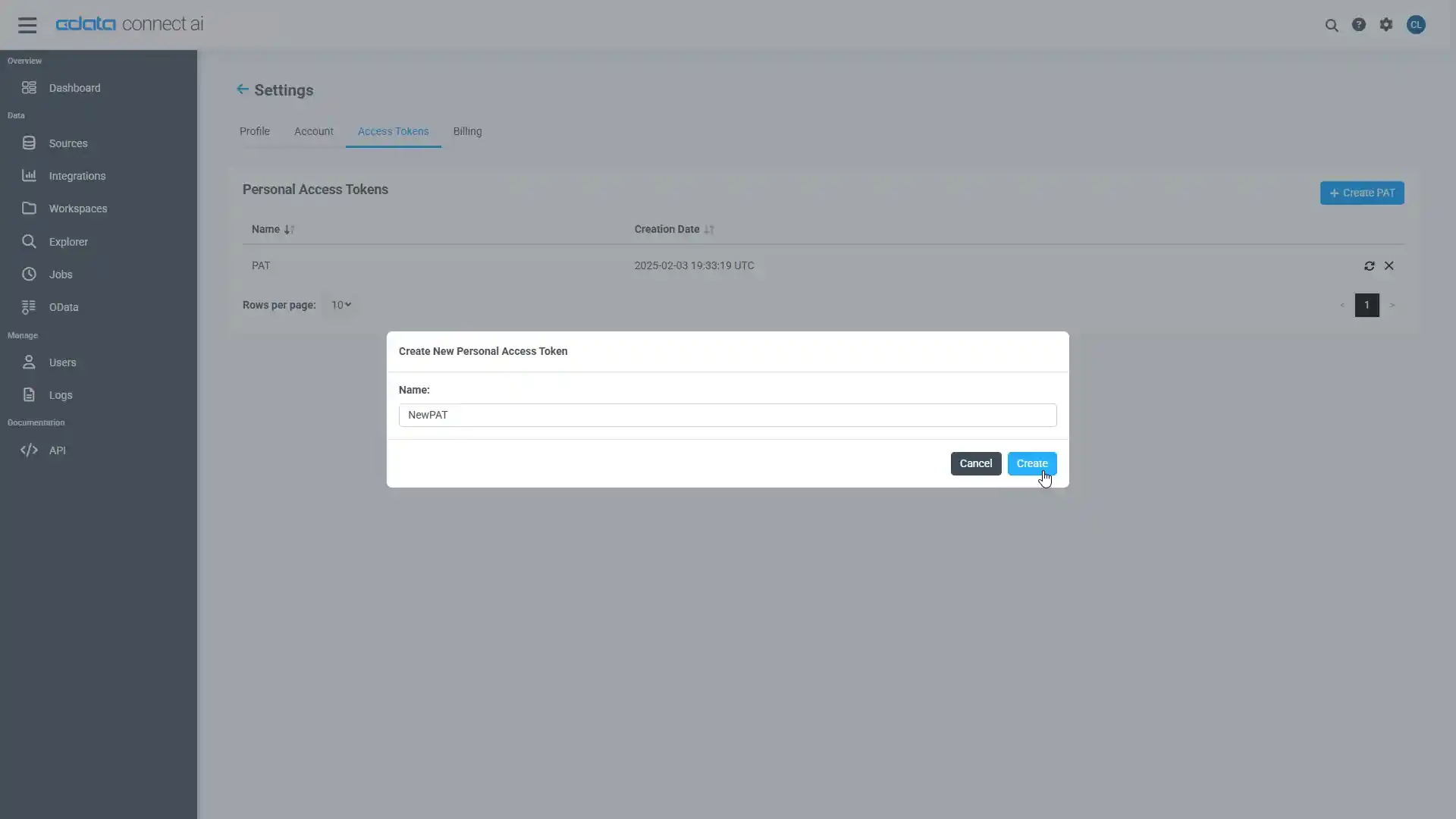

パーソナルアクセストークン(PAT)の追加

OAuth 認証をサポートしていないサービス、アプリケーション、プラットフォーム、またはフレームワークから接続する場合は、認証に使用するパーソナルアクセストークン(PAT)を作成できます。きめ細かなアクセス管理を行うために、サービスごとに個別のPAT を作成するのがベストプラクティスです。

- Connect AI アプリの右上にあるユーザー名をクリックし、「User Profile」をクリックします。

- 「User Profile」ページで「Access Token」セクションにスクロールし、 Create PAT をクリックします。

- PAT の名前を入力して Create をクリックします。

- パーソナルアクセストークン(PAT)は作成時にしか表示されないため、必ずコピーして安全に保存してください。

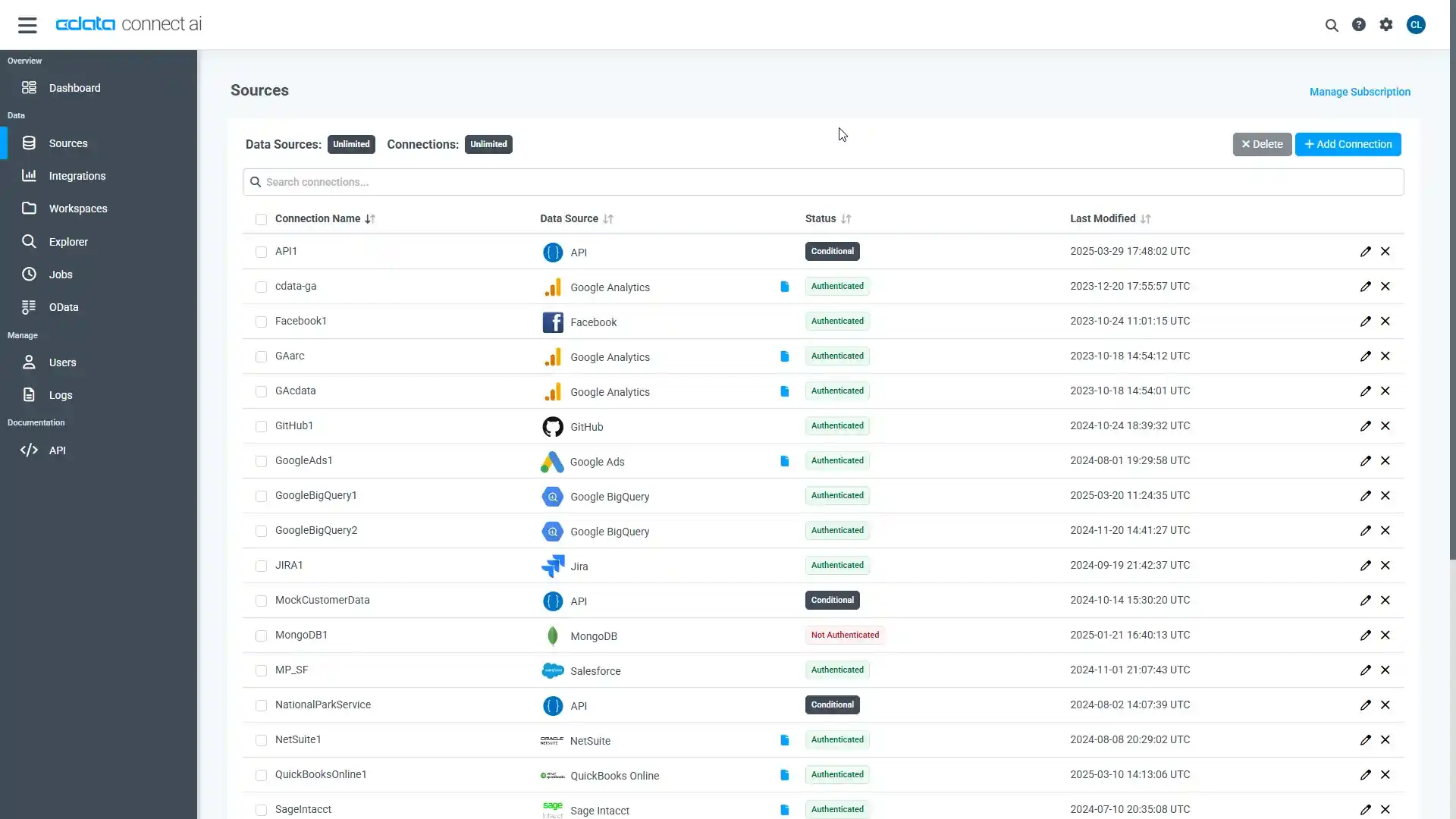

Connect AI からAzure Data Lake Storage に接続

CData Connect AI では、簡単なクリック操作ベースのインターフェースでデータソースに接続できます。

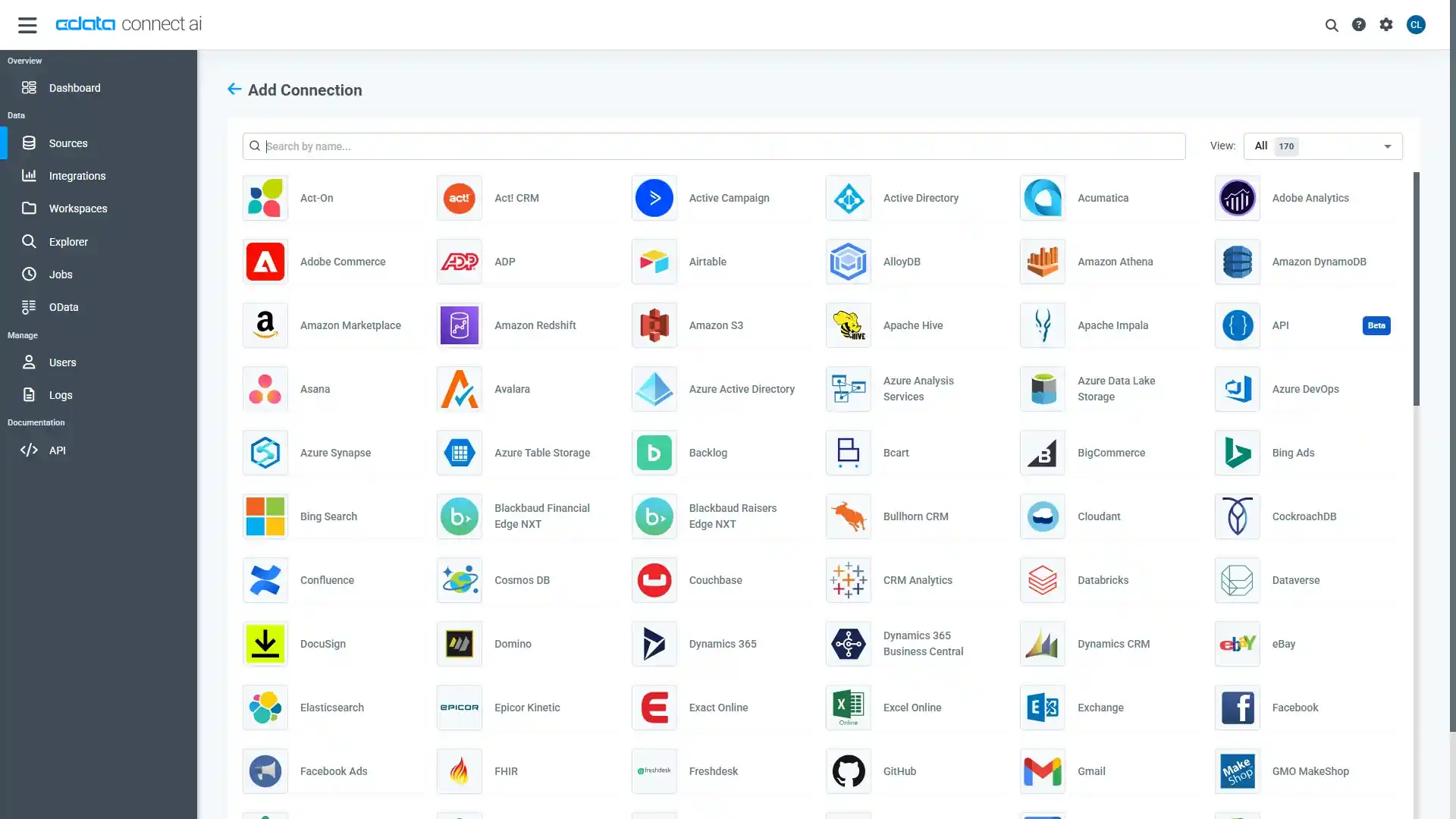

- Connect AI にログインし、 Add Connection をクリックします。

- 「Add Connection」パネルから「Azure Data Lake Storage」を選択します。

-

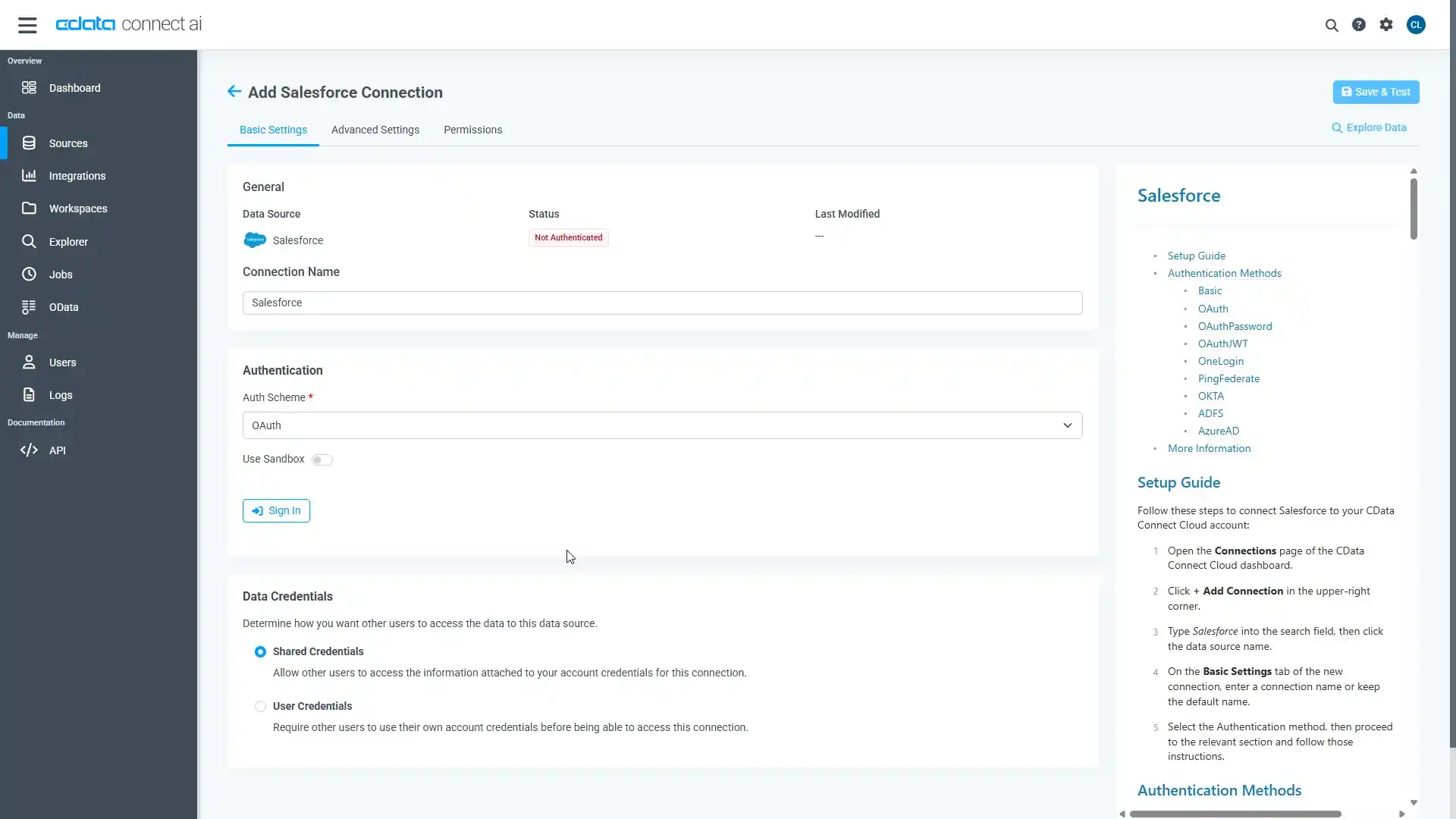

必要な認証プロパティを入力し、Azure Data Lake Storage に接続します。

Azure Data Lake Storage 接続プロパティの取得・設定方法

Azure Data Lake Storage Gen2 への接続

それでは、Gen2 Data Lake Storage アカウントに接続していきましょう。接続するには、以下のプロパティを設定します。

- Account:ストレージアカウントの名前

- FileSystem:このアカウントに使用されるファイルシステム名。例えば、Azure Blob コンテナの名前

- Directory(オプション):レプリケートされたファイルが保存される場所へのパス。パスが指定されない場合、ファイルはルートディレクトリに保存されます

Azure Data Lake Storage Gen2への認証

続いて、認証方法を設定しましょう。CData 製品では、5つの認証方法をサポートしています:アクセスキー(AccessKey)の使用、共有アクセス署名(SAS)の使用、Azure Active Directory OAuth(AzureAD)経由、Azure サービスプリンシパル(AzureServicePrincipal またはAzureServicePrincipalCert)経由、およびManaged Service Identity(AzureMSI)経由です。

アクセスキー

アクセスキーを使用して接続するには、まずADLS Gen2ストレージアカウントで利用可能なアクセスキーを取得する必要があります。

Azure ポータルでの手順は以下のとおりです:

- ADLS Gen2ストレージアカウントにアクセスします

- 設定でアクセスキーを選択します

- 利用可能なアクセスキーの1つの値をAccessKey 接続プロパティにコピーします

接続の準備ができたら、以下のプロパティを設定してください。

- AuthScheme:AccessKey

- AccessKey:先ほどAzure ポータルで取得したアクセスキーの値

共有アクセス署名(SAS)

共有アクセス署名を使用して接続するには、まずAzure Storage Explorer ツールを使用して署名を生成する必要があります。

接続の準備ができたら、以下のプロパティを設定してください。

- AuthScheme:SAS

- SharedAccessSignature:先ほど生成した共有アクセス署名の値

その他の認証方法については、 href="/kb/help/" target="_blank">ヘルプドキュメントの「Azure Data Lake Storage Gen2への認証」セクションをご確認ください。

- Create & Test をクリックします。

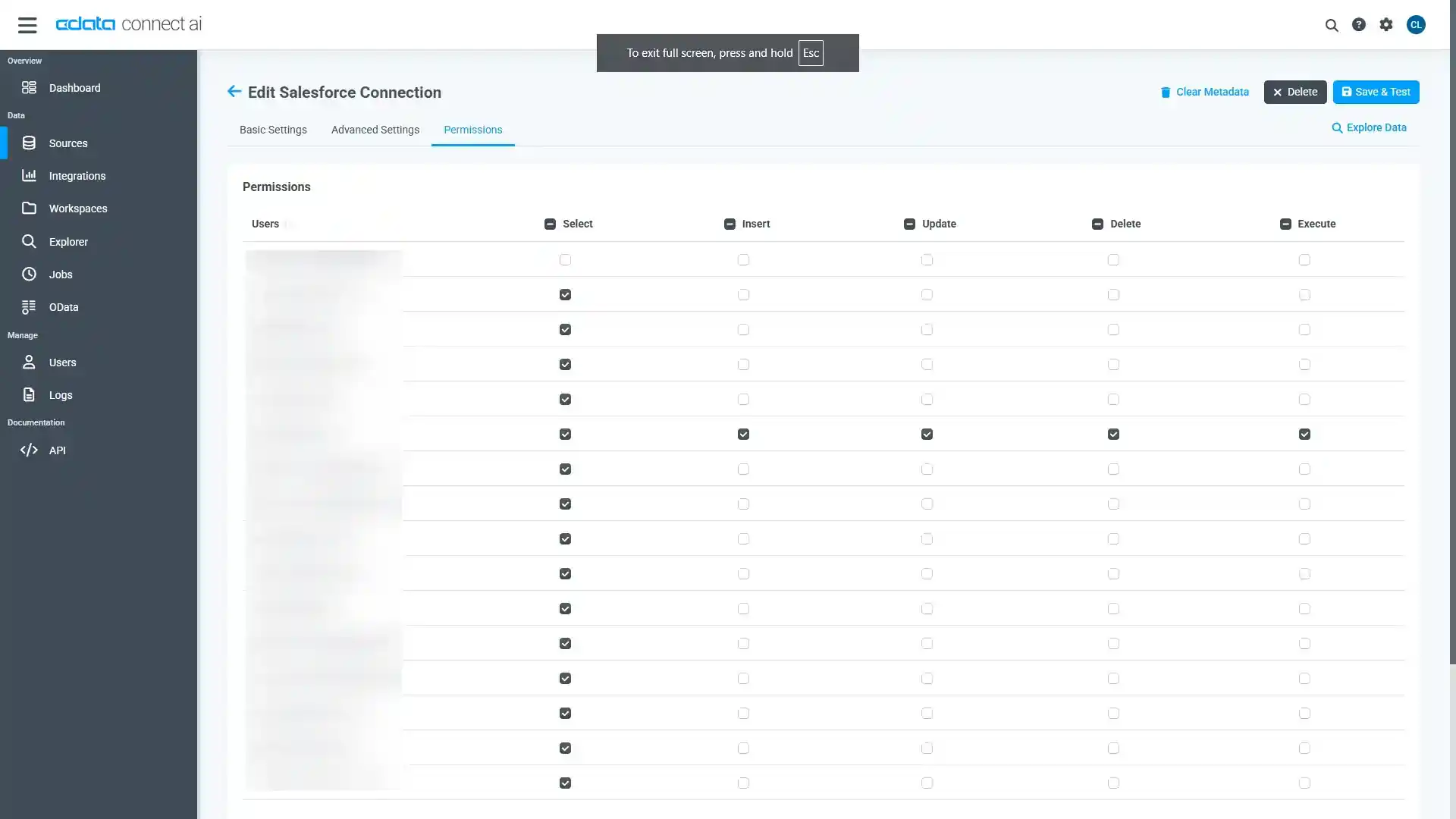

- 「Add Azure Data Lake Storage Connection」ページの「Permissions」タブに移動し、ユーザーベースのアクセス許可を更新します。

Connect AI にAzure Data Lake Storage OData エンドポイントを追加する

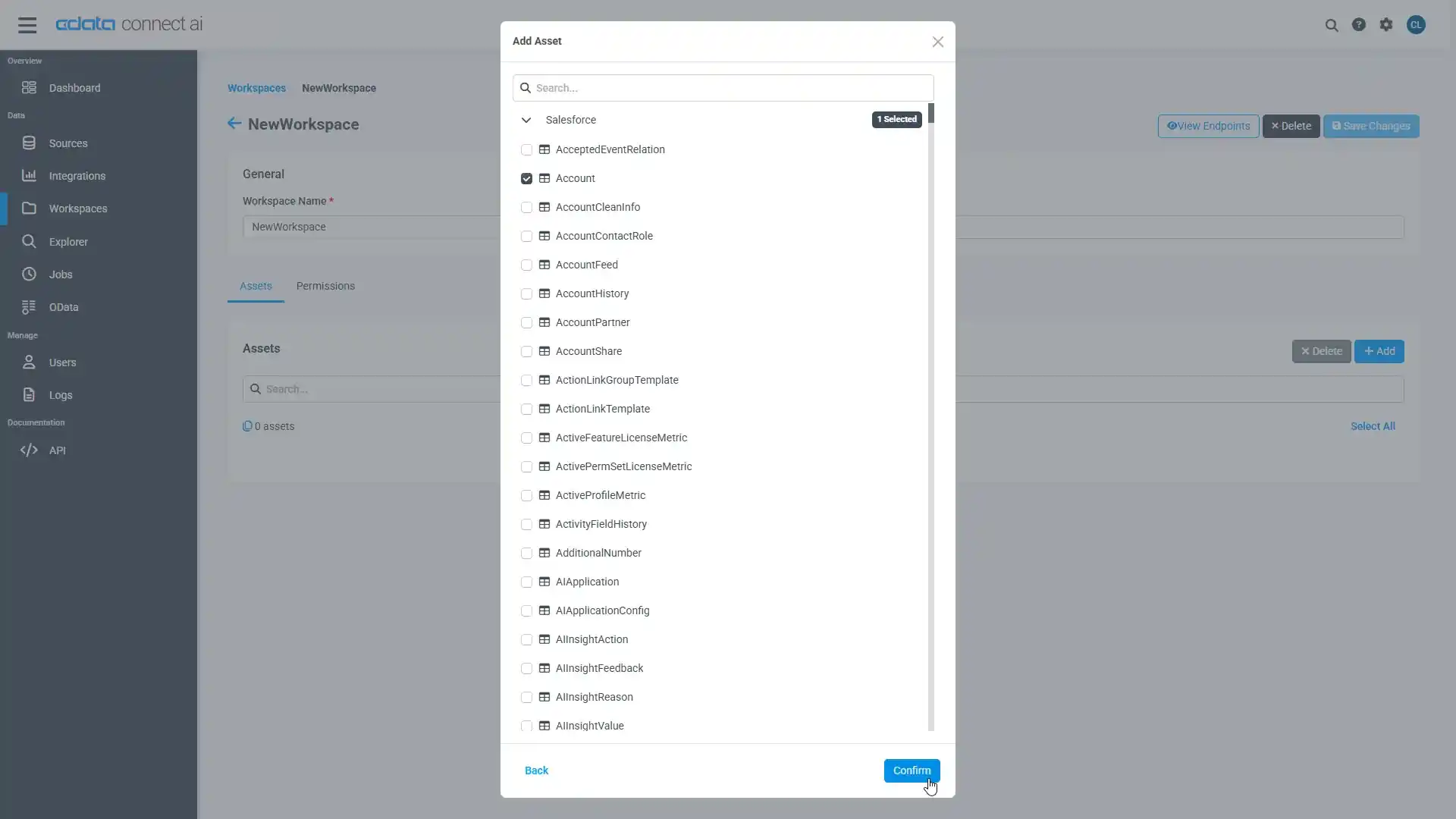

Azure Data Lake Storage に接続したら、目的のテーブルのOData エンドポイントを作成します。

- OData ページに移動し、 Add をクリックして新しいOData エンドポイントを作成します。

- Azure Data Lake Storage 接続(例:ADLS1)を選択し、Next をクリックします。

- 使用するテーブルを選択し、「Confirm」をクリックします。

コネクションとOData エンドポイントを設定したら、コラボフローからAzure Data Lake Storage のデータに接続できます。

Azure Data Lake Storage のデータに接続したワークフローを作成

コラボフローからConnect AI に連携するためのJavaScript の準備

コラボフロー上で使用するConnect AI との接続用JavaScriptを準備します。

(function () {

'use strict';

// Setting Propeties

const AutocompleteSetting =

{

// Autocomplete target field for Collaboflow

InputName: 'fid0',

// Collaboflow item detils line number

ListRowNumber : 15,

// Autocomplete tartget field for Connect AI

ApiListupFiledColumn : 'adls_column',

// Key Column Name for Connect AI resource

ApiListupKeyColumn : 'adls_keycolumn',

// Mapping between Collaboflow field and Connect AI column

Mappings: [

{

PartsName: 'fid1', // Collabo flow field name

APIName: 'adls_column1' // Connect AI column name

},

{

PartsName: 'fid2',

APIName: 'adls_column2'

},

{

PartsName: 'fid3',

APIName: 'adls_column3'

},

{

PartsName: 'fid4',

APIName: 'adls_column4'

}

]

};

const CDataConnectCloudSetting = {

// Connect AI URL

ConnectCloudUrl : 'http://XXXXXX',

// Connect AI Resource Name

ConnectCloudResourceName : 'adls_table',

// Connect AI Key

Headers : { Authorization: 'Basic YOUR_BASIC_AUTHENTICATION' },

// General Properties

ParseType : 'json',

get BaseUrl() {

return CDataCloudServerSetting.ApiServerUrl + '/api.rsc/' + CDataCloudServerSetting.ApiServerResourceName

}

}

let results = [];

let records = [];

// Set autocomplete processing for target input field

collaboflow.events.on('request.input.show', function (data) {

for (let index = 1; index < AutocompleteSetting.ListRowNumber; index++) {

$('#' + AutocompleteSetting.InputName + '_' + index).autocomplete({

source: AutocompleteDelegete,

autoFocus: true,

delay: 500,

minLength: 2

});

}

});

// This function get details from Connect AI, Then set values at each input fields based on mappings object.

collaboflow.events.on('request.input.' + AutocompleteSetting.InputName + '.change', function (eventData) {

debugger;

let tartgetParts = eventData.parts.tbl_1.value[eventData.row_index - 1];

let keyId = tartgetParts[AutocompleteSetting.InputName].value.split(':')[1\;

let record = records.find(x => x[AutocompleteSetting.ApiListupKeyColumn] == keyId);

if (!record)

return;

AutocompleteSetting.Mappings.forEach(x => tartgetParts[x.PartsName].value = '');

AutocompleteSetting.Mappings.forEach(x => tartgetParts[x.PartsName].value = record[x.APIName]);

});

function AutocompleteDelegete(req, res) {

let topParam = '&$top=10'

let queryParam = '$filter=contains(' + AutocompleteSetting.ApiListupFiledColumn + ',\'' + encodeURIComponent(req.term) + '\')';

collaboflow.proxy.get(

CDataCloudServerSetting.BaseUrl + '?' +

queryParam +

topParam,

CDataCloudServerSetting.Headers,

CDataCloudServerSetting.ParseType).then(function (response) {

results = [];

records = [];

if (response.body.value.length == 0) {

results.push('No Results')

res(results);

return;

}

records = response.body.value;

records.forEach(x => results.push(x[AutocompleteSetting.ApiListupFiledColumn] + ':' + x[AutocompleteSetting.ApiListupKeyColumn]));

res(results);

}).catch(function (error) {

alert(error);

});

}

})();

- 「CDataConnectCloudSetting」のそれぞれのプロパティには構成したSSH Server のURL とConnect AI の認証情報をそれぞれ設定してください。

- 「AutocompleteSetting」はどのフィールドでオートコンプリートを動作させるか? といった設定と、API のプロパティとのマッピングを行います。

- 今回はコラボフローのデフォルトテンプレートで提供されている「12a.見積書・注文書」で利用しますので、デフォルトでは商品名のフィールドを、Product テーブルのName と紐付けて、Autocomplete を行うように構成しています。値が決定されたら、Key となるProductID を元に「型番、標準単価、仕入単価、御提供単価」をそれぞれAPI から取得した値で自動補完するようになっています。

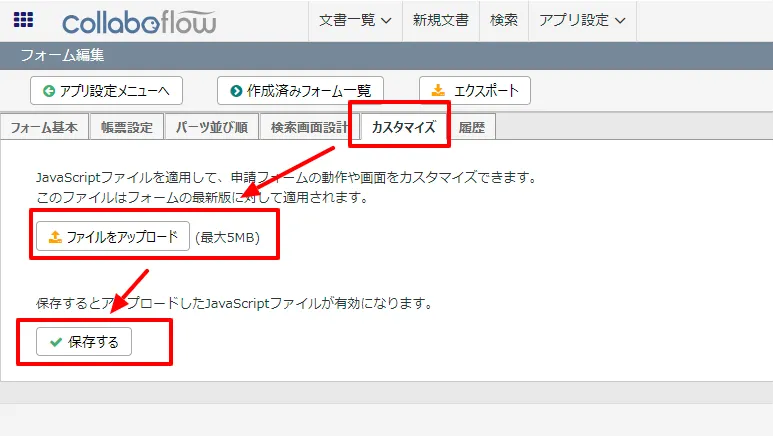

コラボフロー側でJavaScript を登録

JavaScript を作成したら、後はコラボフローにアップするだけです。

- コラボフローにログインし「アプリ設定」→「フォーム設定」に移動します。

- フォーム一覧から使用するフォームを選択します。

- フォーム編集画面に移動後、「カスタマイズ」タブをクリックし、ファイルをアップロードから作成したJSファイルをアップロードし、保存します。

- これでConnect AI 経由でAzure Data Lake Storage のデータを取得し、自動入力補完する機能がコラボフローの申請フォームに追加できました。

クラウドアプリケーションからAzure Data Lake Storage のデータへのライブ接続

コラボフローからAzure Data Lake Storage のリアルタイムデータに直接接続できるようになりました。これで、Azure Data Lake Storage のデータを複製せずにより多くの接続とアプリを作成できます。

クラウドアプリケーションから直接100を超えるSaaS 、ビッグデータ、NoSQL ソースへのリアルタイムデータアクセスを取得するには、CData Connect AI を参照してください。