Google Data Fusion で Amazon S3 に連携した ETL プロセスを作成

Google Data Fusion を使用すると、セルフサービス型のデータ連携を行い、異なるデータソースを統合できます。CData JDBC Driver for Amazon S3 をアップロードすることで、Google Data Fusion のパイプライン内から Amazon S3 のデータ にリアルタイムでアクセスできるようになります。CData JDBC Driver を使用すると、Amazon S3 のデータ を Google Data Fusion でネイティブにサポートされている任意のデータソースにパイプできますが、この記事では、Amazon S3 から Google BigQuery へデータをパイプする方法を説明します。

CData JDBC Driver for Amazon S3 を Google Data Fusion にアップロード

CData JDBC Driver for Amazon S3 を Google Data Fusion インスタンスにアップロードして、Amazon S3 のデータ にリアルタイムでアクセスしましょう。Google Data Fusion では JDBC ドライバーの命名規則に制限があるため、JAR ファイルを driver-version.jar という形式に合わせてコピーまたはリネームしてください。例:cdataamazons3-2020.jar

- Google Data Fusion インスタンスを開きます

- をクリックしてエンティティを追加し、ドライバーをアップロードします

- "Upload driver" タブで、リネームした JAR ファイルをドラッグまたは参照します。

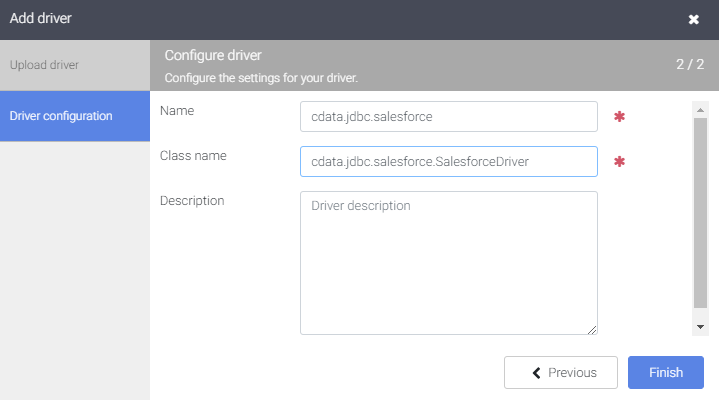

- "Driver configuration" タブで以下を設定します:

- Name: ドライバーの名前(cdata.jdbc.amazons3)を作成し、メモしておきます

- Class name: JDBC クラス名を設定します:(cdata.jdbc.amazons3.AmazonS3Driver)

- "Finish" をクリックします

Google Data Fusion で Amazon S3 のデータ に接続

JDBC Driver をアップロードしたら、Google Data Fusion のパイプラインで Amazon S3 のデータ にリアルタイムでアクセスできます。

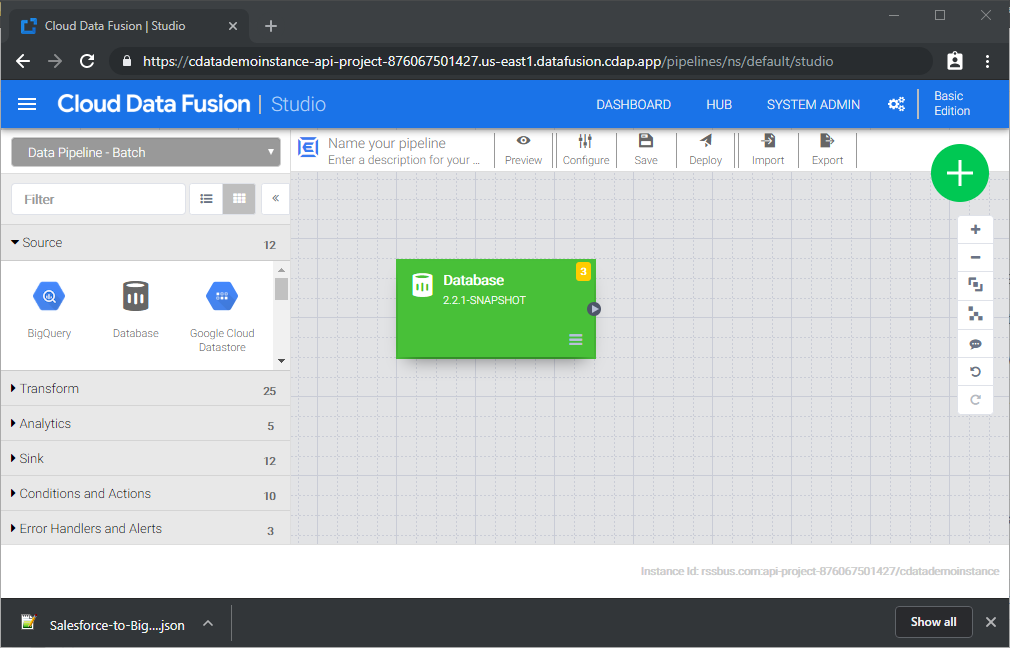

- Pipeline Studio に移動して、新しいパイプラインを作成します

- "Source" オプションから "Database" をクリックして、JDBC Driver 用のソースを追加します

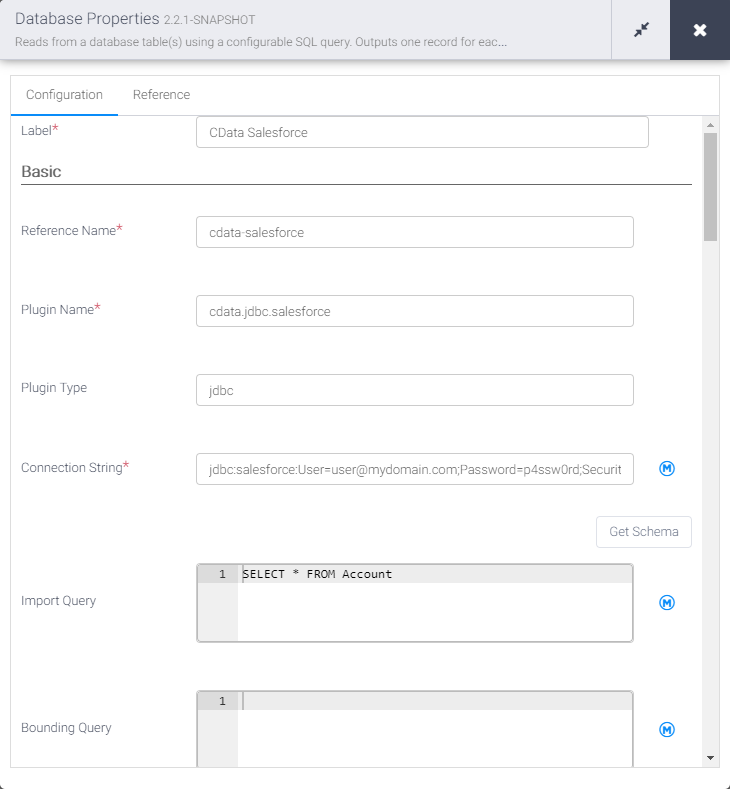

- Database ソースの "Properties" をクリックしてプロパティを編集します

NOTE:Google Data Fusion で JDBC Driver を使用するには、ライセンス(製品版またはトライアル)とランタイムキー(RTK)が必要です。ライセンス(またはトライアル)の取得については、CData までお問い合わせください。

- Label を設定します

- Reference Name を将来の参照用の値に設定します(例:cdata-amazons3)

- Plugin Type を "jdbc" に設定します

- Connection String を Amazon S3 の JDBC URL に設定します。例:

jdbc:amazons3:RTK=5246...;AccessKey=a123;SecretKey=s123;Amazon S3 リクエストを認可するには、管理者アカウントまたはカスタム権限を持つIAM ユーザーの認証情報を入力します。AccessKey をアクセスキーID に設定します。SecretKey をシークレットアクセスキーに設定します。

Note: AWS アカウント管理者として接続できますが、AWS サービスにアクセスするにはIAM ユーザー認証情報を使用することをお勧めします。

尚、CData 製品はAmazon S3 のファイルの一覧表示やユーザー管理情報の取得用です。S3 に保管されているExcel、CSV、JSON などのファイル内のデータを読み込みたい場合には、Excel Driver、CSV Driver、JSON Driver をご利用ください。

アクセスキーの取得

IAM ユーザーの資格情報を取得するには:

- IAM コンソールにサインインします。

- ナビゲーションペインで「ユーザー」を選択します。

- ユーザーのアクセスキーを作成または管理するには、ユーザーを選択してから「セキュリティ認証情報」タブを選択します。

AWS ルートアカウントの資格情報を取得するには:

- ルートアカウントの資格情報を使用してAWS 管理コンソールにサインインします。

- アカウント名または番号を選択し、表示されたメニューで「My Security Credentials」を選択します。

- 「Continue to Security Credentials」をクリックし、「Access Keys」セクションを展開して、ルートアカウントのアクセスキーを管理または作成します。

AWS ロールとして認証

多くの場合、認証にはAWS ルートユーザーのダイレクトなセキュリティ認証情報ではなく、IAM ロールを使用することをお勧めします。RoleARN を指定することでAWS ロールを代わりに使用できます。これにより、CData 製品は指定されたロールの資格情報を取得しようと試みます。

(すでにEC2 インスタンスなどで接続されているのではなく)AWS に接続している場合は、ロールを引き受けるIAM ユーザーのAccessKey とSecretKey を追加で指定する必要があります。AWS ルートユーザーのAccessKey および SecretKey を指定する場合、ロールは使用できません。

SSO 認証

SSO 認証を必要とするユーザーおよびロールには、RoleARN およびPrincipalArn 接続プロパティを指定してください。各Identity Provider に固有のSSOProperties を指定し、AccessKey とSecretKey を空のままにする必要があります。これにより、CData 製品は一時的な認証資格情報を取得するために、リクエストでSSO 認証情報を送信します。

ビルトイン接続文字列デザイナー

JDBC URL の作成には、Amazon S3 JDBC Driver に組み込まれている接続文字列デザイナーを使用できます。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行してください。

java -jar cdata.jdbc.amazons3.jar接続プロパティを入力し、接続文字列をクリップボードにコピーします。

- Import Query を Amazon S3 から取得したいデータを抽出する SQL クエリに設定します。例:

SELECT * FROM ObjectsACL

- "Sink" タブから、同期先シンクを追加します(この例では Google BigQuery を使用します)

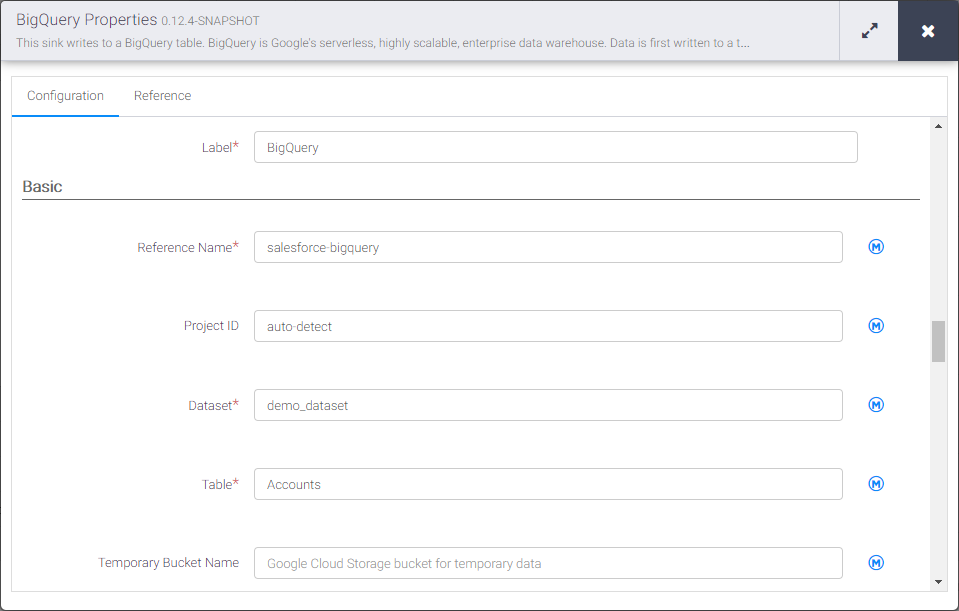

- BigQuery シンクの "Properties" をクリックしてプロパティを編集します

- Label を設定します

- Reference Name を amazons3-bigquery のような値に設定します

- Project ID を特定の Google BigQuery プロジェクト ID に設定します(またはデフォルトの "auto-detect" のままにします)

- Dataset を特定の Google BigQuery データセットに設定します

- Table を Amazon S3 のデータ を挿入するテーブル名に設定します

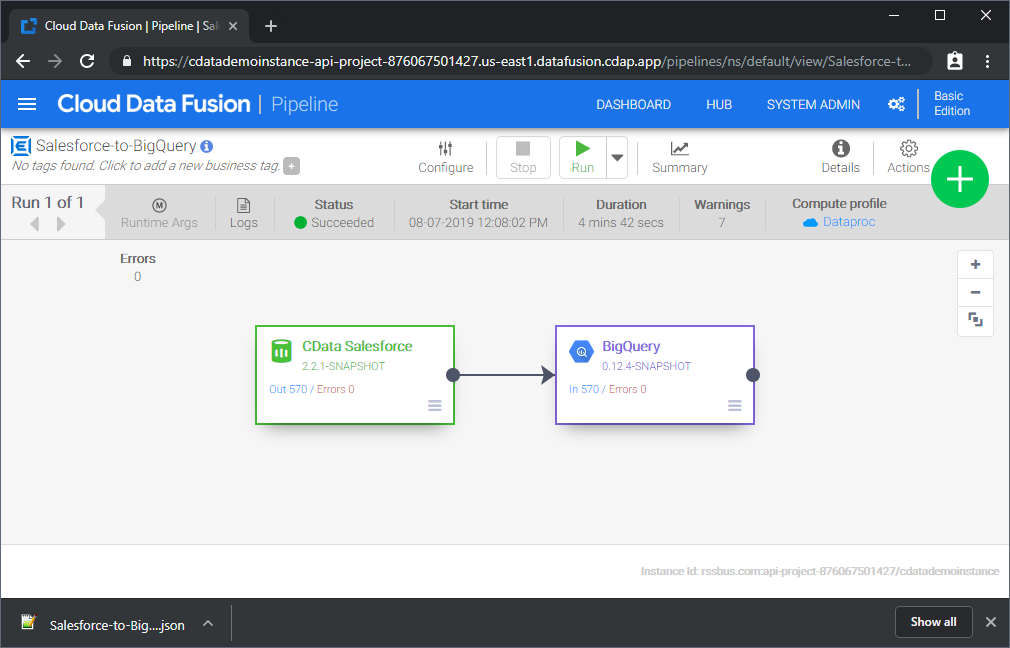

Source と Sink を設定すると、Amazon S3 のデータ を Google BigQuery にパイプする準備が整います。パイプラインを保存してデプロイしてください。パイプラインを実行すると、Google Data Fusion が Amazon S3 からリアルタイムデータをリクエストし、Google BigQuery にインポートします。

これはシンプルなパイプラインの例ですが、変換、分析、条件などを使用してより複雑な Amazon S3 パイプラインを作成できます。CData JDBC Driver for Amazon S3 の 30日間の無償トライアルをダウンロードして、今すぐ Google Data Fusion で Amazon S3 のデータ をリアルタイムで活用しましょう。