Apache Spark でAcumatica のデータをSQL で操作する方法

Apache Spark は大規模データ処理のための高速エンジンです。CData JDBC Driver for Acumatica と組み合わせると、Spark はリアルタイムでAcumatica のデータに連携して処理ができます。本記事では、Spark シェルに接続してAcumatica をクエリする方法について解説します。

CData JDBC Driver は、最適化されたデータ処理がドライバーに組み込まれているため、リアルタイムAcumatica と対話するための高いパフォーマンスを提供します。Acumatica に複雑なSQL クエリを発行すると、ドライバーはフィルタや集計など、サポートされているSQL操作を直接Acumatica にプッシュし、組込みSQL エンジンを使用してサポートされていない操作(SQL 関数やJOIN 操作)をクライアント側で処理します。組み込みの動的メタデータクエリを使用すると、ネイティブデータ型を使用してAcumatica を操作して分析できます。

CData JDBC Driver for Acumatica をインストール

まずは、本記事右側のサイドバーからAcumatica JDBC Driver の無償トライアルをダウンロード・インストールしてください。30日間無償で、製品版の全機能が使用できます。

Spark Shell を起動してAcumatica のデータに接続

- ターミナルを開き、Spark shell でCData JDBC Driver for Acumatica JAR file をjars パラメータに設定します:

$ spark-shell --jars /CData/CData JDBC Driver for Acumatica/lib/cdata.jdbc.acumatica.jar

- Shell でJDBC URL を使ってAcumatica に接続し、SQL Context load() function でテーブルを読み込みます。

Acumatica 接続プロパティの取得・設定方法

Acumatica への接続

Acumatica データソースに接続するには、次の接続プロパティを指定する必要があります。

- URL:(必須)Acumatica ERP インスタンスのベースURL。例:https://domain.acumatica.com/。

- Schema:(オプション)異なるデータを含む2つのスキーマがあります。デフォルトはREST で、Acumatica REST コントラクトベースのAPI を使用し、OData スキーマはAcumatica OData API を使用します。OData スキーマはAcumatica Generic Inquiries へのクエリに使用されます。

- Company:(一部必須)会社名またはテナント名に設定。Schema がOData に設定されている場合は必須です。

- EndpointVersion:(オプション)Web Services エンドポイントのバージョン。例:24.200.001。これはREST スキーマにのみ適用されます。

- EndpointName:(オプション)Web Services エンドポイントの名前。例:Default。これはREST スキーマにのみ適用されます。

Acumatica への認証

Acumatica データソースへの接続に使用できる認証方法は2つあります。Basic およびOAuth です。 Basic 認証では、AuthScheme をBasic に設定し、User とPassword をログイン資格情報に設定します。 OAuth 認証については、ヘルプドキュメントの「接続の確立」セクションにある「OAuth」を参照してください。

組み込みの接続文字列デザイナー

JDBC 接続文字列URL の作成には、Acumatica JDBC Driver にビルトインされたデザイナを使用できます。JAR ファイルをダブルクリックするか、コマンドラインでJAR ファイルを実行するとデザイナが開きます。

java -jar cdata.jdbc.acumatica.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

scala> val acumatica_df = spark.sqlContext.read.format("jdbc").option("url", "jdbc:acumatica:Url = https://try.acumatica.com/ISV/;EndpointName=Default;EndpointVersion=24.200.001;User=user;Password=password;Company=CompanyName;").option("dbtable","Events").option("driver","cdata.jdbc.acumatica.AcumaticaDriver").load() - 接続が完了し、データがロードされたら、テーブルスキーマが表示されます。

Acumatica をテンポラリーテーブルとして登録します:

scala> acumatica_df.registerTable("events")-

データに対して、次のようなカスタムSQL クエリを実行します。

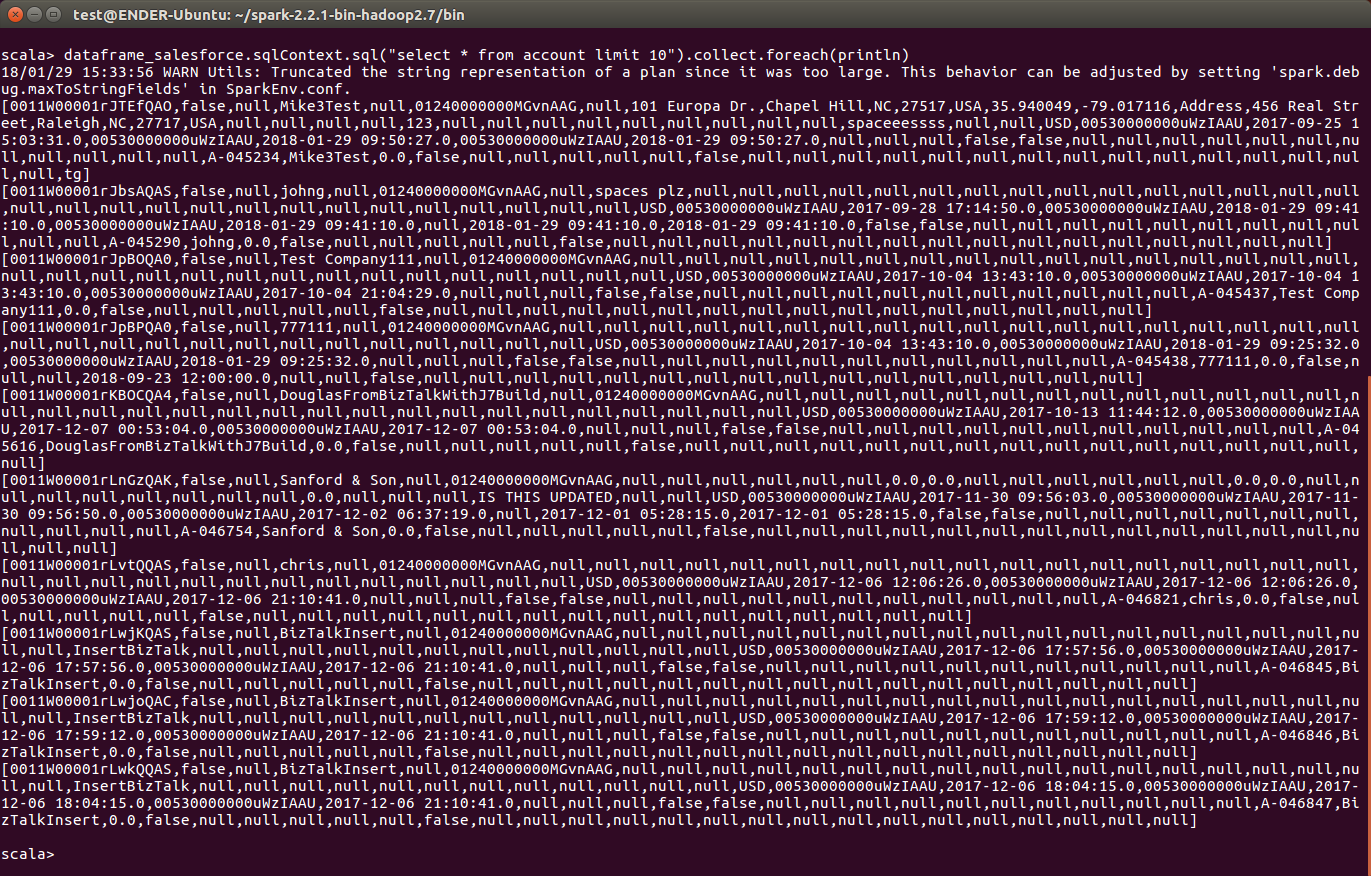

scala> acumatica_df.sqlContext.sql("SELECT Id, location_displayname FROM Events WHERE Id = 1").collect.foreach(println)コンソールで、次のようなAcumatica のデータを取得できました!これでAcumatica との連携は完了です。

CData JDBC Driver for Acumatica をApache Spark で使って、Acumatica に対して、複雑かつハイパフォーマンスなクエリを実行できます。30日の無償評価版 をダウンロードしてぜひお試しください。